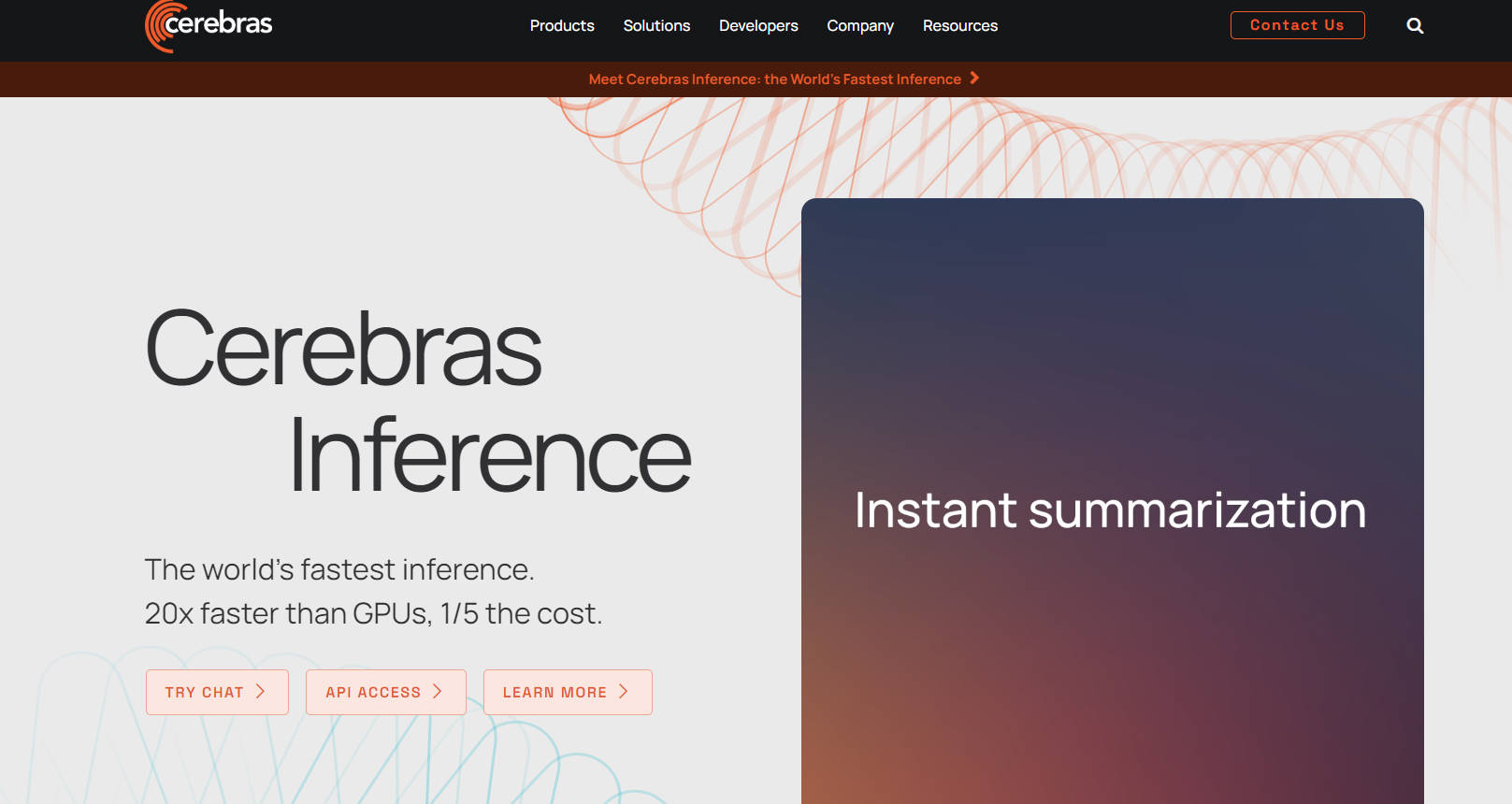

What is Cerebras Inference?

인공지능 효율성을 혁신하는 Cerebras Inference는 GPU보다 20배 빠른 속도와 5분의 1의 비용으로 타의 추종을 불허합니다. AI 기능을 재정의하는 수상 경력에 빛나는 기술을 갖춘 이 최고의 솔루션은 모델 학습을 전례 없는 수준으로 가속화합니다. 900,000개의 코어와 44GB의 온칩 메모리를 갖춘 CS-3 시스템은 여러 컴퓨팅 분야에서 성능 한계를 뛰어넘습니다. Cerebras는 AI를 과학에서 전략으로 끌어올려 경계를 허물고 복잡한 AI 프로젝트를 보다 접근 가능하고 비용 효율적으로 만듭니다.

주요 기능:

초고속 추론 속도: Cerebras Inference는 탁월한 GPU 속도의 20배에 달하는 번개 같은 계산을 제공하여 대량의 시간에 민감한 애플리케이션을 변화시킵니다.

비용 효율적인 AI 처리: GPU 대안의 1/5 비용으로 효율성을 달성하여 고급 AI 기술에 대한 접근성을 민주화합니다.

CS-3를 통한 확장 가능한 컴퓨팅: 900,000개의 코어와 44GB의 온칩 메모리를 활용하여 탁월한 데이터 처리를 수행하여 고성능 컴퓨팅 작업에 뛰어난 성능을 제공합니다.

기반 모델 및 미세 조정 모델: Llama 3.1, Llama 2 및 의료 및 코딩 애플리케이션을 위한 전문 모델과 같은 사용할 준비가 된 모델 모음을 통해 AI 기능을 확장합니다.

원활한 통합: 모델 개발 및 배포 전반에 걸쳐 전문가 지원을 통해 의료, 생명 과학, 에너지 등에서 AI 모델 학습 및 추론을 용이하게 합니다.

사용 사례:

의료 및 생명 과학: 게놈학 및 프로테오믹스 분야의 연구 돌파구를 가속화하여 신속한 신약 개발 및 개인 맞춤형 의학을 가능하게 합니다.

슈퍼컴퓨터 애플리케이션: 지진 처리 및 몬테카를로 시뮬레이션의 실행 시간을 며칠에서 몇 시간으로 단축하여 고성능 컴퓨팅에서 리소스 활용을 최적화합니다.

다국어 AI 어시스턴트: 다국어 챗봇을 위한 언어 모델을 개발 및 배포하여 글로벌 시장에서 고객 참여 및 지원을 향상시킵니다.

결론:

Cerebras Inference는 의료 및 제약에서 에너지 및 과학 컴퓨팅에 이르기까지 다양한 분야를 변화시키는 AI 가속의 정점을 나타냅니다. 이 기술은 모델 학습 시간과 비용을 크게 줄임으로써 AI 접근성을 민주화하여 모든 규모의 조직이 AI의 잠재력을 최대한 활용할 수 있도록 지원합니다. 오늘 AI의 미래에 합류하고 새로운 가능성을 열어보세요.

FAQ:

Cerebras Inference를 다른 AI 추론 솔루션과 차별화하는 요소는 무엇입니까?

Cerebras Inference는 전례 없는 속도와 비용 효율성을 제공하여 다양한 산업 분야에서 고성능 컴퓨팅과 복잡한 AI 애플리케이션에 이상적인 세계에서 가장 빠르고 경제적인 AI 추론 솔루션입니다.

Cerebras Inference를 기존 AI 모델과 통합할 수 있습니까?

물론입니다. Cerebras는 사용할 준비가 된 기반 모델 및 미세 조정 모델 모음과 함께 특정 요구 사항에 맞게 모델을 맞춤 학습하는 서비스를 제공하여 원활한 통합 및 최적화를 보장합니다.

Cerebras Inference가 탁월한 특정 산업 또는 사용 사례가 있습니까?

Cerebras Inference는 신약 개발 및 개인 맞춤형 의학을 가속화하는 의료 및 제약 분야와 지진 처리 및 몬테카를로 시뮬레이션과 같은 작업을 통해 계산 시간을 크게 단축하는 슈퍼컴퓨팅 분야에서 뛰어난 성능을 발휘합니다.

More information on Cerebras Inference

Top 5 Countries

Traffic Sources

Cerebras Inference 대안

Cerebras Inference 대안-

-

우리 플랫폼으로 머신 러닝 모델을 손쉽게 배포하세요. 서버리스 GPU를 통해 AWS나 GCP에 비해 40% 이상의 비용을 절약하세요. 파이썬 코드만 가져오세요. 나머지는 전부 저희가 처리할게요!

-

최첨단 오픈소스 모델을 사용하거나, Fireworks.ai를 통해 추가 비용 없이 자신만의 모델을 미세 조정하고 배포하세요.

-

Cognitora: 자율 AI 에이전트만을 위해 구축된 클라우드 플랫폼. 귀하의 AI 코드와 지능형 워크로드를 안전하고 초고속으로 실행하세요.

-

CoreWeave는 업계에서 가장 빠르고 유연한 인프라 위에 대규모 NVIDIA GPU를 제공하는 전문 클라우드 공급자입니다.