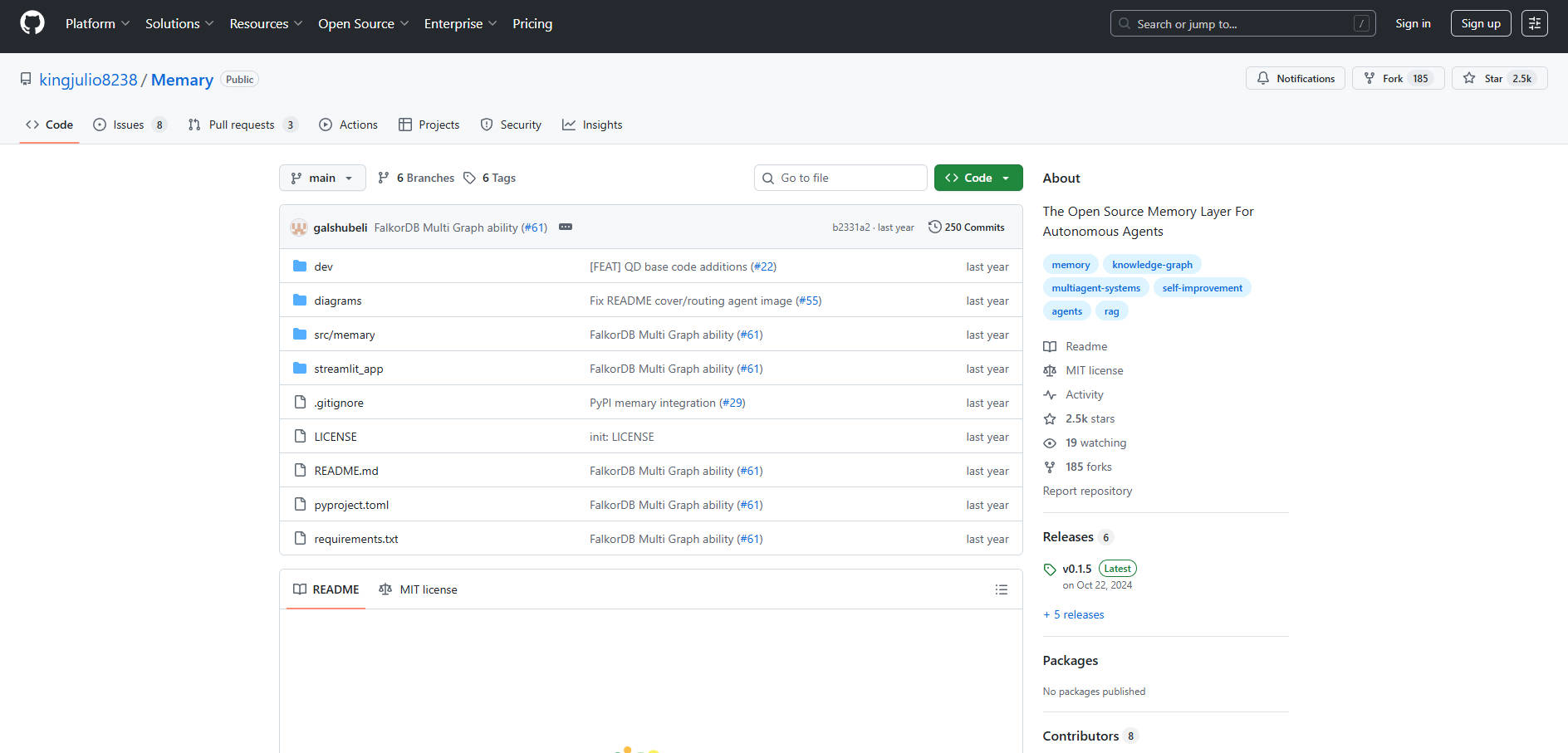

What is Memary ?

memaryは、AIエージェントに永続的で人間のような記憶構造を付与するために開発された、堅牢なPythonライブラリです。これにより、エージェントの推論能力と長期的な文脈維持能力を根本的に向上させます。短期的なLLMのコンテキストウィンドウという根本的な制限に対し、高度な知識管理モジュールと記憶分析モジュールを統合することで対応します。高度でパーソナライズされた、真に文脈を理解するAIエージェントを構築する開発者やエンジニア向けに設計されたmemaryは、学習し進化するインテリジェントなシステムを構築するための不可欠な基盤を提供します。

主な機能

memaryは、既存のエージェントアーキテクチャ(OllamaやOpenAI経由のモデルをサポート)にシームレスに統合され、深く分析的な記憶機能を提供します。

🧠 統合されたナレッジグラフ(KG)管理

memaryは、専用のグラフデータベース(例:FalkorDB)を利用して知識を保存し、エージェントが単純な逐次記憶の範囲を超えて機能することを可能にします。再帰的な検索アプローチを採用しており、クエリ内の主要なエンティティを特定し、ローカライズされたサブグラフを構築し、そのコンテキストを使用して正確な応答を生成します。この手法により、ナレッジグラフ全体を検索する場合と比較して、レイテンシを大幅に削減します。

📈 デュアルメモリモジュール:ストリームとストア

システムは、人間の認知機能を模倣し、記憶を2つの補完的なコンポーネントに分割します。

メモリストリーム:すべてのエンティティとそのタイムスタンプを捕捉し、曝露と相互作用の広範なタイムラインを提供します。これにより、ユーザーの興味の変化を追跡するためのタイムライン分析が可能になります。

エンティティ知識ストア:エンティティ参照の頻度と新近性を追跡します。これらの要因に基づいてエンティティをランク付けすることで、ストアはユーザーの知識の深さと特定の概念への習熟度を反映し、高度にパーソナライズされた応答を可能にします。

⚙️ 自動的な記憶生成とシステム改善

memaryは一度初期化されると、エージェントが対話するにつれてその記憶構造を自動的に更新し、開発者のさらなる介入なしに関連するすべての記憶を捕捉します。この絶え間なく進化するフィードバックループは、人間の記憶が時間とともに学習する様子を模倣しており、エージェントの継続的な改善への明確な道筋を提供します。

🧩 柔軟なモデルとツールのサポート

開発者は基盤となるモデルを完全に制御できます。memaryは、Ollama経由で実行されるローカルモデル(Llama 3、LLaVAを推奨)やリモートサービス(GPT-3.5-turbo、GPT-4-vision-preview)をサポートします。さらに、カスタムの外部ツール(例:検索、ビジョン、株価)をエージェントに簡単に追加または削除して、その機能能力を拡張できます。

👥 マルチエージェントおよびマルチグラフのコンテキストスイッチング

FalkorDBのようなグラフデータベースを利用する場合、memaryは複数の異なるエージェントの作成と管理を可能にし、それぞれがユニークなナレッジグラフIDに対応します。この機能は、パーソナライズされたコンテキストを管理する必要がある開発者にとって不可欠であり、異なるユーザーペルソナやプロジェクト間でのシームレスな移行を、記憶の混同なく実現します。

ユースケース

memaryは、文脈の深さ、パーソナライズ、および長期記憶がユーザーエクスペリエンスにとって重要となるシナリオ向けに設計されています。

パーソナライズされた研究アシスタントの開発:収集された事実だけでなく、ユーザー固有の研究方法論、好みの情報源、以前の結論を記憶するエージェントを構築します。エンティティ知識ストアは、エージェントが最近または頻繁に参照されたトピックを優先し、進行中のプロジェクトに非常に適切なコンテキストを提供することを保証します。

個別ユーザーペルソナのスケーリングと管理:複数の異なるユーザーをサポートするプラットフォームの場合、マルチグラフ機能を利用して、各ユーザーIDにユニークな記憶構造を割り当てます。これにより、ユーザーAの個人的な好み、チャット履歴、知識ベースがユーザーBのものと完全に分離され、大規模な真のパーソナライズが可能になります。

会話の明確さと効率性の向上:memaryの記憶圧縮技術を適用して、LLMのコンテキストウィンドウを効果的に管理します。過去の会話を要約し、エージェントの応答とともに最も関連性の高いエンティティのみを挿入することで、過度なトークン使用や焦点の喪失なしに、エージェントが長期的なコンテキストを維持することを保証します。

memaryを選ぶ理由

memaryは、標準的なベクトルデータベース検索システムとは一線を画す独自のアーキテクチャ上の利点を提供し、開発者にとって真の情報獲得を可能にします。

マルチホップ推論による検索の高速化:複雑なクエリが複数の主要なエンティティに関わる場合、memaryはマルチホップ推論を使用して、複数の関連するサブグラフを結合します。このインテリジェントな走査により、エージェントは複雑で相互に関連する質問に迅速かつ正確に答えることができ、これは標準的なシングルパス検索ではしばしば対応が難しい能力です。

深い文脈的洞察:単純なチャット履歴の保存とは異なり、memaryのメモリモジュールは、分析機能(タイムライン、頻度、新近性分析)を実行して、ユーザーの知識と好みを推論します。これにより、エージェントはユーザーの専門知識レベルと現在の興味に合わせて、より正確に応答を調整できます。

統合のために設計:memaryは、最小限の実装労力という原則に基づいて構築されています。既存のエージェントフレームワークに統合され、現在はデモンストレーション用にシンプルなReActエージェントの実装を提供していますが、その将来の設計は、あらゆるプロバイダーのあらゆるタイプのエージェントをサポートすることに焦点を当てています。

結論

構造化され、分析的で、永続的な記憶フレームワークを提供することで、memaryは開発者がステートレスなAIエージェントの限界を超越することを可能にします。これにより、アプリケーションが深いコンテキストを維持し、対話から学習し、パーソナライズされた洞察に富む体験を提供できるようになります。

今すぐmemaryがあなたのAIエージェントを真にインテリジェントで信頼できるパートナーに変える方法を探ってみましょう。

More information on Memary

Memary 代替ソフト

もっと見る 代替ソフト-

-

AIの『物忘れ』を解消! MemMachineが、AIエージェントに長期的な適応型メモリを提供します。 パーソナライズされ、文脈を認識するAIのために、オープンソースでモデル非依存です。

-

-

Supermemoryは、お使いのLLMに長期記憶をもたらします。ステートレスなテキスト生成とは異なり、LLMはあなたのファイル、チャット、ツールから関連性の高い事実を想起し、一貫性があり、文脈に即し、そしてパーソナルな応答を実現します。

-

MemoryGraph gives your AI assistants persistent memory. Store solutions, track patterns, recall context across sessions. Zero config, local-first, privacy by default.