What is Reka Flash 3?

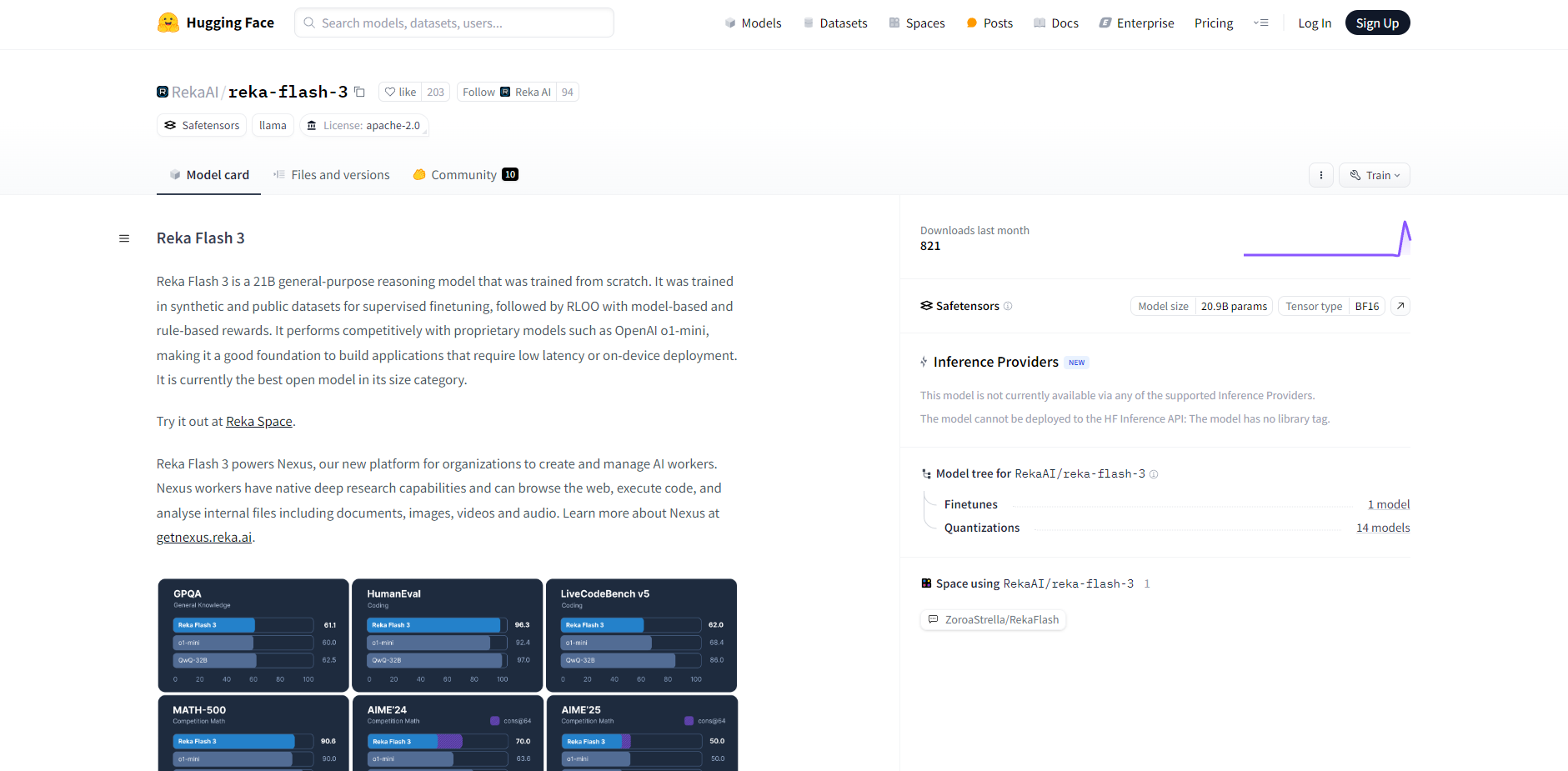

Reka Flash 3 は、210億のパラメータを持つ汎用推論モデルであり、速度と効率が求められるアプリケーションのために設計されています。完全にゼロからトレーニングされており、パフォーマンスとリソース利用のバランスに優れているため、低遅延またはオンデバイスでの動作が重要なデプロイメントに最適です。同規模のオープンモデルの中で、最高のソリューションと言えるでしょう。

主な特徴:

🤖 最適化されたアーキテクチャ: 高速な推論のために構築された Reka Flash 3 は、OpenAI の o1-mini のようなモデルに匹敵する性能を発揮し、応答時間を最小限に抑えます。

⚙️ 効率的なトレーニング: このモデルは、教師ありファイン・チューニングのために合成データと公開データセットを組み合わせて開発され、その後、モデルベースおよびルールベースの報酬を用いた RLOO(オフライン最適化からの強化学習)が行われました。

💻 柔軟なデプロイメント: Llama互換形式でリリースされた Reka Flash 3 は、Hugging Face Transformers や vLLM のような一般的なライブラリとシームレスに統合できます。

🗣️ 構造化プロンプト: 一貫性のある予測可能なインタラクションのために、明確なプロンプト形式(

human: ... <sep> assistant: ... <sep>)を持つcl100k_baseトークナイザーを利用します。🧠 制御された推論: 明示的な開始/終了タグを持つ「思考」プロセスを備えており、計算リソースを管理し、応答生成時間を制御するための予算強制を可能にします。

技術詳細:

モデルサイズ: 210億パラメータ

トークナイザー:

cl100k_baseプロンプトセパレーター:

<sep>テキスト終了トークン:

<|endoftext|>主な言語: 英語(多言語対応機能も一部あり)

トレーニング: 合成データと公開データセット、RLOO

ユースケース:

リアルタイムチャットボット: Reka Flash 3 の低遅延性を活用して、迅速なフィードバックを提供する、顧客サービスやインタラクティブなアプリケーション向けの応答性が高くインテリジェントなチャットボットをデプロイします。

オンデバイスAIアシスタント: Reka Flash 3 をモバイルアプリケーションまたは組み込みシステムに統合して、常にクラウド接続に依存することなく、自然言語処理機能を有効にします。

迅速なプロトタイピング: Reka Flash 3 の容易なデプロイメントと効率的なパフォーマンスを利用して、AI 搭載の機能やアプリケーションを迅速に構築およびテストします。たとえば、Nexus プラットフォーム内のカスタム AI ワーカーの中核として使用し、推論と応答生成によってこれらのエージェントを強化できます。

結論:

Reka Flash 3 は、高性能なオープンソース推論モデルを求める開発者にとって、強力かつ効率的なソリューションを提供します。最適化されたアーキテクチャ、柔軟なデプロイメントオプション、および制御された推論機能により、速度とリソース管理が最も重要な幅広いアプリケーションにとって価値のあるツールとなります。

More information on Reka Flash 3

Reka Flash 3 代替ソフト

もっと見る 代替ソフト-

LongCat-Flashが、エージェントタスク向けに強力なAIの力を解き放ちます。オープンソースのMoE LLMは、圧倒的なパフォーマンスと、費用対効果に優れた超高速推論を実現します。

-

DeepCoder:64KコンテキストコードAI。オープンソースの14Bモデルが期待を上回る性能を発揮!長文コンテキスト、RL(強化学習)トレーニング、トップレベルのパフォーマンス。

-

-

LG AI ResearchのEXAONE 3.5を発見しましょう。パラメータ数が24億から320億までの、英語と韓国語のバイリンガルの命令微調整済み生成モデルのセットです。最大32Kトークンの長文コンテキストをサポートし、実世界のシナリオで一流の性能を発揮します。

-

深層推論モデルDeepSeek-R1は、強化学習(RL)によって強化された最先端技術であり、数学、コーディング、推論タスクにおいてベンチマークを上回ります。オープンソースでAI駆動です。