What is Reka Flash 3?

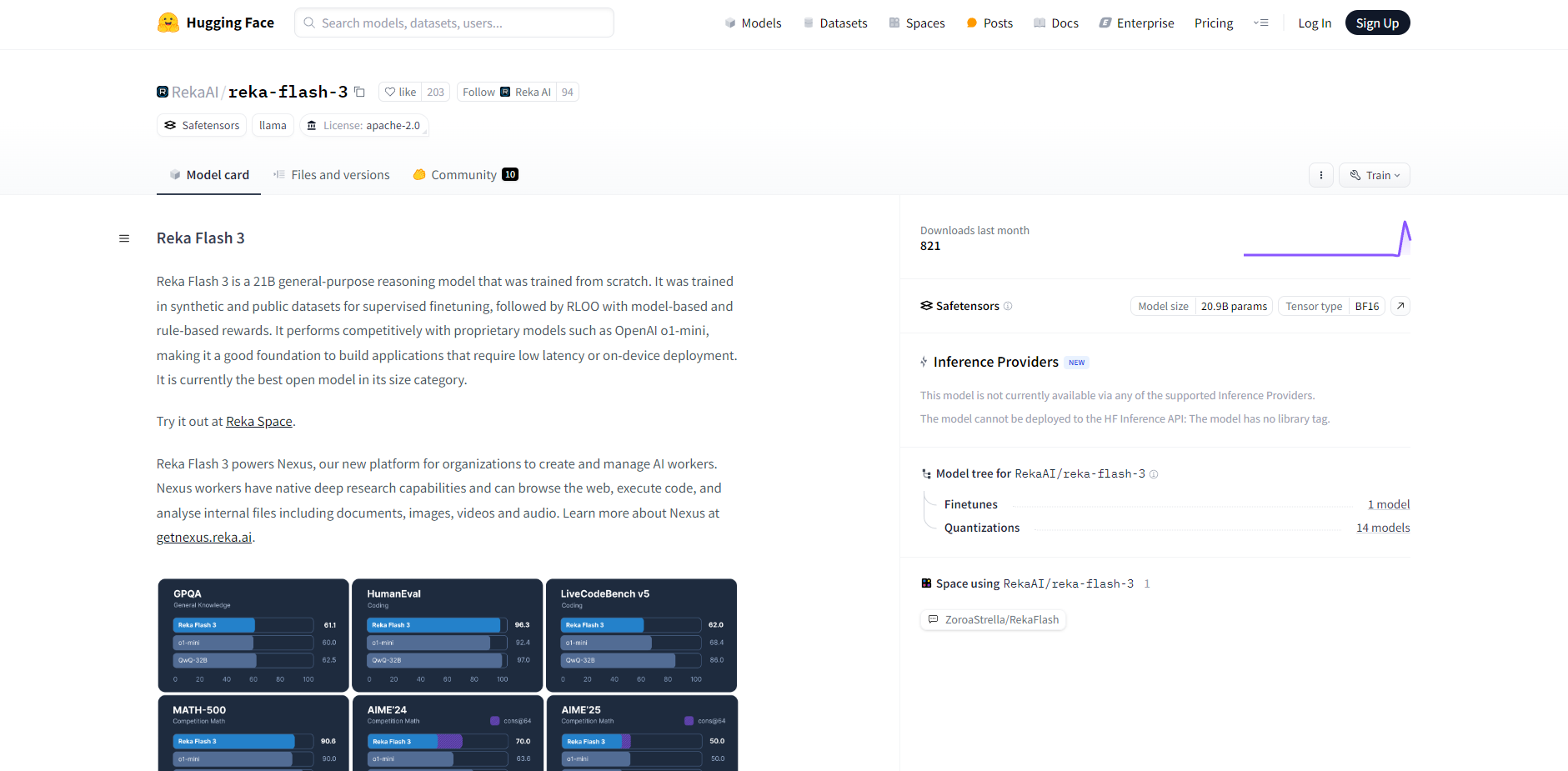

Reka Flash 3는 210억 개의 파라미터를 가진 범용 추론 모델로, 속도와 효율성이 중요한 애플리케이션을 위해 설계되었습니다. 처음부터 훈련된 이 모델은 뛰어난 성능과 리소스 활용의 균형을 제공하여 낮은 지연 시간 또는 온디바이스 작동이 중요한 배포에 이상적입니다. 이는 유사한 규모의 오픈 모델 중에서 최고 수준의 솔루션을 나타냅니다.

주요 기능:

🤖 최적화된 아키텍처: 빠른 추론을 위해 구축된 Reka Flash 3는 OpenAI의 o1-mini와 같은 모델과 경쟁력 있는 성능을 제공하여 응답 시간을 최소화합니다.

⚙️ 효율적인 훈련: 이 모델은 지도 학습을 위한 합성 및 공개 데이터 세트의 조합과 모델 기반 및 규칙 기반 보상을 사용한 RLOO(Reinforcement Learning from Offline Optimization, 오프라인 최적화로부터의 강화 학습)를 사용하여 개발되었습니다.

💻 유연한 배포: Llama 호환 형식으로 출시된 Reka Flash 3는 Hugging Face Transformers 및 vLLM과 같은 널리 사용되는 라이브러리와 원활하게 통합됩니다.

🗣️ 구조화된 프롬프트: 일관되고 예측 가능한 상호 작용을 위해 명확한 프롬프트 형식(

human: ... <sep> assistant: ... <sep>)과 함께cl100k_base토크나이저를 활용합니다.🧠 제어된 추론: 명시적인 시작/종료 태그가 있는 "사고" 프로세스를 특징으로 하여 계산 리소스를 관리하고 응답 생성 시간을 제어하기 위한 예산 강제(budget forcing)가 가능합니다.

기술 세부 정보:

모델 크기: 210억 개의 파라미터

토크나이저:

cl100k_base프롬프트 분리 기호:

<sep>텍스트 종료 토큰:

<|endoftext|>주요 언어: 영어 (일부 다국어 기능 포함)

훈련: 합성 및 공개 데이터 세트, RLOO

사용 사례:

실시간 챗봇: Reka Flash 3의 낮은 지연 시간을 활용하여 즉각적인 피드백을 제공함으로써 고객 서비스 또는 대화형 애플리케이션을 위한 응답성이 뛰어나고 지능적인 챗봇을 배포합니다.

온디바이스 AI 어시스턴트: Reka Flash 3를 모바일 애플리케이션 또는 임베디드 시스템에 통합하여 지속적인 클라우드 연결에 의존하지 않고도 자연어 처리 기능을 사용할 수 있도록 합니다.

신속한 프로토타입 제작: Reka Flash 3의 쉬운 배포 및 효율적인 성능을 활용하여 AI 기반 기능 및 애플리케이션을 신속하게 구축하고 테스트합니다. 예를 들어 Nexus 플랫폼 내에서 맞춤형 AI 작업자의 핵심으로 사용하여 추론 및 응답 생성 기능을 향상시킬 수 있습니다.

결론:

Reka Flash 3는 고성능의 오픈 소스 추론 모델을 찾는 개발자에게 강력하면서도 효율적인 솔루션을 제공합니다. 최적화된 아키텍처, 유연한 배포 옵션 및 제어된 추론 기능을 통해 속도 및 리소스 관리가 중요한 광범위한 애플리케이션에 유용한 도구입니다.

More information on Reka Flash 3

Reka Flash 3 대체품

더보기 대체품-

LongCat-Flash와 함께 에이전트 작업을 위한 강력한 AI를 마음껏 활용하세요. 오픈소스 MoE LLM은 비할 데 없는 성능은 물론, 비용 효율적이면서도 초고속 추론을 제공합니다.

-

DeepCoder: 64K 컨텍스트 코드 AI. 오픈 소스 14B 모델, 예상을 뛰어넘는 성능! 긴 컨텍스트, RL 트레이닝, 최고의 성능.

-

-

LG AI Research의 EXAONE 3.5를 발견하세요. 24억에서 320억 파라미터까지의 쌍어(영어 및 한국어) 명령어 튜닝 생성형 모델 세트입니다. 최대 32K 토큰의 장문 컨텍스트를 지원하며, 실제 시나리오에서 최고 수준의 성능을 발휘합니다.

-

RL 기반의 최첨단 추론 모델인 DeepSeek-R1을 경험해보세요. 수학, 코딩, 추론 과제에서 기준점을 뛰어넘는 성능을 자랑합니다. 오픈소스이며 AI 기반입니다.