What is XVERSE-MoE-A36B?

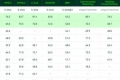

深センUnimancy Technology社のXVERSE-MoE-A36Bは、Mixture-of-Experts(MoE)アーキテクチャに基づいた、画期的な多言語大型言語モデルです。総計25540億パラメータ、3600億活性化パラメータを備え、トレーニング時間を30%削減し、推論速度を100%向上させる画期的なパフォーマンス向上を実現しています。このモデルの革新的なMoE構造は、従来のスケーリング則を凌駕するだけでなく、トークンあたりのコストを大幅に削減することで、より低コストでAIの幅広い展開を可能にします。

主な機能:

高度なMoEアーキテクチャ: XVERSE-MoE-A36Bは、効率的な計算のために、共有エキスパートと非共有エキスパートの両方を組み込んだ、細粒度のエキスパートを備えたデコーダーのみのトランスフォーマーを使用しています。

多様なトレーニングデータ: このモデルは、40以上の言語にわたる膨大で多様なデータセットでトレーニングされており、中国語と英語での最適なパフォーマンスのために慎重にバランスが取られており、他の言語も考慮されています。

動的データ切り替え: トレーニング中に、このモデルは、学習と汎化を強化するために、継続的な高品質なデータ導入と適応的なサンプリング調整を組み込んでいます。

カスタマイズされたトレーニングフレームワーク: このフレームワークは、MoEの独自のルーティングとウェイト計算ロジックに合わせて調整されており、計算効率を最適化し、大規模なメモリと通信の要求に対応します。

無償でオープンソース: このモデルは、Unimancyの「高性能ファミリーバケット」シリーズの一部であり、無償で制限のない商業利用が可能です。

ユースケース:

インタラクティブなストーリーテリング: 現実的なAIロールプレイングと魅力的なオープンエンドの物語のためのSayloのようなアプリを強化し、香港と台湾のエンターテイメントチャートでトップにランクインしています。

コンテンツ作成: QQ MusicやHuaya Liveのようなプラットフォームで、革新的なAI駆動のインタラクティブ機能により、ユーザーエクスペリエンスを向上させています。

言語処理: 長文処理において優れたパフォーマンスを発揮し、広範な言語理解と生成を必要とするアプリケーションに適しています。

結論:

UnimancyのXVERSE-MoE-A36Bは、AIイノベーションの最前線に立ち、さまざまな商業アプリケーションにコスト効率の高い、高性能なソリューションを提供します。それはオープンソースへの貢献における一歩前進であるだけでなく、AIテクノロジーの民主化に向けた飛躍でもあります。今日、あなたのアプリケーションのためにXVERSE-MoE-A36Bの可能性を発見してください。