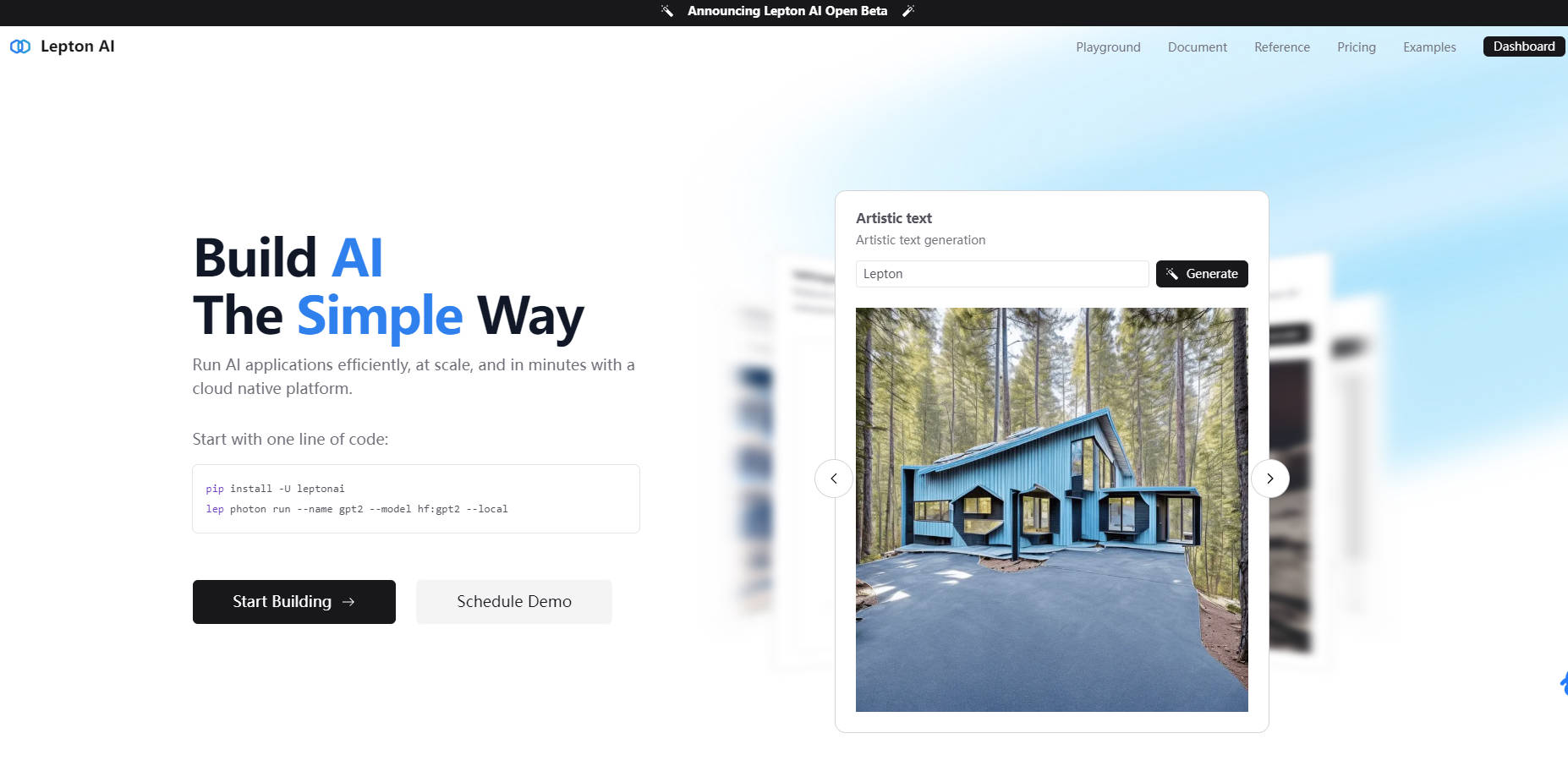

What is Lepton AI?

Lepton AI는 AI 모델의 개발, 학습 및 배포를 간소화하도록 설계된 최고의 AI 클라우드 플랫폼입니다. 최첨단 머신러닝 솔루션을 구축하든 AI 인프라를 확장하든 Lepton은 프로덕션급 성능, 비용 효율성 및 포괄적인 ML 툴을 결합하여 여러분의 요구를 충족합니다. 유연한 GPU 옵션과 엔터프라이즈급 SLA를 통해 Lepton은 여러분이 혁신에 집중할 수 있도록 지원하는 동시에 AI 인프라의 복잡성을 처리합니다.

주요 기능

? 클라우드 플랫폼: 모델 개발, 학습 및 배포를 간소화하는 완벽하게 관리되는 AI 클라우드 플랫폼입니다.

?️ 서버리스 엔드포인트: OpenAI 호환 API를 바로 사용하여 원활한 통합 및 배포가 가능합니다.

? 전용 엔드포인트: 자체 모델과 구성을 배포하기 위한 완벽하게 사용자 지정 가능한 엔드포인트입니다.

? Dev Pod: 관리되는 GPU를 사용하여 대화형 개발 세션을 실행합니다. SSH, Jupyter Notebook 및 VS Code에 적합합니다.

? 배치 작업: 고성능 상호 연결 및 가속화된 스토리지를 사용하여 분산 학습 또는 배치 처리 작업을 실행합니다.

?️ 플랫폼 기능: 서버리스 파일 시스템, 데이터베이스 및 네트워크 도구에 액세스하여 손쉽게 애플리케이션을 구축할 수 있습니다.

? 엔터프라이즈 지원: 엔터프라이즈 사용자를 위한 전용 노드 그룹 및 SOC2/HIPAA 규정 준수를 제공합니다.

Lepton AI를 선택해야 하는 이유

⚡ 성능: Lepton의 빠른 LLM 엔진인 Tuna를 통해 일일 200억 개 이상의 토큰을 100% 가동 시간으로 처리하고 초당 600개 이상의 토큰 속도를 달성합니다.

?️ 확장성: 10,000개 이상의 모델과 LORAs를 동시에 지원하여 매일 100만 개 이상의 이미지를 생성합니다.

? 효율성: DistriFusion을 통해 6배 더 빠른 고해상도 이미지 생성과 스마트 스케줄링 및 최적화된 인프라를 통한 5배의 성능 향상을 제공합니다.

? 글로벌 접근성: 빠른 로컬 배포를 위해 최저 10ms의 시간당 첫 번째 토큰(time-to-first-token)으로 낮은 지연 시간 추론을 제공합니다.

사용 사례

1️⃣ AI 모델 개발: Dev Pod 및 Python SDK를 사용하여 관리되는 클라우드 환경에서 AI 모델을 구축하고 실험합니다.

2️⃣ 엔터프라이즈 AI 배포: 엔터프라이즈 규모의 AI 솔루션을 위해 사용자 지정 가능한 구성을 사용하여 전용 엔드포인트를 배포합니다.

3️⃣ 분산 학습: 가속화된 스토리지 및 고성능 상호 연결을 사용하여 대규모 학습을 위한 배치 작업을 실행합니다.

결론

Lepton AI는 단순한 클라우드 플랫폼 그 이상입니다. 대규모로 AI 모델을 구축, 학습 및 배포하기 위한 완벽한 에코시스템입니다. 탁월한 성능, 안정성 및 사용 편의성을 갖춘 Lepton은 개인과 기업 모두에게 최고의 솔루션입니다.

FAQ

Q: Lepton은 소규모 AI 프로젝트에 적합합니까?

A: 물론입니다! Lepton의 서버리스 엔드포인트와 유연한 GPU 옵션은 모든 규모의 프로젝트에 이상적입니다.

Q: 자체 하드웨어를 사용할 수 있습니까?

A: 네, Lepton은 자체 관리형 노드 그룹을 위한 Bring Your Own Machines (BYOM)을 지원합니다.

Q: Lepton은 어떤 종류의 고객 지원을 제공합니까?

A: Lepton은 엔터프라이즈 SLA를 제공하며, 빠른 지원을 위해 GitHub에서 직접 문제를 제기할 수 있습니다.

Q: Lepton의 LLM 엔진 속도는 얼마나 빠릅니까?

A: Lepton의 최적화된 LLM 엔진인 Tuna는 초당 600개 이상의 토큰 속도를 제공합니다.

지금 바로 Lepton AI로 구축을 시작하고 AI 개발의 미래를 경험하세요! ?