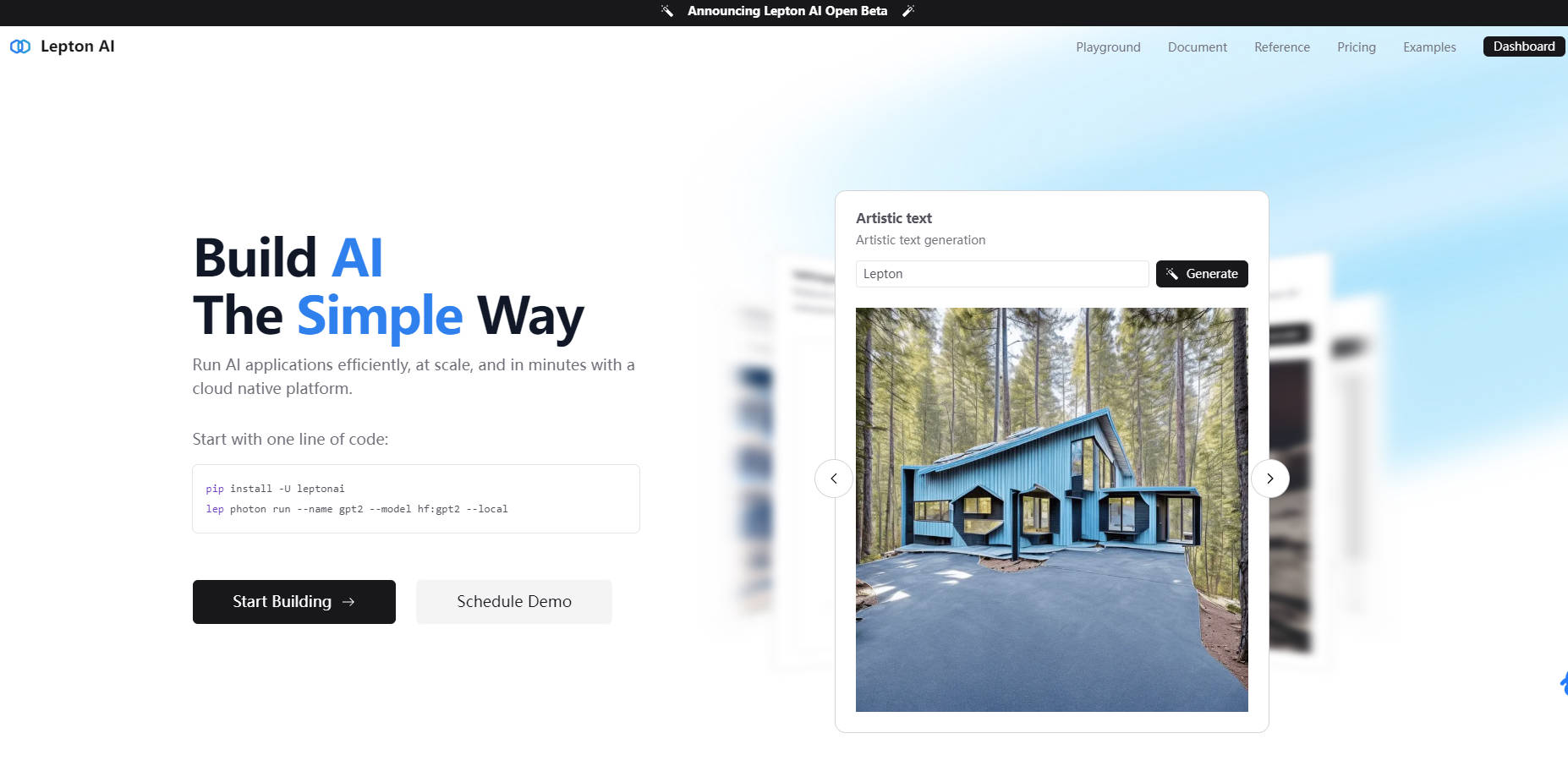

What is Lepton AI?

Lepton AI 是终极的 AI 云平台,旨在简化 AI 模型的开发、训练和部署。无论您是构建尖端的机器学习解决方案,还是扩展您的 AI 基础设施,Lepton 都能结合生产级性能、成本效率和全面的 ML 工具来满足您的需求。凭借灵活的 GPU 选项和企业级 SLA,Lepton 使您能够专注于创新,同时它负责处理 AI 基础设施的复杂性。

关键特性

? 云平台:一个完全托管的 AI 云平台,简化了模型的开发、训练和部署。

?️ 无服务器端点:开箱即用地使用兼容 OpenAI 的 API,实现无缝集成和部署。

? 专用端点:完全可自定义的端点,用于部署您自己的模型和配置。

? 开发 Pod:使用托管的 GPU 运行交互式开发会话——非常适合 SSH、Jupyter Notebook 和 VS Code。

? 批量作业:使用高性能互连和加速存储执行分布式训练或批量处理作业。

?️ 平台特性:访问无服务器文件系统、数据库和网络工具,轻松构建您的应用程序。

? 企业支持:为企业用户提供专用的节点组和 SOC2/HIPAA 合规性。

为什么选择 Lepton AI?

⚡ 性能:每天处理超过 200 亿个 token,100% 的正常运行时间,并使用 Lepton 快速的 LLM 引擎 Tuna 达到每秒 600 多个 token 的速度。

?️ 可扩展性:每天生成超过 100 万张图像,同时支持 10000 多个模型和 LoRA。

? 效率:通过 DistriFusion 将高分辨率图像生成速度提高 6 倍,并通过智能调度和优化的基础设施将性能提升 5 倍。

? 全球覆盖:低延迟推理,首个 token 的时间低至 10 毫秒,实现快速本地部署。

使用案例

1️⃣ AI 模型开发:使用 Dev Pods 和 Python SDK 在托管的云环境中构建和试验 AI 模型。

2️⃣ 企业 AI 部署:部署具有可自定义配置的专用端点,用于企业级 AI 解决方案。

3️⃣ 分布式训练:使用加速存储和高性能互连运行大规模训练的批量作业。

总结

Lepton AI 不仅仅是一个云平台,它是一个完整的生态系统,用于大规模构建、训练和部署 AI 模型。凭借无与伦比的性能、可靠性和易用性,Lepton 成为个人和企业用户的首选解决方案。

常见问题

问:Lepton 是否适合小型 AI 项目?

答:绝对可以!Lepton 的无服务器端点和灵活的 GPU 选项使其成为各种规模项目的理想选择。

问:我可以自带硬件吗?

答:可以,Lepton 支持自带机器 (BYOM) 用于自管理节点组。

问:Lepton 提供什么样的客户支持?

答:Lepton 提供企业级 SLA,您可以在 GitHub 上直接提交问题以获得快速帮助。

问:Lepton 的 LLM 引擎速度有多快?

答:Lepton 优化的 LLM 引擎 Tuna,速度达到每秒 600 多个 token。

立即开始使用 Lepton AI,体验 AI 开发的未来! ?