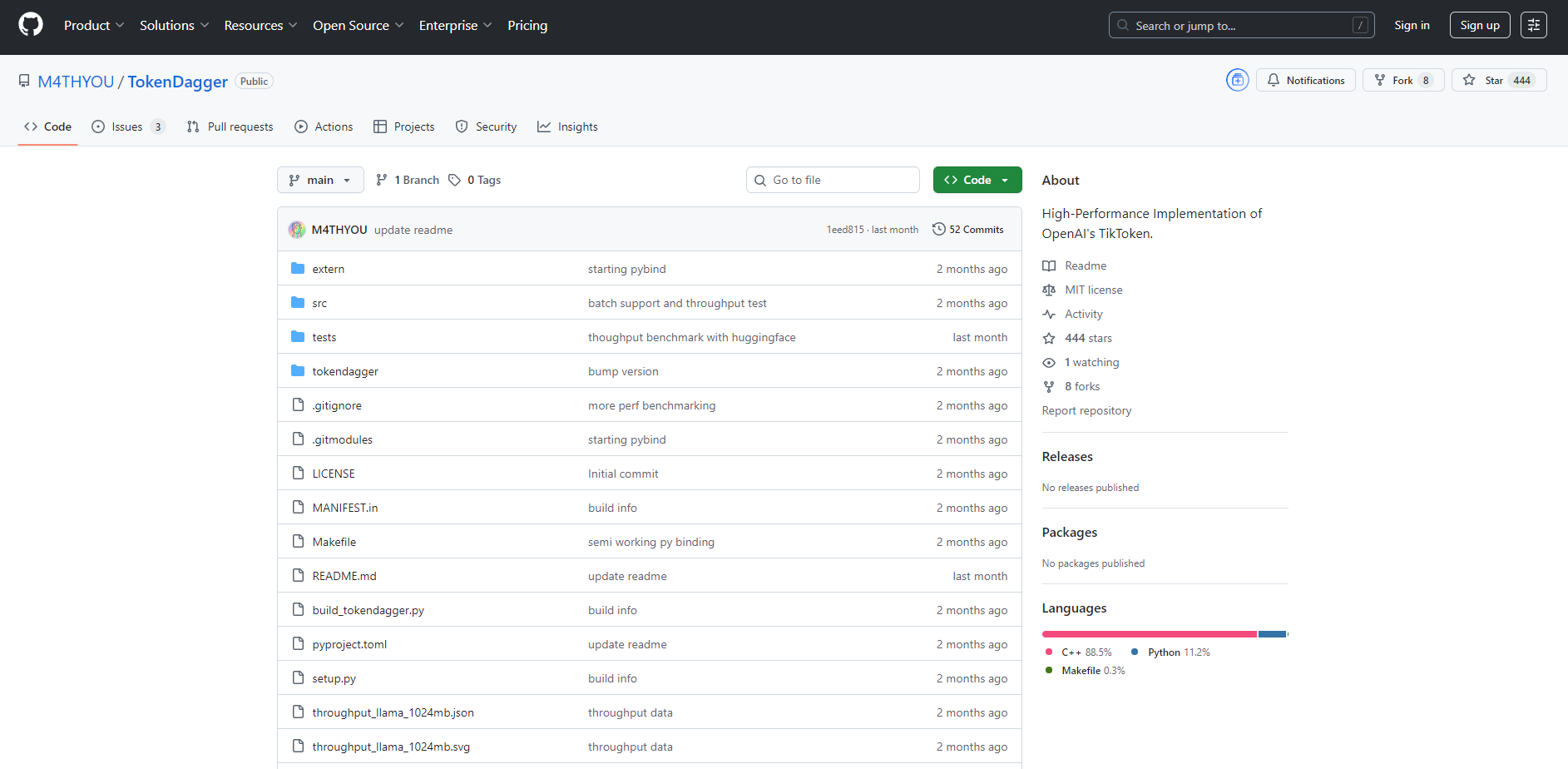

What is TokenDagger?

在现代自然语言处理(NLP)中,高效的分词(tokenization)是至关重要的基础。随着数据集的不断增长和处理需求的日益严苛,像OpenAI的TikToken这样的标准工具可能会成为显著的性能瓶颈。TokenDagger 正是为了解决这一痛点而精心打造的高性能、即插即用型替代方案,旨在为您处理任何大规模文本任务提供所需的卓越速度和吞吐量。

核心特性

TokenDagger 的设计宗旨在于显著加速您的NLP工作流程,而无需您对现有代码进行任何重构。

🚀 吞吐量与速度的飞跃 以往难以企及的文本处理规模,如今得以轻松实现。TokenDagger 的吞吐量可达到 TikToken 的两倍,在代码分词任务中更是惊人地快达4.02倍。这直接意味着节约了宝贵时间,降低了计算成本,并显著加快了项目周转速度。

⚙️ 优化核心引擎 TokenDagger 的核心在于其优化的 PCRE2 正则表达式引擎,能够实现极高效的 token 模式匹配。它还采用了一种简化的字节对编码(BPE)算法,显著降低了处理大型复杂词表(尤其是包含大量特殊 token 的词表)时常见的性能开销。

🔌 无缝即插即用集成 迁移过程轻松自如。TokenDagger 与 TikToken 完全API兼容,这意味着您只需更改一行代码即可完成切换。只需将 import tiktoken 替换为 import tokendagger as tiktoken,您现有的实现将立即获得显著的速度提升。

独特优势

尽管 TikToken 提供了一个功能性的基准,但 TokenDagger 专为追求卓越性能和极致效率的用户而生。

代码处理速度无与伦比: 当标准分词器主要处理通用文本时,TokenDagger 则针对源代码中复杂的模式进行了独特优化,在此关键领域,相较于 TikToken,实现了经过基准测试的 4.02倍速度提升。

处理能力翻倍: 与 TikToken 的标准性能不同,TokenDagger 提供了经过验证的整体吞吐量翻倍。这使得您能在一半的时间内处理相同体量的数据,是高吞吐量数据管道的理想选择。

无摩擦、零重构升级: TokenDagger 提供真正的即插即用替代方案,而非强迫您重构现有的NLP流水线。这种转换是无缝的,对您的

tiktoken.Encoding调用或其他逻辑无需进行任何更改。

应用场景

大规模数据预处理: 在为模型训练准备海量文本语料库时,TokenDagger 能够显著缩短您的数据准备时间,从而加快模型迭代速度。

开发者工具与代码分析: 如果您正在构建解析和分析大型代码仓库的工具,TokenDagger 的高速性能可确保您的应用程序即使处理数百万行代码,也能保持响应灵敏和高效运行。

高吞吐量信息检索: 对于需要索引海量文本的搜索和检索系统而言,TokenDagger 能加速索引过程,确保您的数据更快地摄入并可供检索。

总结

如果您的 NLP 工作流程在使用 TikToken 时遇到了性能瓶颈,那么 TokenDagger 显然是您明智、合乎逻辑的升级选择。它能在不要求您改动任何现有代码的情况下,显著提升速度和吞吐量。这是为最严苛的文本处理任务释放更高效率的最简便途径。

立即安装,亲身体验性能的飞跃吧!