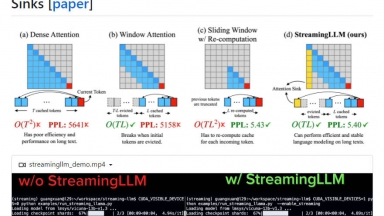

StreamingLLM

StreamingLLM

介紹 StreamingLLM:一個用於在串流應用程式中部署 LLM 的高效框架。無需犧牲效能就能處理無限序列長度,並可享受高達 22.2 倍的速度優化。非常適合多輪對話和日常助理。

VLLM

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Software Development,Data Science |

StreamingLLM

| Launched | 2024 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Workflow Automation,Developer Tools,Communication |

VLLM Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

StreamingLLM Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

When comparing VLLM and StreamingLLM, you can also consider the following products

EasyLLM - EasyLLM 是一個開放原始碼專案,提供便利工具和方法,供您使用開放原始碼和封閉原始碼大型語言模型(LLM)。立即開始或查看文件。

LLMLingua - 為了加速 LLM 的推論並增強 LLM 對關鍵資訊的感知,壓縮提示和 KV 快取,在效能損失極小的情況下達到高達 20 倍的壓縮率。

MegaLLM - Ship AI features faster with MegaLLM's unified gateway. Access Claude, GPT-5, Gemini, Llama, and 70+ models through a single API. Built-in analytics, smart fallbacks, and usage tracking included.

LazyLLM - LazyLLM: 專為多代理式LLM應用程式打造的低程式碼平台。快速建構、疊代並部署複雜的AI解決方案,從原型開發到正式部署一氣呵成。將重心放在演算法的創新,而非繁瑣的工程細節。

VLLM

VLLM