What is FastRouter.ai?

FastRouter.ai 是一個智慧型基礎架構層,旨在簡化、最佳化並擴展您的生產環境 AI 應用程式。它解決了在多供應商大型語言模型 (LLM) 環境中管理複雜性、確保可靠性及控制成本的關鍵挑戰。透過提供單一、與 OpenAI 相容的整合式 API,FastRouter 讓開發人員和工程主管能夠立即存取來自 GPT、Claude、Gemini、Grok 以及超過 100 種其他模型的最佳模型,無需複雜的程式碼重構或廠商鎖定。

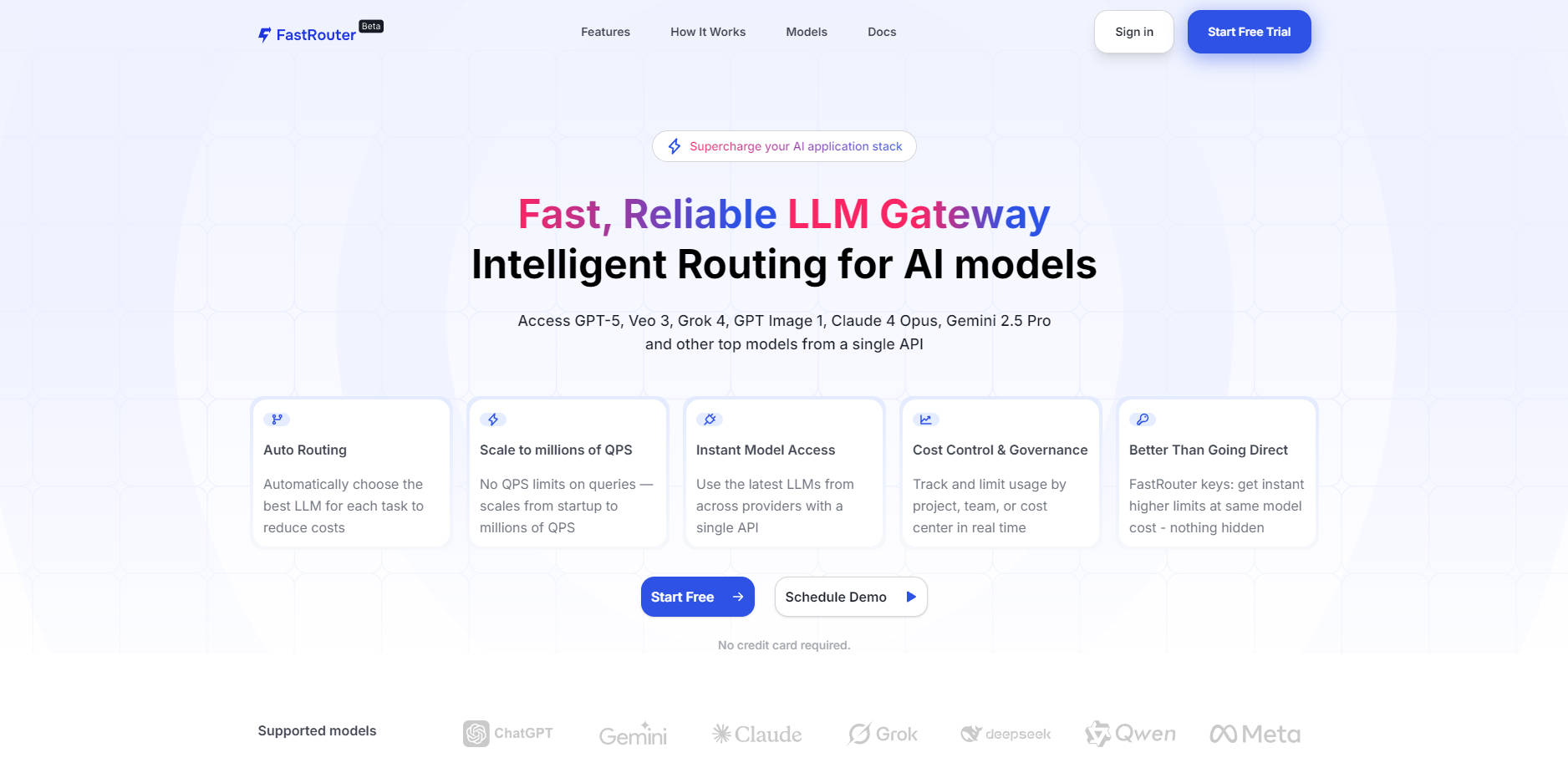

主要功能

FastRouter 提供建構和部署任何規模穩健且具成本效益的 AI 應用程式所需的智慧與基礎架構。

🚀 智慧型路由最佳化

根據成本、延遲和所需的輸出品質動態評估每個請求。FastRouter 會即時自動將請求路由至最佳模型端點,確保您在最大化效能的同時最小化開銷—所有這些都無需任何人工監督。

🔗 支援逾百種模型的統一 API

透過單一、與 OpenAI 相容的端點,無縫連接至龐大的領先文字、圖像和音訊模型生態系統(包括 GPT-5、Veo 3、Claude 4 Opus 等)。此即插即用的替代方案無需管理多個 SDK,可立即簡化您的整合過程,讓您即時運用最新的 AI 技術。

🛡️ 即時故障轉移與高可用性 (InstaSwitch)

確保您的使用者享有不間斷的服務。FastRouter 持續監控供應商端點是否存在中斷、速率限制和性能下降。如果偵測到問題,系統會自動將請求切換至健康且可用的端點,確保您的關鍵任務應用程式具備高可用性和可靠性。

💰 即時成本控制與智能預算管理

對您的 AI 使用情況進行精準的財務管理。針對每個專案、團隊或 API 金鑰定義特定預算、設定速率限制並管理模型權限。平台提供代幣消耗和成本發生情況的即時可視性,讓您能夠識別高峰並在品質要求允許時自動路由至成本較低的模型。

📈 專為超大規模設計

無需切換平台或受限於 QPS,即可從初始開發輕鬆擴展至企業級需求。FastRouter 專為處理巨量吞吐量而設計,可輕鬆管理每秒超過一百萬次查詢 (1M+ QPS),為快速成長提供所需的穩定性。

應用案例

FastRouter.ai 將基礎設施的複雜性轉化為各個角色可實際運用的商業效益:

| 使用者情境 | 解決的挑戰 | 具體成果 |

|---|---|---|

| 工程主管 | 降低可靠性風險和不斷上升的 AI 基礎設施成本。 | 降低風險與成本: 透過動態路由至更經濟、高品質的模型,自動削減 AI 開支,同時即時故障轉移確保企業級的可靠性和安全性。 |

| 開發人員 | 整合流程緩慢以及管理多個供應商 API/SDK。 | 加速部署: 使用單一 API 金鑰,只需替換基礎 URL。此 OpenAI API 的即插即用替代方案可在無需任何程式碼變更的情況下,提供即時效益(路由、故障轉移),讓您更快推出功能。 |

| 產品團隊 | 向終端使用者提供一致的品質和回應時間。 | 提升使用者體驗: 確保您的產品始終為任務使用最佳模型,從而實現更快的反應時間、可預測的成本以及始終如一的高品質輸出,無論底層供應商如何波動。 |

為何選擇 FastRouter.ai?

FastRouter 透過提供一個必要的最佳化層,在效率和治理方面提供可衡量的改進,使其本質上優於直接連接個別 LLM 供應商。

即時存取更高限制: 透過 FastRouter 金鑰,您可以立即利用更高的 API 速率限制,且底層模型成本不變,避免了直接向供應商取得企業級限制時常見的入門摩擦和延遲。

真正零程式碼故障轉移: 與需要開發和維護的自訂故障轉移實作不同,FastRouter 自動且即時地監控並切換端點,提供開箱即用、完整的託管高可用性解決方案。

預設的最佳化效能: FastRouter 的智慧型路由持續評估延遲和成本,這表示您的應用程式本質上比依賴靜態、單一供應商端點的應用程式運行更有效率。您可以在提升整體系統可靠性的同時,潛在地將 AI 開支減少高達 70%。

結論

FastRouter.ai 提供將 AI 應用程式從概念驗證階段轉變為高度可靠、具成本效益的生產規模所需的關鍵智慧和基礎設施。透過整合模型存取、自動化最佳化並確保高可用性,FastRouter 讓您的團隊能夠專注於創新而非基礎設施管理。

More information on FastRouter.ai

Top 5 Countries

Traffic Sources

FastRouter.ai 替代方案

更多 替代方案-

ModelPilot unifies 30+ LLMs via one API. Intelligently optimize cost, speed, quality & carbon for every request. Eliminate vendor lock-in & save.

-

-

不必再為 AI 服務多花冤枉錢,更不必擔心隨時中斷。MakeHub 的通用 API 能智慧地在各家供應商間分配請求,確保達到極致速度、最低成本,以及即時的穩定可靠。

-

-

Helicone AI Gateway: 整合並最佳化您的 LLM API,成就生產級應用。運用智慧路由與快取技術,全面提升效能、有效撙節成本,並確保服務穩定運行。