What is Baichuan-7B?

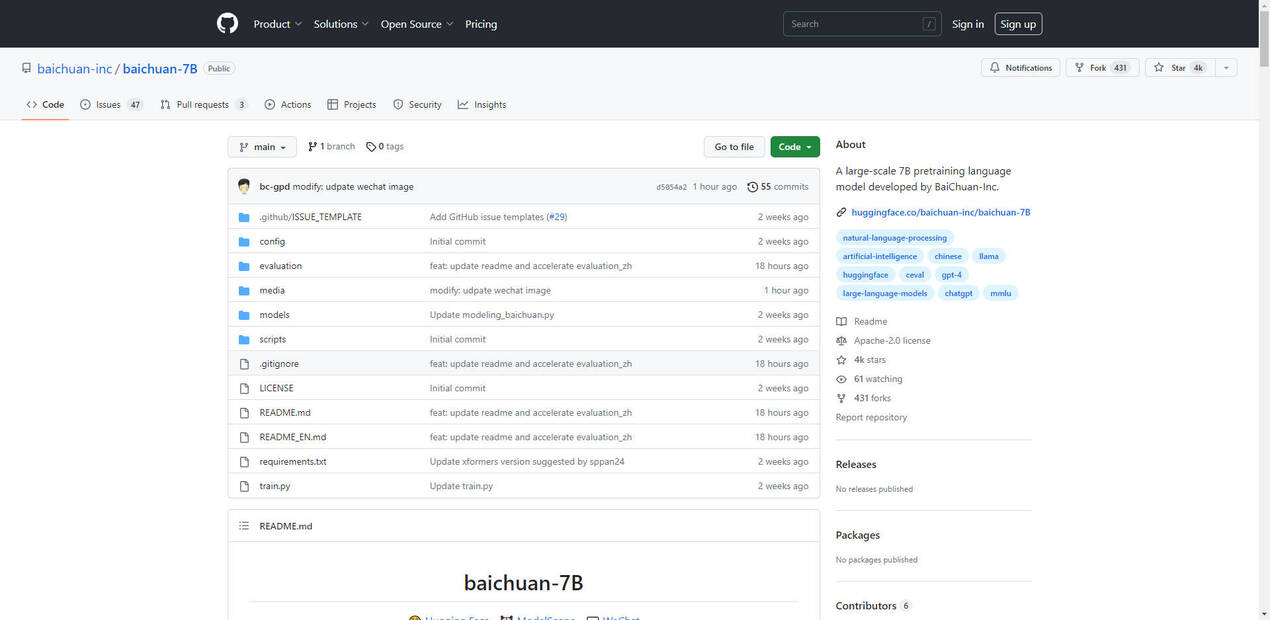

Baichuan-7B es un notable modelo preentrenado a gran escala de código abierto, desarrollado por Baichuan Intelligent Technology. Basado en la arquitectura Transformer, este modelo presume de 7 mil millones de parámetros entrenados en aproximadamente 1.2 billones de tokens. Es único por sus capacidades bilingües, al soportar tanto chino como inglés, y por su impresionante longitud de ventana de contexto de 4096. A través de una rigurosa evaluación en los puntos de referencia estándar de chino (C-Eval) e inglés (MMLU), Baichuan-7B ha logrado un rendimiento de vanguardia entre los modelos de su tamaño.

Características Clave:

- Amplio Soporte de Idiomas: Baichuan-7B sobresale en el procesamiento del idioma chino e inglés, demostrando un sólido rendimiento en puntos de referencia específicos.

- Arquitectura de Vanguardia: Aprovechando la arquitectura Transformer, Baichuan-7B ofrece notables capacidades de generación de texto, permitiendo tareas como resumen, traducción y escritura creativa.

- Versátil Aplicabilidad en Sectores Inferiores: Baichuan-7B es muy adecuado para tareas posteriores, incluyendo respuestas a preguntas, clasificación de texto y generación de diálogos, lo que lo convierte en una herramienta versátil para varias aplicaciones de procesamiento del lenguaje natural (PLN).

Casos de Uso:

- Chatbots de Servicio al Cliente: Baichuan-7B puede ser aprovechado para crear sofisticados chatbots de servicio al cliente que proporcionen asistencia eficiente y personalizada, mejorando la satisfacción del cliente.

- Traducción Automática: Las capacidades bilingües de Baichuan-7B lo convierten en una opción ideal para la traducción en tiempo real, rompiendo las barreras del idioma y facilitando la comunicación global.

- Generación de Contenido: Desata el poder de Baichuan-7B para generar descripciones de productos convincentes, textos de marketing cautivadores y publicaciones atractivas en redes sociales, lo que impulsa una mayor participación de la marca.

Conclusión:

Baichuan-7B se erige como un logro innovador en el campo del procesamiento del lenguaje natural, empujando los límites de la generación y comprensión de texto. Sus capacidades bilingües, diversas aplicaciones posteriores y su impresionante rendimiento lo convierten en un valioso activo para los desarrolladores y las empresas que buscan mejorar sus capacidades de PLN. A medida que el campo continúa evolucionando, Baichuan-7B está preparado para desempeñar un papel fundamental en la configuración del futuro de la comunicación entre humanos y computadoras, y en la habilitación de nuevas aplicaciones que aprovechen el poder del lenguaje.

More information on Baichuan-7B

Baichuan-7B Alternativas

Más Alternativas-

Hunyuan-MT-7B: Traducción automática de IA de código abierto. Domina más de 33 idiomas con una precisión contextual y cultural insuperable. Ganador de WMT2025, ligero y eficiente.

-

-

Baichuan-M2: IA médica avanzada para el razonamiento clínico en entornos reales. Mejora el diagnóstico, optimiza los resultados para los pacientes y permite una implementación privada en una única GPU.

-

-