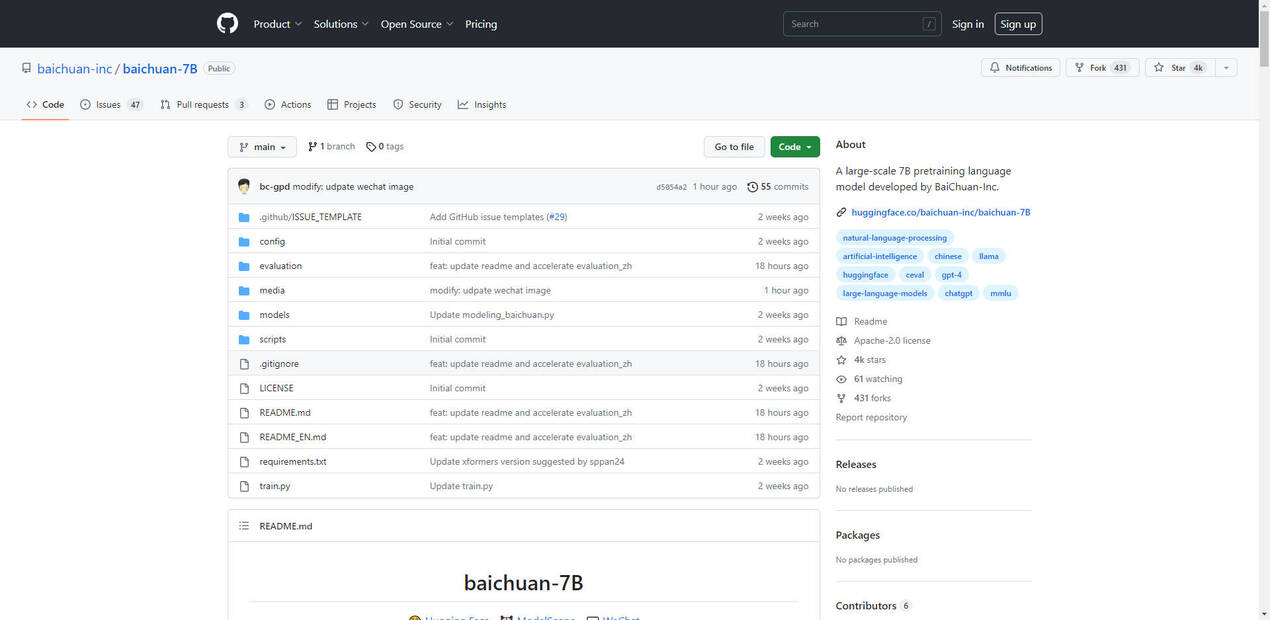

What is Baichuan-7B?

Baichuan-7B는 Baichuan Intelligent Technology에서 개발한 주목할 만한 오픈소스 대규모 사전 훈련 모델입니다. Transformer 아키텍처를 기반으로 구축된 이 모델은 약 1조 2천억 개의 토큰으로 훈련된 70억 개의 매개변수를 자랑합니다. 중국어와 영어를 모두 지원하는 이중 언어 기능과 4096의 인상적인 컨텍스트 윈도 길이가 특징입니다. 표준 중국어(C-Eval) 및 영어 벤치마크(MMLU)에 대한 엄격한 평가를 통해 Baichuan-7B는 해당 규모의 모델 중 최첨단 성능을 달성했습니다.

주요 특징:

- 광범위한 언어 지원: Baichuan-7B는 중국어와 영어 언어 처리에서 탁월한 성능을 보여주며 특정 벤치마크에서 강력한 성능을 보여줍니다.

- 최첨단 아키텍처: Transformer 아키텍처를 활용한 Baichuan-7B는 요약, 번역, 창작 글쓰기와 같은 작업을 가능하게 하는 뛰어난 텍스트 생성 기능을 제공합니다.

- 다양한 다운스트림 적용 가능성: Baichuan-7B는 질문 응답, 텍스트 분류, 대화 생성을 포함한 다운스트림 작업에 적합하여 다양한 NLP 응용 프로그램에 다재다능한 도구로 사용할 수 있습니다.

사용 사례:

- 고객 서비스 챗봇: Baichuan-7B를 사용하여 효율적이고 개인화된 지원을 제공하고 고객 만족도를 높이는 정교한 고객 서비스 챗봇을 만들 수 있습니다.

- 기계 번역: Baichuan-7B의 이중 언어 기능은 실시간 번역에 이상적인 옵션으로, 언어 장벽을 허물고 글로벌 커뮤니케이션을 용이하게 합니다.

- 콘텐츠 생성: Baichuan-7B의 힘을 발휘하여 매력적인 제품 설명, 매혹적인 마케팅 카피, 참여도를 높이는 소셜 미디어 게시물을 생성하고 브랜드 참여를 높일 수 있습니다.

결론:

Baichuan-7B는 텍스트 생성과 이해의 경계를 넓히는 자연어 처리 분야에서 획기적인 업적을 이루었습니다. 이중 언어 기능, 다양한 다운스트림 응용 프로그램, 인상적인 성능으로 NLP 기능을 강화하고자 하는 개발자와 기업에게 귀중한 자산이 되었습니다. 이 분야가 계속해서 진화함에 따라 Baichuan-7B는 인간과 컴퓨터의 의사소통의 미래를 형성하고 언어의 힘을 활용하는 새로운 응용 프로그램을 가능하게 하는 데 중요한 역할을 할 것입니다.

More information on Baichuan-7B

Launched

2023

Pricing Model

Free

Starting Price

Global Rank

Follow

Month Visit

<5k

Tech used

Amazon AWS CloudFront,cdnjs,Google Fonts,KaTeX,RSS,Stripe