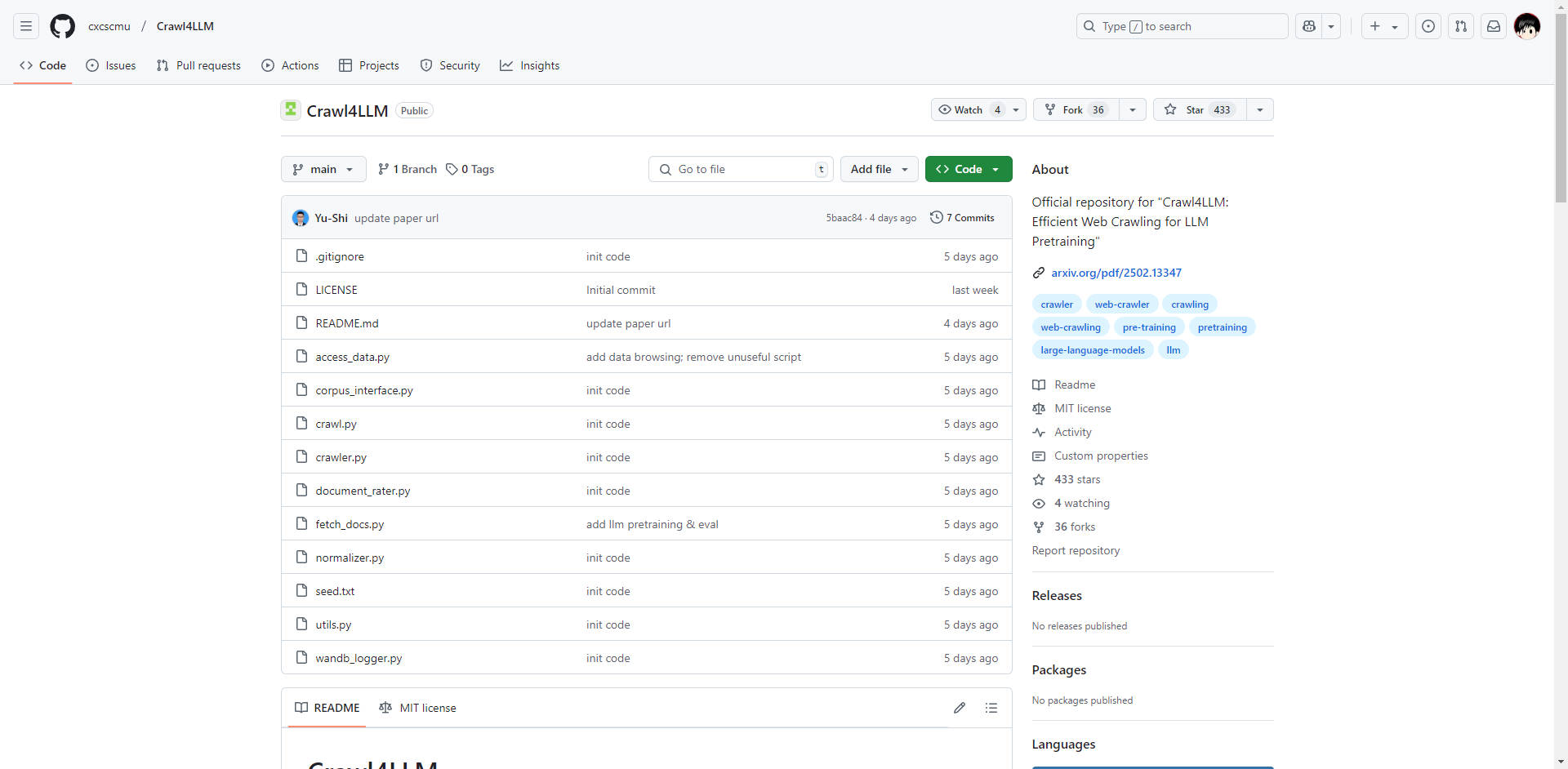

What is Crawl4LLM?

La qualité et l'efficacité de l'acquisition de données sont primordiales à l'ère des grands modèles de langage (LLM). Les robots d'indexation web traditionnels sont souvent confrontés au volume considérable du web, ce qui entraîne un gaspillage de ressources et des ensembles de données d'entraînement sous-optimaux. Crawl4LLM, un projet collaboratif open-source de l'université Tsinghua et de l'université Carnegie Mellon, s'attaque directement à ce problème. Il s'agit d'un système d'indexation web intelligent conçu pour prioriser la collecte de pages web à forte valeur ajoutée, spécifiquement pour le pré-entraînement des LLM, ce qui permet d'améliorer de près de cinq fois l'efficacité de l'acquisition de données.

Principales caractéristiques :

🤖 Sélection intelligente des pages web : Utilise un système de notation d'impact pré-entraîné (utilisant le modèle DCLM fastText) pour évaluer la valeur du contenu d'une page web avant l'indexation. Cela permet de donner la priorité aux pages à forte valeur ajoutée, en minimisant la collecte de données non pertinentes ou de mauvaise qualité. Détail technique : La notation prend en compte la qualité du contenu, la pertinence et d'autres indicateurs, fournissant une évaluation complète de l'utilité d'une page pour l'entraînement des LLM.

⚙️ Modes d'indexation multiples : Offre une flexibilité permettant de s'adapter aux différents besoins d'acquisition de données :

Mode intelligent : Ajuste dynamiquement la stratégie d'indexation en fonction des scores de valeur des pages web. Il s'agit du mode principal pour maximiser l'efficacité.

Mode aléatoire : Fournit une approche d'indexation de base, similaire aux robots d'indexation traditionnels, pour les scénarios où des données ciblées ne sont pas nécessaires.

Mode basé sur les liens : Priorise les pages en fonction du nombre de liens sortants, ce qui est adapté à la collecte de données à grande échelle.

💾 Sauvegarde périodique de l'état du robot d'indexation : Prend en charge une indexation robuste en sauvegardant périodiquement l'état du robot d'indexation. Cela permet de reprendre les indexations à partir du dernier point d'interruption, évitant ainsi la perte de données et assurant un fonctionnement efficace, même lors de tâches de longue durée.

📊 Navigation et visualisation des données : Comprend des outils intuitifs pour naviguer dans les données indexées et visualiser la progression et l'efficacité de l'indexation. Cela permet une surveillance en temps réel et une évaluation immédiate de la qualité des données.

🔗 Intégration transparente du framework DCLM : Conçu pour une intégration directe avec le framework de pré-entraînement DCLM (Deep Learning Model). Cela rationalise le pipeline de données, permettant d'utiliser immédiatement les données indexées pour le pré-entraînement des LLM, minimisant ainsi le transfert de données et les frais de traitement. Détail technique : Facilite un flux de données efficace et réduit la complexité de l'intégration du robot d'indexation au processus d'entraînement.

⚖️ Charge réduite sur les sites web : Filtre intelligemment les pages web cibles, minimisant la pression sur les serveurs des sites web et favorisant des pratiques d'indexation éthiques et conformes.

Architecture technique (bref aperçu) :

L'intelligence de Crawl4LLM provient de ses composants principaux :

Notation d'impact pré-entraînée : Le modèle DCLM fastText est utilisé pour noter le contenu des pages web. Ce modèle évalue la qualité du contenu, la pertinence et d'autres facteurs afin de déterminer la valeur d'une page pour l'entraînement des LLM.

Ordonnancement des files d'attente prioritaires : Une file d'attente prioritaire est utilisée pour gérer le processus d'indexation. Les pages ayant des scores d'impact plus élevés sont prioritaires, ce qui garantit que les données les plus précieuses sont collectées en premier.

Évaluation multidimensionnelle des données : Le système prend en compte diverses métriques, notamment la longueur du contenu, le nombre de liens et le score d'impact, afin de fournir une évaluation holistique de chaque page web.

Simulation et optimisation : Des simulations poussées ont été utilisées pour valider l'efficacité de l'algorithme et pour affiner les paramètres afin d'obtenir des performances d'indexation optimales.

Cas d'utilisation :

Pré-entraînement de LLM à grande échelle : Accélérer la création d'ensembles de données d'entraînement de haute qualité pour les LLM. Par exemple, une équipe de recherche développant un nouveau modèle d'IA conversationnelle peut utiliser Crawl4LLM pour collecter efficacement des données textuelles pertinentes sur le web, réduisant ainsi le temps d'entraînement et améliorant les performances du modèle.

Construction d'ensembles de données ciblés : Créer des ensembles de données spécialisés axés sur des domaines ou des sujets spécifiques. Une équipe créant un LLM médical pourrait utiliser Crawl4LLM pour se concentrer sur la collecte de données provenant de sites web et de publications médicales réputées, garantissant ainsi que l'ensemble de données est très pertinent pour le domaine cible.

Amélioration de l'indexation des moteurs de recherche : Améliorer la qualité des données utilisées pour l'indexation des moteurs de recherche. En donnant la priorité aux pages à forte valeur ajoutée, Crawl4LLM peut aider les moteurs de recherche à identifier et à indexer le contenu le plus pertinent et le plus informatif, ce qui permet d'obtenir de meilleurs résultats de recherche.

Surveillance et analyse du réseau : En identifiant les données précieuses, Crawl4LLM peut collecter et analyser efficacement les informations provenant de diverses sources.

Conclusion :

Crawl4LLM offre une avancée significative dans l'indexation web pour le pré-entraînement des LLM. Sa sélection intelligente des pages web, ses modes d'indexation flexibles et son intégration transparente avec le framework DCLM fournissent une solution puissante et efficace pour les chercheurs et les développeurs qui cherchent à créer des ensembles de données LLM de haute qualité. En donnant la priorité à la qualité des données et en minimisant le gaspillage de ressources, Crawl4LLM permet aux utilisateurs d'entraîner des LLM plus efficaces en moins de temps.