What is Local.ai?

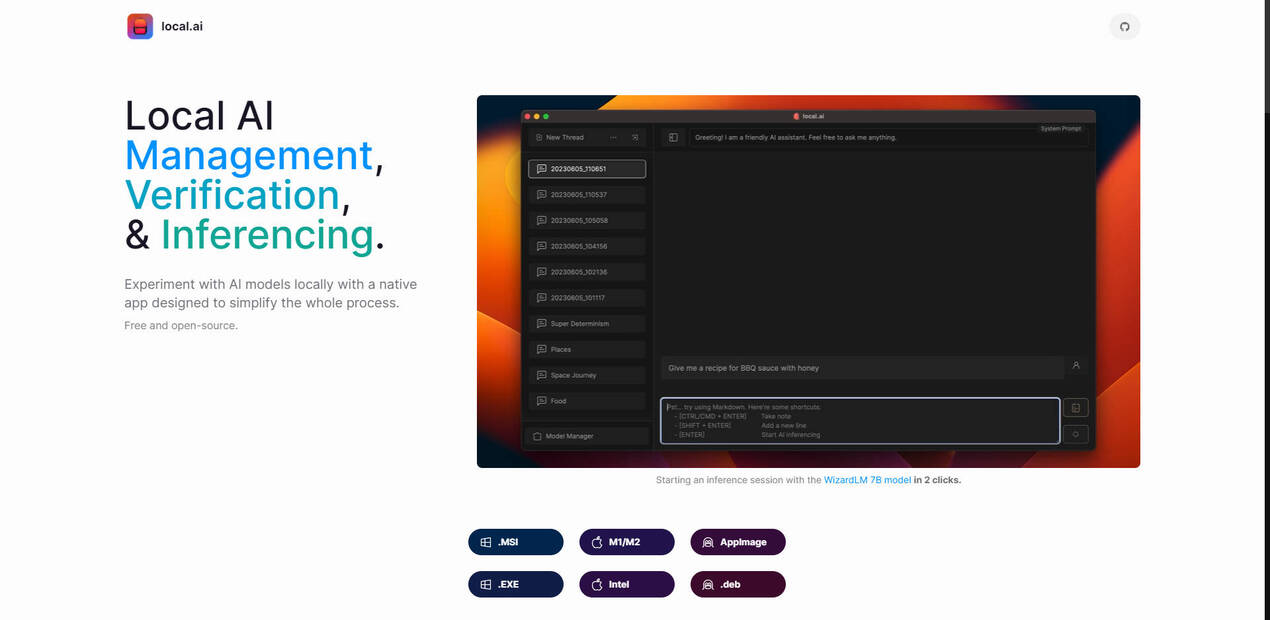

Vous avez toujours rêvé de plonger dans le monde des modèles d'IA sans vous embourber dans des configurations complexes ou avoir besoin de matériel coûteux ? C’est désormais possible. Cette application native vous permet d’expérimenter l’IA localement sur votre ordinateur, même sans GPU dédié. Elle est conçue pour rendre l’IA accessible à tous, que vous soyez un développeur chevronné ou simplement curieux d’IA. Profitez de la liberté d’exécuter des modèles hors ligne, en préservant la confidentialité de vos données et en simplifiant vos expérimentations. De plus, elle est entièrement gratuite et open-source, vous permettant de rejoindre une communauté d’innovateurs sans dépenser un centime.

Fonctionnalités clés

⚡ Simplifiez l’expérimentation de l’IA : Lancez des modèles d’IA en quelques clics – finies les configurations complexes. C’est comme avoir votre propre assistant IA personnel qui se charge de tout le travail technique pour que vous puissiez vous concentrer sur l’exploration.

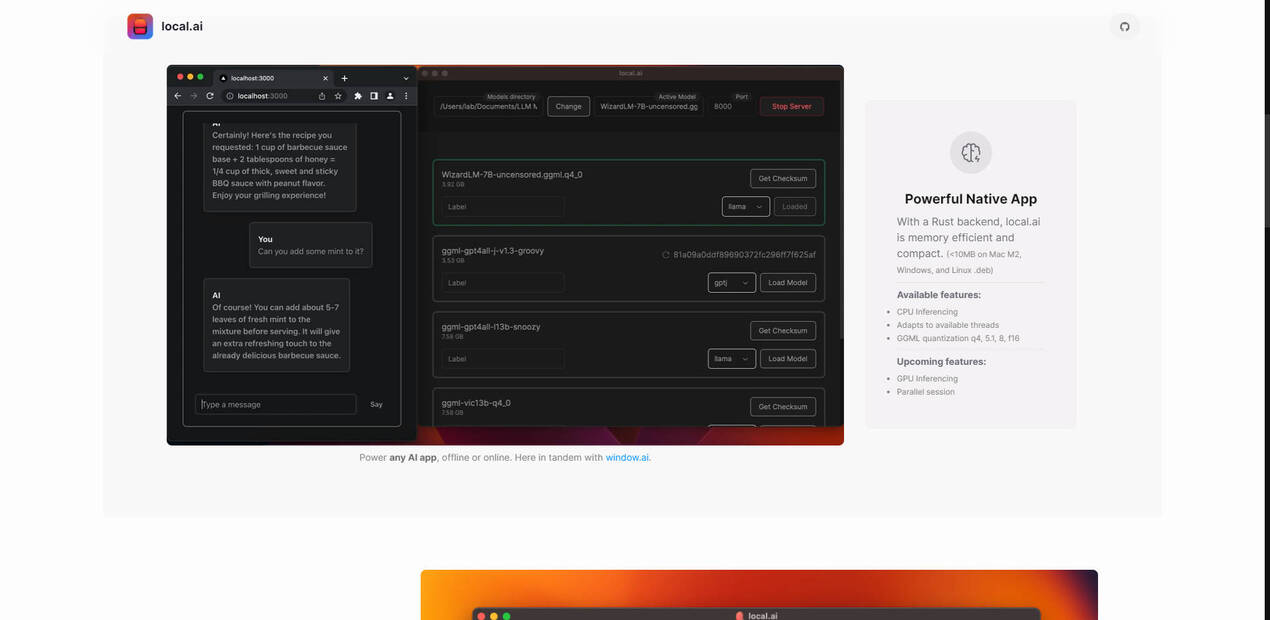

?️ Exécutez l’IA sur votre CPU : Vous n’avez pas besoin d’une carte graphique haut de gamme pour commencer. Cette application optimise les modèles d’IA pour qu’ils fonctionnent correctement sur votre CPU existant, rendant l’IA accessible sur une plus large gamme d’appareils. C’est comme exploiter au maximum les performances de votre machine actuelle.

? Travaillez hors ligne, protégez vos données : Expérimentez avec des modèles d’IA sans connexion Internet. Vos données restent sur votre appareil, garantissant ainsi la confidentialité et la sécurité. C’est comme avoir un laboratoire d’IA toujours ouvert et qui ne partage jamais vos secrets.

?️ Personnalisez votre expérience : Ajustez les paramètres des modèles, tels que les threads et la quantification, pour répondre à vos besoins spécifiques et aux capacités de votre matériel. Cela vous permet d’équilibrer les performances et la précision, en adaptant l’expérience à votre flux de travail. C’est comparable à un contrôle total des performances de votre modèle d’IA.

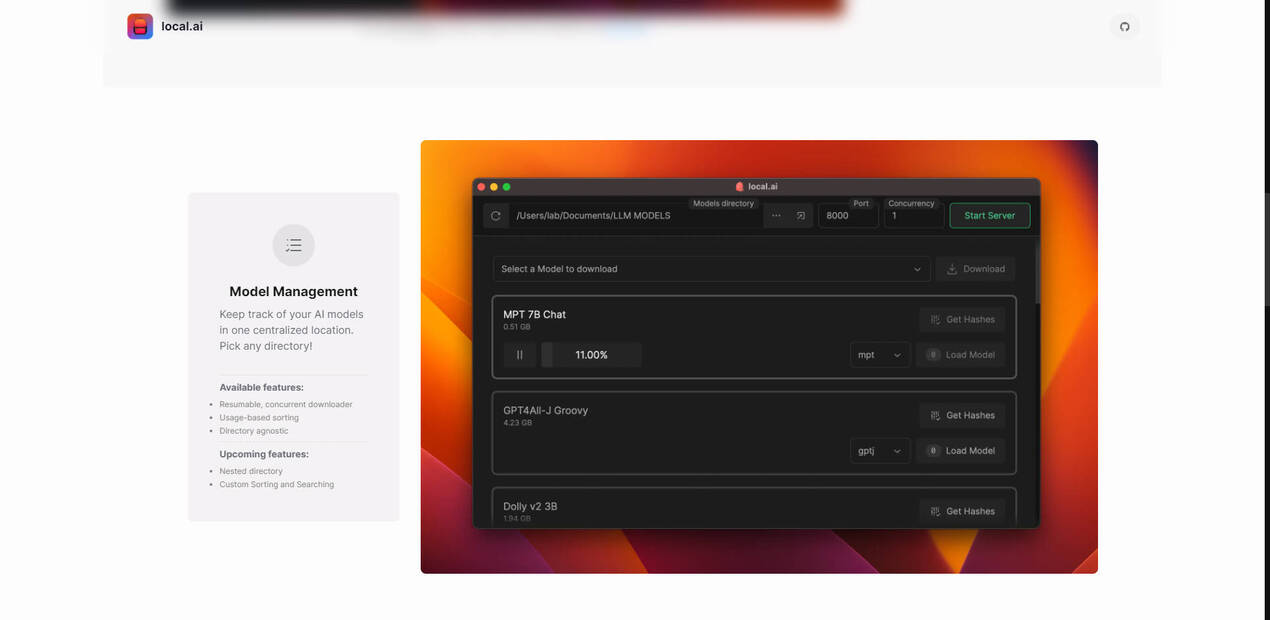

? Organisez vos modèles : Gardez tous vos modèles d’IA au même endroit. L’application vous permet de choisir n’importe quel répertoire, ce qui facilite la gestion de votre collection croissante. C’est comme avoir une bibliothèque bien organisée pour tous vos outils d’IA.

✅ Vérifiez l’intégrité des modèles : Assurez-vous que les modèles d’IA que vous téléchargez sont sûrs et n’ont pas été altérés. L’application vérifie l’intégrité des modèles à l’aide de digests BLAKE3 et SHA256 robustes, vous offrant ainsi une tranquillité d’esprit. C’est comme avoir un expert en sécurité qui vérifie vos modèles d’IA avant que vous ne les utilisiez.

⚡ Démarrez un serveur d’inférence local : chargez votre modèle, puis démarrez le serveur. C’est tout !

⚡ Accédez à une interface utilisateur intuitive : Exécutez des tests rapides et des tâches d’inférence avec une interface conviviale, rationalisant ainsi votre flux de travail.

Cas d’utilisation

Enthousiastes de l’IA : Vous êtes curieux de l’IA et souhaitez essayer différents modèles sans courbe d’apprentissage abrupte ni investissement important en matériel. Téléchargez l’application, choisissez un modèle et commencez à expérimenter – c’est aussi simple que ça. Cela pourrait être la porte d’entrée de votre voyage dans le monde de l’IA.

Développeurs : Vous avez besoin d’un moyen rapide et pratique de tester les modèles d’IA localement pendant le développement. Cette application vous permet de lancer un modèle d’IA en quelques minutes, d’itérer plus rapidement et d’intégrer en toute transparence l’IA dans vos projets sans dépendre des services cloud.

Chercheurs : Vous travaillez avec des données sensibles et avez besoin d’un moyen sécurisé d’expérimenter les modèles d’IA hors ligne. Cette application préserve la confidentialité de vos recherches et vous permet d’affiner les modèles selon vos spécifications exactes.

Conclusion

Cette application supprime les obstacles à l’expérimentation de l’IA. C’est l’outil idéal pour tous ceux qui souhaitent explorer la puissance des modèles d’IA sans les complexités habituelles. Grâce à son interface conviviale, son inférence basée sur le CPU, ses capacités hors ligne et ses fonctionnalités robustes de gestion des modèles, elle met la puissance de l’IA entre vos mains, facilitant plus que jamais l’apprentissage, le développement et l’innovation. Pourquoi attendre ? Découvrez l’avenir de l’IA dès aujourd’hui.

FAQ

Q : Quels systèmes d’exploitation sont compatibles ?

R : L’application est disponible pour une large gamme de systèmes d’exploitation, notamment les Mac M1/M2, les machines Intel et diverses distributions Linux (AppImage, .deb). Pour les utilisateurs Windows, des options .MSI et .EXE sont disponibles. Cette large compatibilité vous assure de pouvoir utiliser l’application quelle que soit votre plateforme préférée.

Q : Qu’est-ce que la quantification GGML, et comment m’aide-t-elle ?

R : La quantification GGML est une technique qui réduit la taille des modèles d’IA, ce qui les rend plus rapides et moins gourmands en mémoire. Les options telles que q4, 5.1, 8 et f16 vous permettent de choisir le bon équilibre entre la taille du modèle et la précision en fonction de vos besoins et des ressources système.

More information on Local.ai

Top 5 Countries

Traffic Sources

Local.ai Alternatives

Plus Alternatives-

L'application Bodhi vous permet d'exécuter de grands modèles de langage sur votre machine. Profitez de la confidentialité, d'une interface utilisateur de chat intuitive, d'une gestion simplifiée des modèles, de la compatibilité avec l'API OpenAI et de hautes performances. Gratuite, open-source, et idéale pour les développeurs, les passionnés d'IA et les utilisateurs soucieux de leur vie privée. Téléchargez-la maintenant !

-

CogniSelect SDK : Créez des applications d'IA qui exécutent des LLM de manière privée dans le navigateur. Bénéficiez d'un runtime sans frais, d'une confidentialité totale des données et d'une scalabilité instantanée.

-

-

-

LM Studio est une application de bureau intuitive, conçue pour faciliter l'expérimentation avec les Large Language Models (LLM) locaux et open-source. Cette application multiplateforme vous offre la possibilité de télécharger et d'exécuter n'importe quel modèle compatible ggml directement depuis Hugging Face. Elle intègre une interface utilisateur (UI) pour la configuration et l'inférence des modèles, se distinguant par sa simplicité d'accès et sa puissance. De plus, elle tire pleinement parti de votre GPU lorsque les conditions le permettent.