What is Local.ai?

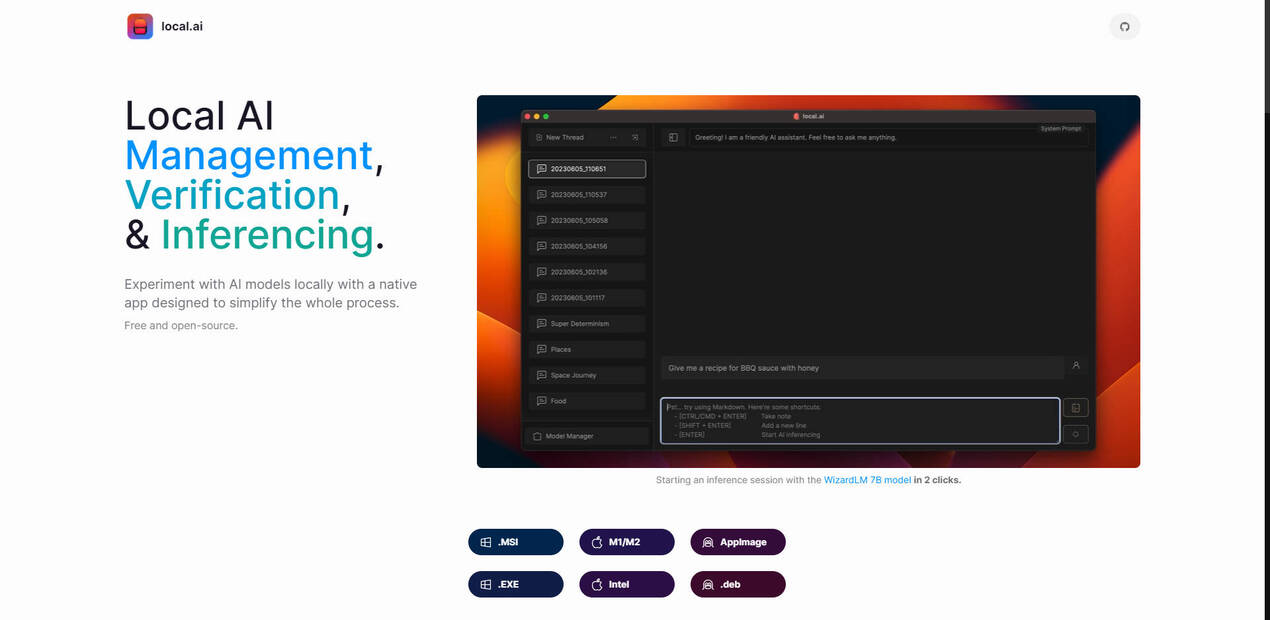

복잡한 설정이나 고가의 하드웨어 없이 AI 모델의 세계에 뛰어들고 싶으셨나요? 이제 가능합니다. 이 네이티브 앱을 사용하면 전용 GPU 없이도 자신의 컴퓨터에서 로컬로 AI를 실험할 수 있습니다. 숙련된 개발자이든 AI에 관심 있는 초보자이든 누구든 AI를 쉽게 접할 수 있도록 설계되었습니다. 오프라인으로 모델을 실행하여 데이터를 안전하게 보호하고 번거로움 없이 실험을 즐기세요. 게다가 완전히 무료이며 오픈 소스이므로 돈을 들이지 않고도 혁신가들의 커뮤니티에 참여할 수 있습니다.

주요 기능

⚡ AI 실험 간소화:몇 번의 클릭만으로 AI 모델을 실행하세요. 더 이상 복잡한 설정에 허둥지둥할 필요가 없습니다. 마치 모든 기술적인 어려움을 처리해주는 개인 AI 조수를 갖춘 것과 같아서 여러분은 탐색에 집중할 수 있습니다.

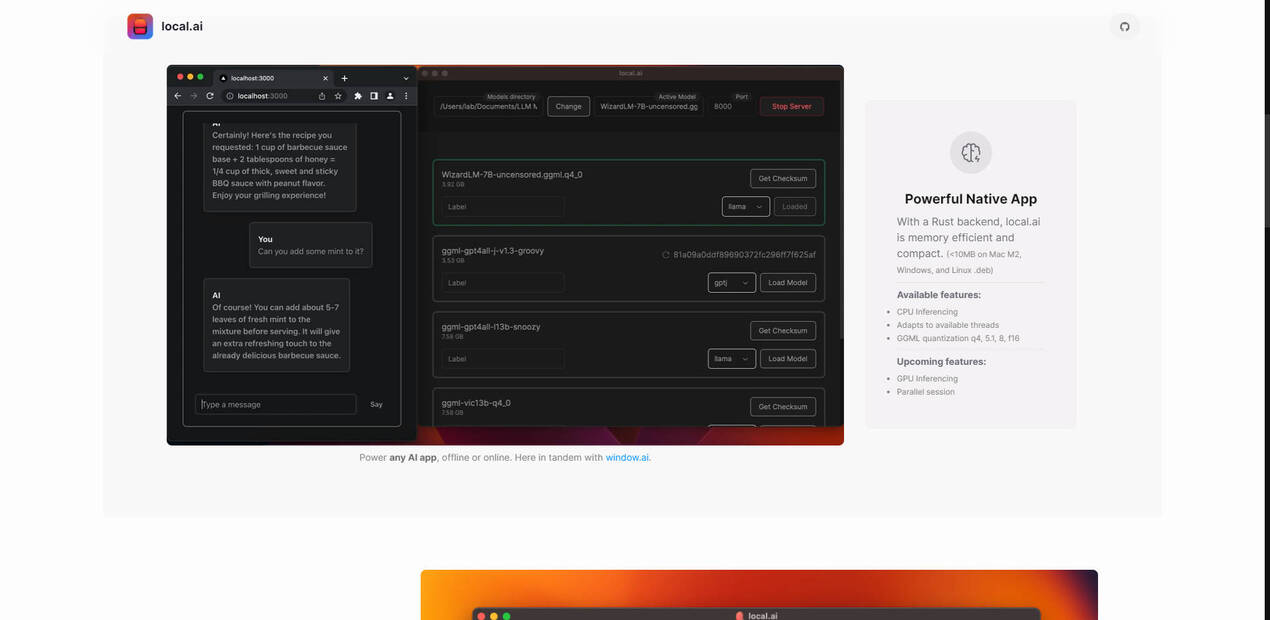

?️ CPU에서 AI 실행:고급 그래픽 카드가 없어도 시작할 수 있습니다. 이 앱은 기존 CPU에서 AI 모델이 원활하게 실행되도록 최적화하여 더욱 다양한 기기에서 AI를 사용할 수 있도록 합니다. 현재 기기의 성능을 최대한 활용하는 것과 같습니다.

? 오프라인 작업, 데이터 개인 정보 보호:인터넷 연결 없이 AI 모델을 실험하세요. 데이터는 기기에 저장되어 개인 정보와 보안이 보장됩니다. 언제든지 열려 있고 비밀을 공유하지 않는 AI 연구실을 갖춘 것과 같습니다.

?️ 사용자 환경 맞춤 설정:스레드 및 양자화와 같은 모델 매개변수를 미세 조정하여 특정 요구 사항 및 하드웨어 기능에 맞출 수 있습니다. 이를 통해 성능과 정확성의 균형을 맞춰 작업 흐름에 맞게 환경을 조정할 수 있습니다. AI 모델 성능을 완벽하게 제어하는 것과 같습니다.

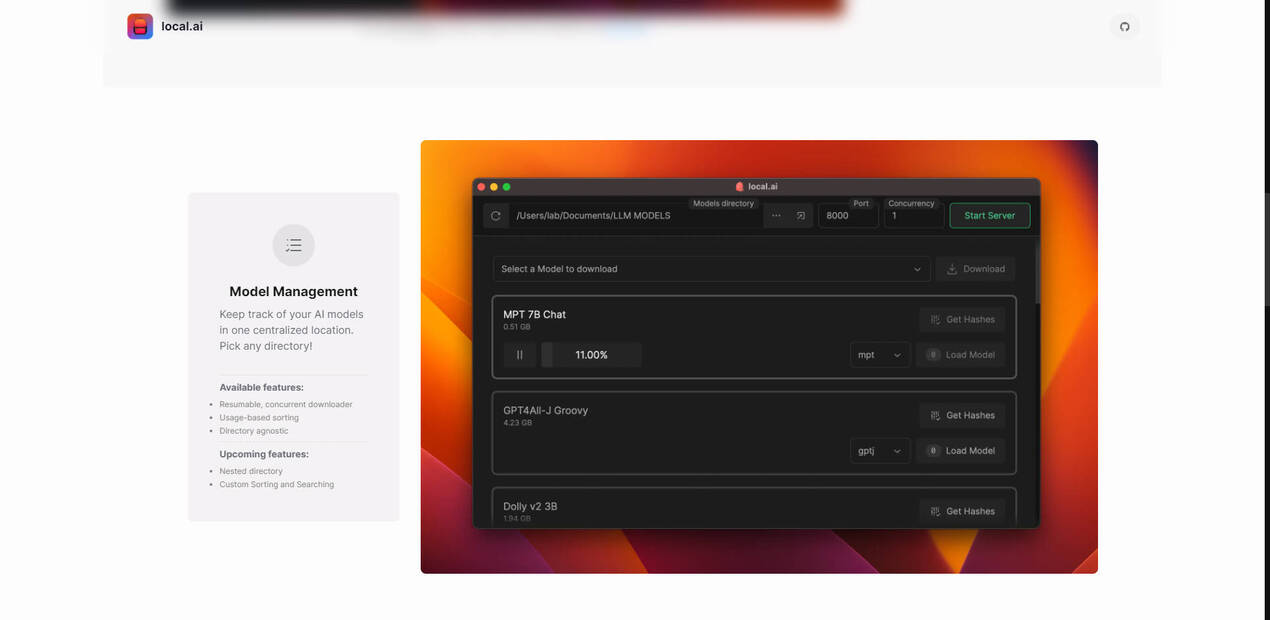

? 모델 정리:모든 AI 모델을 한 곳에 보관하세요. 앱을 사용하여 원하는 디렉토리를 선택하면 증가하는 컬렉션을 쉽게 관리할 수 있습니다. 모든 AI 도구를 잘 정리된 라이브러리에 보관하는 것과 같습니다.

✅ 모델 무결성 검증:다운로드한 AI 모델이 안전하고 변조되지 않았는지 확인하세요. 앱은 강력한 BLAKE3 및 SHA256 다이제스트를 사용하여 모델 무결성을 검사하여 안심할 수 있도록 합니다. AI 모델을 사용하기 전에 보안 전문가가 두 번 확인하는 것과 같습니다.

⚡ 로컬 추론 서버 시작:모델을 로드한 다음 서버를 시작하세요. 그게 전부입니다!

⚡ 직관적인 UI 접근:사용자 친화적인 인터페이스를 통해 빠른 테스트와 추론 작업을 실행하여 작업 흐름을 간소화하세요.

사용 사례

AI 애호가:AI에 대해 궁금하고 가파른 학습 곡선이나 하드웨어에 대한 많은 투자 없이 다양한 모델을 시도해보고 싶습니다. 앱을 다운로드하고 모델을 선택하여 실험을 시작하세요. AI 여정의 시작이 될 수 있습니다.

개발자:개발 중에 로컬에서 AI 모델을 빠르고 편리하게 테스트할 수 있는 방법이 필요합니다. 이 앱을 사용하면 몇 분 안에 AI 모델을 실행하고, 더 빠르게 반복하고, 클라우드 서비스에 의존하지 않고도 프로젝트에 AI를 원활하게 통합할 수 있습니다.

연구자:민감한 데이터를 사용하고 있으며 오프라인으로 AI 모델을 안전하게 실험할 수 있는 방법이 필요합니다. 이 앱은 연구 내용을 기밀로 유지하고 정확한 사양에 맞게 모델을 미세 조정할 수 있도록 합니다.

결론

이 앱은 AI 실험의 장벽을 허물어줍니다. 일반적인 복잡성 없이 AI 모델의 성능을 탐색하고자 하는 모든 사람에게 완벽한 도구입니다. 사용자 친화적인 인터페이스, CPU 기반 추론, 오프라인 기능 및 강력한 모델 관리 기능을 통해 AI의 힘을 손쉽게 사용할 수 있도록 하여 학습, 개발 및 혁신을 그 어느 때보다 쉽게 만들어줍니다. 더 이상 기다리지 마세요. 오늘 바로 AI의 미래를 경험하세요.

FAQ

Q: 지원되는 운영 체제는 무엇입니까?

A: 이 앱은 M1/M2 Mac, Intel 기반 머신 및 다양한 Linux 배포판 (AppImage, .deb)을 포함한 광범위한 운영 체제에서 사용할 수 있습니다. Windows 사용자의 경우 .MSI 및 .EXE 옵션이 있습니다. 이러한 광범위한 호환성을 통해 선호하는 플랫폼에 관계없이 앱을 사용할 수 있습니다.

Q: GGML 양자화란 무엇이며 어떻게 도움이 됩니까?

A: GGML 양자화는 AI 모델의 크기를 줄여 속도를 높이고 메모리 사용량을 줄이는 기술입니다. q4, 5.1, 8 및 f16과 같은 옵션을 통해 요구 사항과 시스템 리소스에 따라 모델 크기와 정확성 간의 적절한 균형을 선택할 수 있습니다.