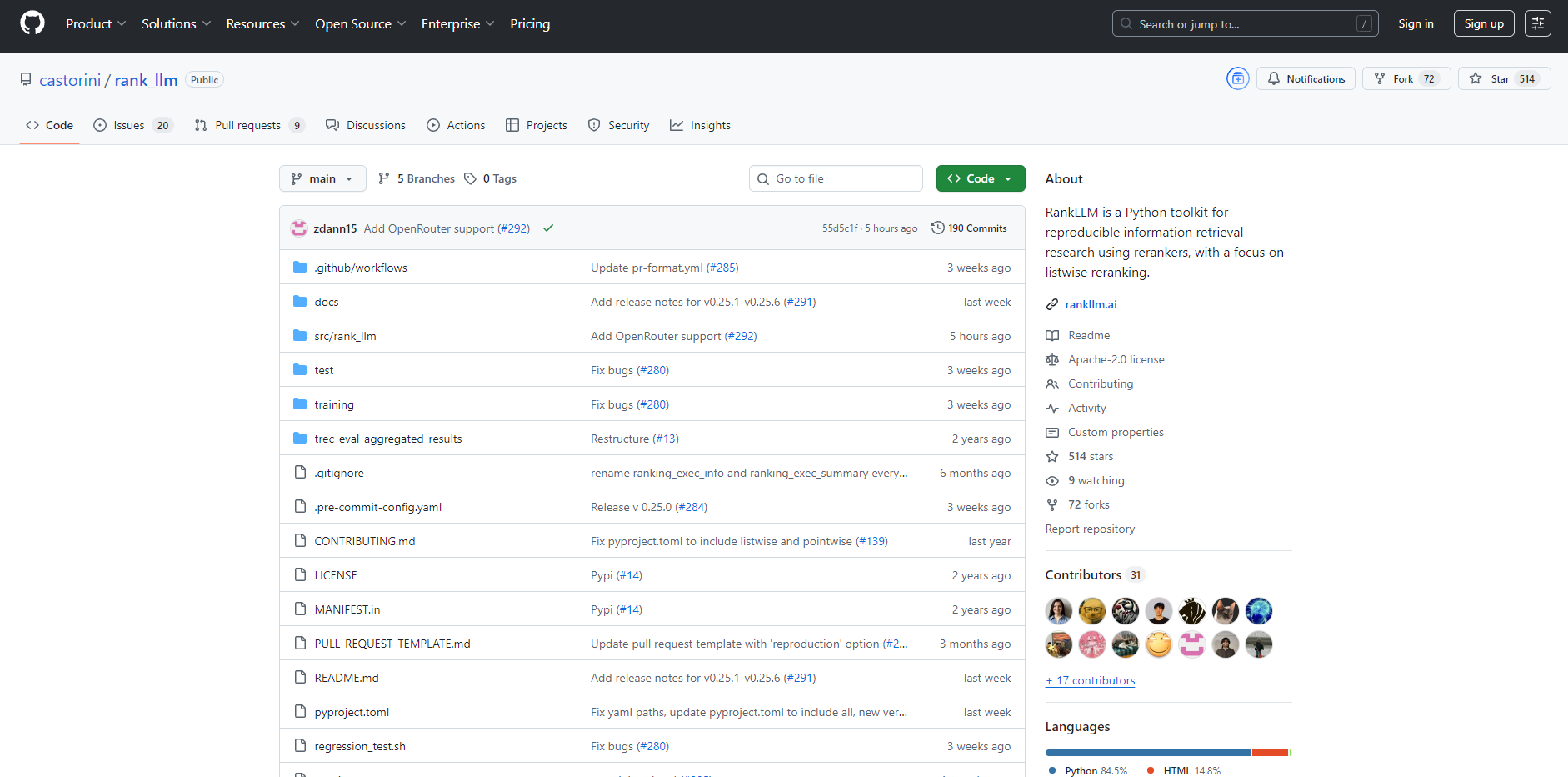

What is RankLLM?

RankLLM est une boîte à outils Python complète conçue pour les chercheurs et ingénieurs en récupération d'information (RI) qui ont besoin d'un cadre robuste et reproductible pour exploiter les Grands Modèles de Langage (LLM). Il s'attaque systématiquement aux complexités du reranking, offrant un environnement unifié pour expérimenter, évaluer et déployer une vaste gamme de modèles de reranking. RankLLM simplifie l'ensemble du pipeline de recherche — de la récupération et du reranking à l'évaluation — en se concentrant principalement sur les rerankers listwise, puissants et efficaces.

Caractéristiques Principales

📚 Support Polyvalent de Rerankers Dépassez les limitations des modèles uniques. RankLLM fournit une interface unifiée pour plusieurs paradigmes de reranking, incluant les modèles pointwise (MonoT5), pairwise (DuoT5) et listwise avancés. Vous pouvez expérimenter sans effort avec des LLM open-source comme RankZephyr et RankVicuna ou vous intégrer à des API propriétaires pour RankGPT et RankGemini, le tout au sein de la même boîte à outils.

⚡ Inférence Haute Performance Menez des expériences à grande échelle sans les goulots d'étranglement de performance habituels. RankLLM est conçu pour l'efficacité, avec un support direct pour les backends d'inférence de pointe comme vLLM, SGLang et TensorRT-LLM. Cela vous permet d'accélérer considérablement vos tâches de reranking, rendant pratique le travail avec des modèles et des ensembles de données plus volumineux.

🔁 Reproductibilité de Bout en Bout Éliminez les conjectures et les frais de configuration courants dans la recherche en RI. Grâce à des scripts wrapper pratiques et à nos commandes de "reproduction en deux clics" (2CR), vous pouvez facilement reproduire les résultats d'articles de recherche clés sur des ensembles de données standard comme MS MARCO. Cela fournit une base de référence fiable, vous permettant de vous concentrer sur l'innovation plutôt que sur l'implémentation.

🗂️ Model Zoo Étendu et Organisé Accédez à une riche collection de modèles de reranking pré-entraînés et optimisés directement via la boîte à outils. Le Model Zoo inclut la suite complète LiT5 pour un reranking efficace en une seule passe, divers modèles MonoT5 pour le scoring pointwise, et les derniers modèles listwise comme RankZephyr. Cette sélection organisée vous fait gagner du temps et garantit que vous travaillez avec des rerankers éprouvés et de haute qualité.

Cas d'Utilisation

Comparaison d'Architectures de Reranking : En tant que chercheur, vous pouvez utiliser RankLLM pour effectuer une comparaison équitable et contrôlée entre un modèle pointwise comme MonoT5, un modèle pairwise comme DuoT5, et un modèle listwise comme RankZephyr sur votre ensemble de données spécifique. La boîte à outils gère le travail répétitif, vous permettant de vous concentrer sur l'analyse des résultats et d'en tirer des conclusions claires.

Établir une Base de Référence Solide pour la Recherche : Si vous êtes doctorant ou chercheur, vous pouvez utiliser les commandes 2CR fournies pour reproduire instantanément les résultats de pointe sur des benchmarks comme DL19 et DL20. Cela vous fournit une base de référence vérifiée et très performante, par rapport à laquelle mesurer vos propres contributions novatrices.

Construire un Service de Reranking Efficace : Pour les équipes d'ingénierie, l'intégration de RankLLM avec SGLang ou TensorRT-LLM offre une voie claire pour construire un composant de reranking à haut débit pour un système de recherche en production. Vous pouvez exploiter un modèle comme RankZephyr pour améliorer la pertinence de la recherche tout en maintenant une faible latence.

Pourquoi Choisir RankLLM ?

Cette boîte à outils est conçue pour offrir un avantage distinct par rapport à la création de scripts personnalisés ou à l'utilisation de frameworks plus généralisés. Voici comment :

Accent sur la Reproductibilité : Alors que la reproduction de la recherche en RI est souvent un obstacle majeur, RankLLM est conçu autour de commandes de reproduction en deux clics (2CR). Cet engagement garantit que vous pouvez valider et vous appuyer sur des travaux antérieurs en toute confiance, une fonctionnalité rarement trouvée dans d'autres outils.

Spécialisation dans le Reranking Listwise : Contrairement à de nombreuses boîtes à outils qui se limitent à des méthodes pointwise plus simples, RankLLM offre un support de premier ordre pour le reranking listwise avancé avec des LLM open-source. Cela vous permet de tirer parti de la compréhension contextuelle supérieure des modèles qui évaluent une liste entière de documents en une seule fois.

Conçu pour la Performance : Au lieu de s'appuyer sur des pipelines d'inférence standard, RankLLM s'intègre directement avec des backends haute performance comme vLLM, SGLang et TensorRT-LLM. Cela fournit une solution prête à l'emploi pour accélérer l'inférence que vous auriez autrement à concevoir vous-même.

Diversité de Modèles Inégalée : La boîte à outils offre l'un des model zoos les plus complets et les mieux organisés pour le reranking. Il consolide les modèles de pointe du groupe Castorini et au-delà, vous donnant un point d'accès unique aux modèles pointwise, pairwise et listwise pour divers domaines, y compris la recherche biomédicale.

Conclusion

RankLLM est la boîte à outils définitive pour les chercheurs et les praticiens cherchant à exploiter la puissance des LLM pour la récupération d'information de pointe. En fournissant un cadre reproductible, efficace et polyvalent, il élimine les obstacles critiques à l'innovation et vous permet de repousser les limites de la pertinence de la recherche.

Explorez la documentation et commencez à construire votre pipeline de classement de nouvelle génération avec confiance et clarté.

More information on RankLLM

RankLLM Alternatives

Plus Alternatives-

-

-

Découvrez, comparez et classez les modèles de langage volumineux sans effort avec LLM Extractum. Simplifiez votre processus de sélection et favorisez l'innovation dans les applications d'IA.

-

Le routage sémantique consiste à sélectionner dynamiquement le modèle linguistique le plus adéquat pour une requête d'entrée spécifique, en se basant sur son contenu sémantique, sa complexité et son intention. Au lieu de s'appuyer sur un modèle unique pour toutes les tâches, les routeurs sémantiques analysent l'entrée et l'acheminent vers des modèles spécialisés, conçus pour des domaines ou des niveaux de complexité particuliers.

-