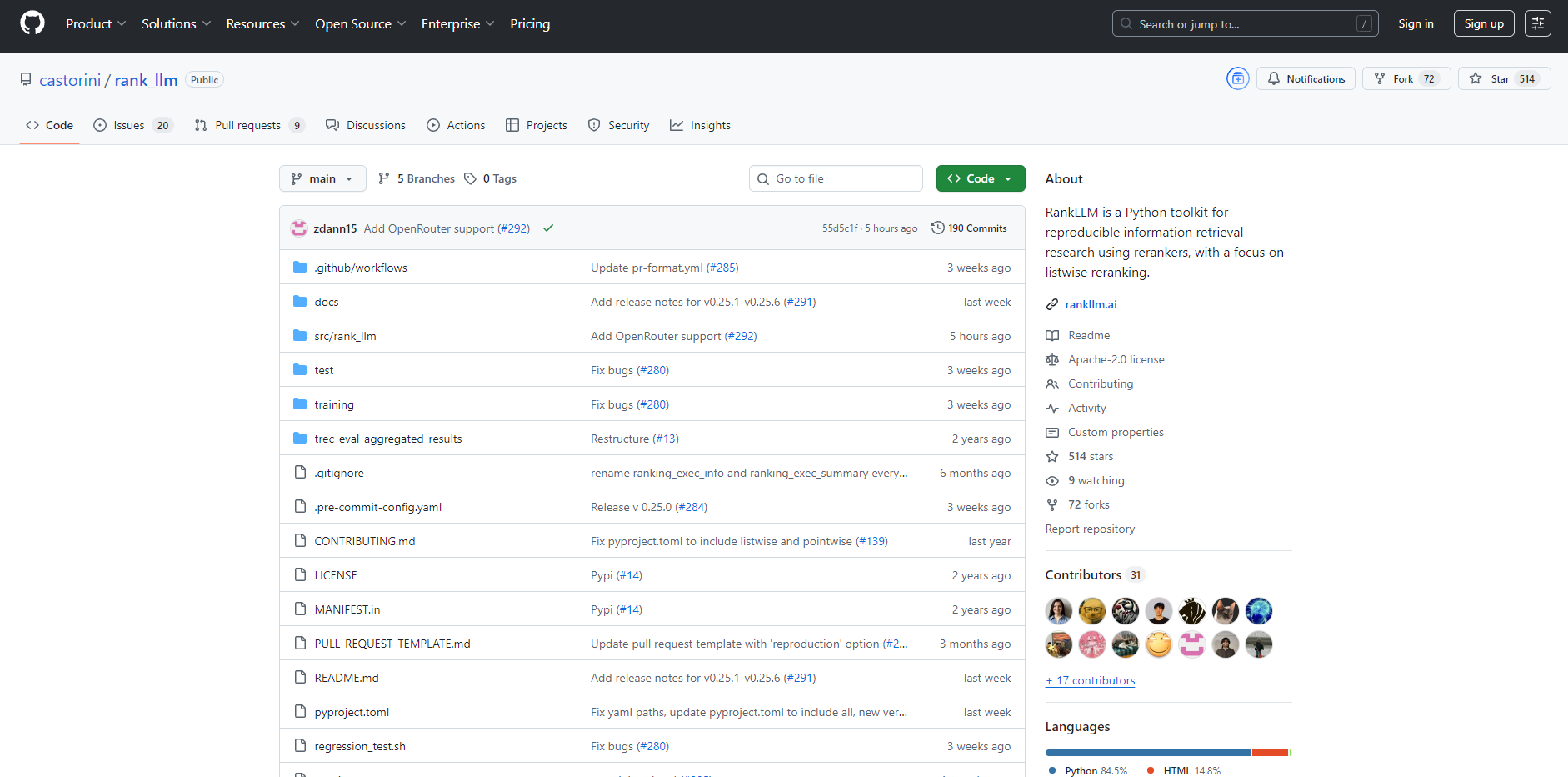

What is RankLLM?

RankLLM 是一款专为信息检索 (IR) 研究人员和工程师设计的综合性 Python 工具包,旨在为利用大型语言模型 (LLM) 提供一个稳健且可复现的框架。它系统性地解决了重排的复杂性,提供了一个统一的环境,可用于实验、评估和部署各种重排模型。RankLLM 简化了从检索、重排到评估的整个研究流程,并主要侧重于强大高效的列表式重排器。

主要特性

📚 多功能重排器支持 突破单一模型的局限。RankLLM 为多种重排范式提供统一接口,包括点式 (MonoT5)、对式 (DuoT5) 和先进的列表式模型。您可以在同一个工具包中无缝地实验 RankZephyr 和 RankVicuna 等开源 LLM,或集成 RankGPT 和 RankGemini 的专有 API。

⚡ 高性能推理 运行大规模实验,避免常见的性能瓶颈。RankLLM 专为高效而设计,直接支持 vLLM、SGLang 和 TensorRT-LLM 等尖端推理后端。这使得您的重排任务能够显著加速,从而使得处理更大规模的模型和数据集成为切实可行。

🔁 端到端可复现性 消除了 IR 研究中常见的猜测和繁琐的设置开销。凭借便捷的封装脚本和我们的“两键复现 (2CR)”命令,您可以轻松复现 MS MARCO 等标准数据集上关键研究论文的结果。这提供了可信的基线,让您能够专注于创新,而非繁琐的实现细节。

🗂️ 丰富且精选的模型库 通过工具包直接访问大量预训练和优化过的重排模型。模型库包括用于高效单次重排的完整 LiT5 套件、用于点式评分的各种 MonoT5 模型,以及 RankZephyr 等最新的列表式模型。这些精心挑选的模型可节省您的时间,并确保您使用的是经过验证的高质量重排器。

应用场景

比较重排架构: 作为研究人员,您可以使用 RankLLM 在您特定的数据集上,对 MonoT5 等点式模型、DuoT5 等对式模型和 RankZephyr 等列表式模型进行公平且受控的比较。该工具包负责处理繁琐的样板代码,让您能够专注于分析结果并得出清晰的结论。

建立强大的研究基线: 如果您是一名博士生或研究科学家,可以使用提供的 2CR 命令即时复现 DL19 和 DL20 等基准测试上的最先进结果。这为您提供了一个经过验证的高性能基线,可用于衡量您自己的新颖贡献。

构建高效重排服务: 对于工程团队而言,RankLLM 与 SGLang 或 TensorRT-LLM 的集成,为构建生产级搜索系统中的高吞吐量重排组件提供了明确的路径。您可以利用 RankZephyr 等模型来提高搜索相关性,同时保持低延迟。

为何选择 RankLLM?

该工具包旨在相对于构建自定义脚本或使用更通用的框架提供显著优势。原因如下:

专注于可复现性: 尽管复现 IR 研究往往是一大障碍,但 RankLLM 围绕着 两键复现 (2CR) 命令构建。这一承诺确保您能够自信地验证并基于前人工作进行深入研究,这是其他工具中鲜有具备的功能。

专注于列表式重排: 与许多止步于简单点式方法的工具包不同,RankLLM 为使用开源 LLM 的 先进列表式重排 提供了A级支持。这使您能够利用模型卓越的上下文理解能力,一次性评估整个文档列表。

为性能而设计: RankLLM 不依赖标准推理管道,而是直接集成 vLLM、SGLang 和 TensorRT-LLM 等高性能后端。这提供了一个开箱即用的推理加速解决方案,免去了您自行工程化开发的麻烦。

无与伦比的模型多样性: 该工具包提供了最 全面且组织良好的重排模型库 之一。它整合了来自 Castorini group 及其他机构的领先模型,为您提供了单一访问点,以获取适用于包括生物医学搜索在内的各种领域的点式、对式和列表式模型。

总结

RankLLM 是研究人员和实践者利用 LLM 力量实现最先进信息检索的权威工具包。通过提供一个可复现、高效且多功能的框架,它消除了创新的关键障碍,并使您能够拓展搜索相关性的边界。

查阅文档,充满信心、清晰地构建您的下一代排序管道。