What is Spice?

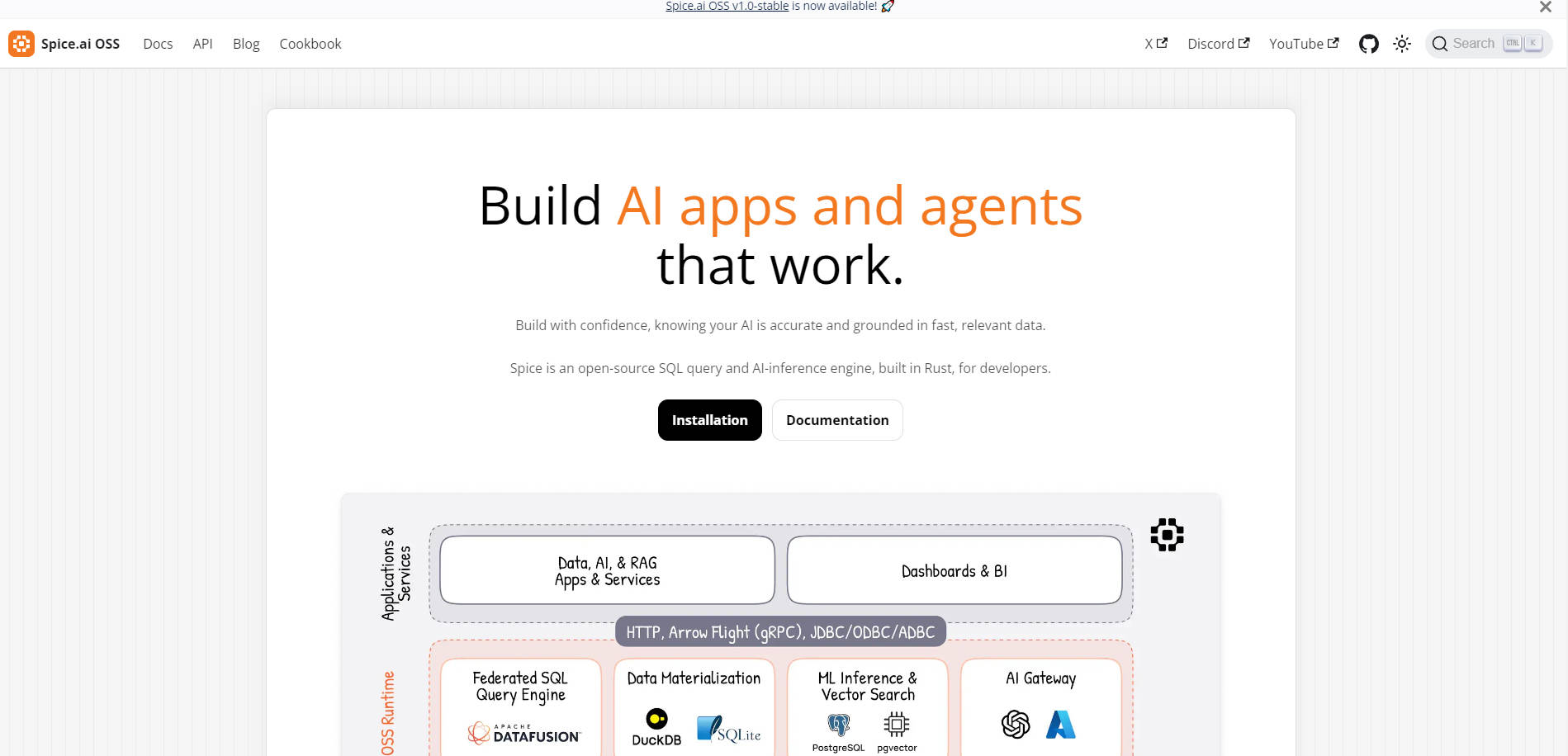

Spice est un moteur de requêtes SQL et de calcul IA open source, développé en Rust, conçu pour simplifier le développement d'applications IA basées sur les données. Que vous construisiez des agents intelligents, des workflows de génération augmentée par la recherche (RAG) ou des tableaux de bord d'analyse en temps réel, Spice fournit les outils nécessaires pour ancrer votre IA dans des données rapides, précises et pertinentes.

Pourquoi Spice ?

Spice est conçu pour les développeurs qui ont besoin d'un moteur léger, flexible et prêt pour la production afin d'alimenter leurs applications IA et de données. Voici ce qui le distingue :

Accès aux données fédérées : Interrogez les données structurées et non structurées à travers les bases de données, les entrepôts de données et les data lakes avec une API SQL unifiée.

Moteur de calcul IA : Utilisez des API compatibles OpenAI pour l'inférence locale ou hébergée, la recherche, la mémoire et l'observabilité.

Accélération des données : Matérialisez et mettez en cache les données dans DuckDB, SQLite ou PostgreSQL pour des performances de requête en moins d'une seconde.

Auto-hébergeable et open source : Déployez Spice en tant que binaire autonome ou image Docker, avec un contrôle total sur votre infrastructure.

Fonctionnalités clés

? Requêtes SQL fédérées

Interrogez les données à partir de sources multiples — bases de données, entrepôts ou lacs de données — avec une seule API SQL. Plus besoin de jongler avec plusieurs outils ou de subir des requêtes inter-systèmes lentes.

? Environnement d'exécution natif IA

Combinez les requêtes SQL avec l'inférence IA dans un seul moteur. Utilisez des modèles locaux ou hébergés, la mémoire LLM et des outils d'observabilité pour construire des applications intelligentes.

⚡ Accélération des données

Matérialisez les jeux de données dans Arrow, DuckDB ou SQLite pour des requêtes ultrarapides. Idéal pour les tableaux de bord en temps réel, les boucles de rétroaction IA et les workflows RAG.

? Flexibilité de déploiement

Exécutez Spice en tant qu'instance autonome, sidecar Kubernetes ou cluster distribué — sur les environnements Edge, sur site ou Cloud.

Cas d'utilisation

Applications IA agentives

Construisez des agents IA avec des modèles locaux ou hébergés, ancrés dans des données en temps réel. Utilisez la mémoire LLM et les outils d'observabilité de Spice pour suivre les performances et améliorer la précision.Génération augmentée par la recherche (RAG)

Assurez-vous que votre IA est ancrée dans les données grâce à des capacités de recherche hautes performances et de texte-vers-SQL. La recherche vectorielle et la couche de connaissance sémantique de Spice rendent les workflows RAG transparents.Réseau de diffusion de contenu (CDN) de base de données

Co-localisez les jeux de données avec vos applications pour des performances de requête en moins d'une seconde. Idéal pour accélérer les tableaux de bord BI ou l'analyse en temps réel.Maillage de données distribué

Interrogez les bases de données, les entrepôts et les lacs de données grâce à une fédération avancée. Simplifiez les migrations existantes et unifiez les systèmes modernes et hérités sous un seul point d'accès.

FAQ

1. Spice est-il un cache ?

Pas exactement. Spice précharge et matérialise les données en fonction de filtres ou d'intervalles, agissant comme un cache actif ou un préchargeur de jeux de données de travail.

2. Spice peut-il gérer les requêtes fédérées ?

Oui ! Spice prend en charge le transfert avancé de requêtes à travers les bases de données, les entrepôts et les lacs de données pour une récupération de données rapide et efficace.

3. Quelles capacités IA Spice offre-t-il ?

Spice fournit des API compatibles OpenAI pour l'inférence, les embeddings et la mémoire. Il prend également en charge le service de modèles locaux et s'intègre à des fournisseurs populaires tels qu'OpenAI et Anthropic.

Spice est le moteur dont vous avez besoin pour construire des applications et des agents IA qui fonctionnent — rapidement, précisément et ancrés dans les données. Essayez-le dès aujourd'hui et constatez la différence par vous-même.