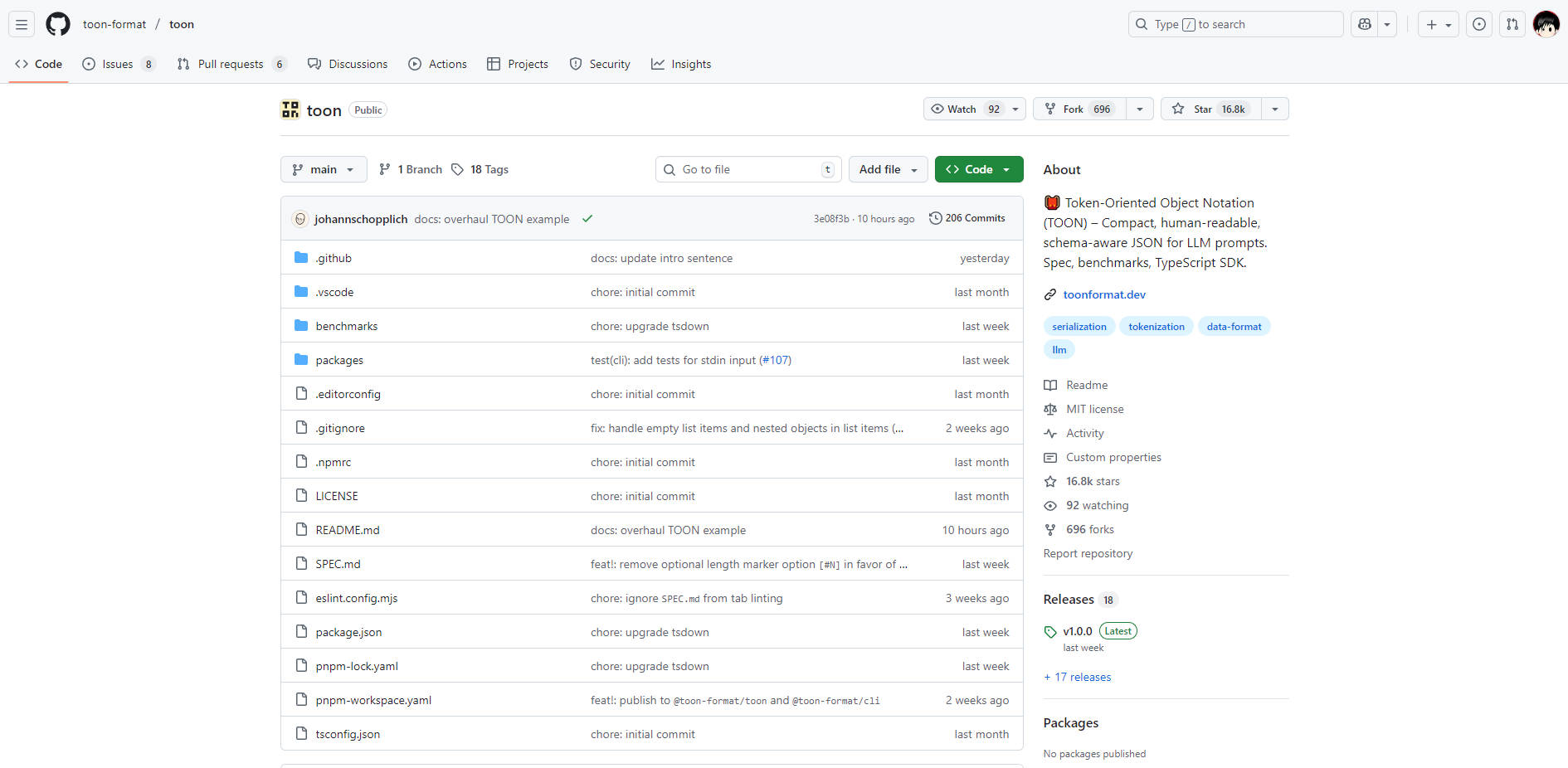

What is TOON?

TOON est un format de sérialisation de données compact et sensible au schéma, conçu spécifiquement pour réduire les coûts et améliorer la fiabilité des entrées de données volumineuses pour les grands modèles linguistiques (LLM). Tout en conservant une fidélité totale au modèle de données JSON standard, TOON utilise une syntaxe lisible par l'homme qui minimise considérablement le nombre de jetons, ce qui en fait la couche de traduction idéale pour transmettre efficacement des données structurées dans vos pipelines LLM.

Si vous travaillez avec de grands ensembles de données, des objets de configuration ou des tableaux uniformes qui repoussent les limites de votre fenêtre de contexte, TOON offre un mécanisme puissant pour réduire les coûts d'API et garantir que vos données sont analysées de manière fiable par le modèle.

Caractéristiques Principales

TOON est conçu pour offrir l'intégrité structurelle de JSON avec l'efficacité de jetons des formats légers, en s'appuyant sur des garde-fous explicites très efficaces pour la consommation par les LLM.

💸 Réduction significative du nombre de jetons : Réalisez des économies de jetons typiques de 30 à 60 % par rapport au JSON formaté, en particulier lors du traitement de grands tableaux uniformes d'objets. Cette réduction se traduit directement par des coûts opérationnels moindres et la capacité d'intégrer beaucoup plus de données dans une fenêtre de contexte fixe.

🤿 Garde-fous et validation adaptés aux LLM : Contrairement aux formats bruts comme CSV, TOON inclut des métadonnées structurelles explicites, telles que les longueurs de tableau (par exemple, items[3]) et les en-têtes de champ ({sku,qty,price}). Ces garde-fous explicites permettent au modèle de suivre la structure de manière fiable, réduisant les erreurs d'analyse et améliorant la précision des tâches de récupération de données.

🧺 Tableaux tabulaires efficaces : Le point fort de TOON est son format de tableau tabulaire, qui combine la structure des objets avec l'efficacité de CSV. En déclarant les clés une seule fois dans l'en-tête, vous pouvez diffuser les données subséquentes sous forme de lignes simples, séparées par des virgules ou des tabulations. Cette syntaxe minimale élimine la ponctuation redondante (accolades, crochets et la plupart des guillemets) qui rend le JSON standard coûteux en jetons.

🔗 Repliement de clés optionnel pour les données imbriquées : Gérez efficacement les objets profondément imbriqués grâce au repliement de clés optionnel. Cette fonctionnalité regroupe les chaînes d'enveloppes à clé unique en chemins pointés (par exemple, data.metadata.items) afin de réduire davantage les surcharges d'indentation et le nombre de jetons sans sacrifier la structure d'origine.

Cas d'utilisation

TOON sert de couche d'optimisation cruciale entre votre structure de données programmatique (JSON) et votre couche d'interaction LLM.

Analyse et résumé de données économiques : Lors de l'alimentation d'un LLM avec de grands volumes de journaux structurés, de transactions financières ou de données d'événements utilisateur pour la synthèse ou la reconnaissance de motifs, encoder l'entrée en TOON peut réduire considérablement le coût de l'entrée du prompt. Par exemple, encoder 100 000 lignes de journaux d'événements uniformes en TOON plutôt qu'en JSON peut réduire l'utilisation de jetons de plus de 20 %, vous permettant de traiter plus de données par dollar.

Génération de sortie et appel de fonctions fiables : Améliorez le taux de réussite des tâches de sortie structurées. En demandant au modèle de générer des réponses au format TOON, vous exploitez la longueur explicite des tableaux et les en-têtes de champ, qui agissent comme des indices puissants. Cela réduit la tendance du LLM à omettre des champs ou à mal compter les éléments, garantissant que les données générées restent valides et faciles à ré-analyser en JSON à l'aide du TOON SDK.

Modernisation des pipelines JSON existants : Si votre backend utilise JSON pour la communication interne mais alimente un service LLM, utilisez le TOON TypeScript SDK ou CLI pour encoder automatiquement les données juste avant la soumission à l'API et décoder la réponse à la réception. Cela procure des économies de coûts immédiates et mesurables sans vous obliger à réécrire vos modèles de données fondamentaux ni à abandonner le standard JSON.

Avantages Uniques : Efficacité et Précision Éprouvées

TOON n'est pas seulement un format compact ; il est optimisé spécifiquement pour la compréhension des LLM et l'efficacité des jetons, ce qui se traduit par des performances supérieures sur les modèles courants.

| Métrique | Performance TOON | vs. JSON formaté | Aperçu |

|---|---|---|---|

| Efficacité des jetons (moy.) | 2 744 jetons | 39,6 % de jetons en moins | Réduit considérablement les coûts d'API et augmente la taille de la fenêtre de contexte utilisable. |

| Précision de récupération (moy.) | 73,9 % | +4,2 % de précision supérieure | La structure explicite (longueur et champs) aide les LLM à analyser les données plus fiablement, améliorant ainsi la compréhension et réduisant les erreurs de récupération. |

| Classement d'efficacité | 26,9 (Précision par 1K jetons) | Classement le plus élevé | TOON offre le meilleur équilibre entre la précision du modèle et le coût des jetons pour diverses structures de données. |

Lors de comparaisons directes entre des modèles comme Gemini, Claude et GPT, TOON démontre constamment que sa syntaxe unique transmet les informations au modèle de la manière la plus efficace et robuste possible.

Quand utiliser d'autres formats

Bien que TOON excelle avec les données structurées, il est important de comprendre ses limitations pour maximiser l'efficacité :

- Données profondément imbriquées ou très non uniformes : Si vos données comportent de nombreux niveaux imbriqués et peu ou pas de tableaux uniformes (par exemple, des fichiers de configuration complexes), le JSON compact standard pourrait utiliser moins de jetons.

- Données purement tabulaires : Pour les tableaux plats sans imbrication ni exigences de métadonnées structurelles, CSV reste le format le plus efficace en termes de jetons, bien que TOON n'ajoute qu'un surcoût minimal de 5 à 10 % pour fournir une structure et une validation cruciales.

- Modèles locaux critiques en latence : Dans certains environnements critiques en latence (en particulier les modèles locaux ou quantifiés), la simplicité du JSON compact pourrait entraîner un Time-To-First-Token (TTFT) plus rapide. Réalisez toujours des tests comparatifs (benchmarks) de votre déploiement exact si la micro-latence est votre priorité absolue.

Conclusion

TOON offre une solution professionnelle et vérifiable pour le défi persistant de l'entrée de données LLM : des coûts de jetons élevés et une analyse incohérente. En traduisant votre JSON dans ce format compact et sensible au schéma, vous obtenez des avantages immédiats et mesurables tant en efficacité opérationnelle qu'en précision de récupération des données.

More information on TOON

TOON Alternatives

Plus Alternatives-

-

-

Déployez un Markdown structuré qui réduit la consommation de tokens jusqu'à 70 %, préserve la structure sémantique intacte et s'intègre directement dans vos flux de travail RAG ou d'agents. Zéro installation, zéro friction — téléchargez simplement et obtenez instantanément un résultat optimisé par l'IA.

-

-