What is JetMoE-8B?

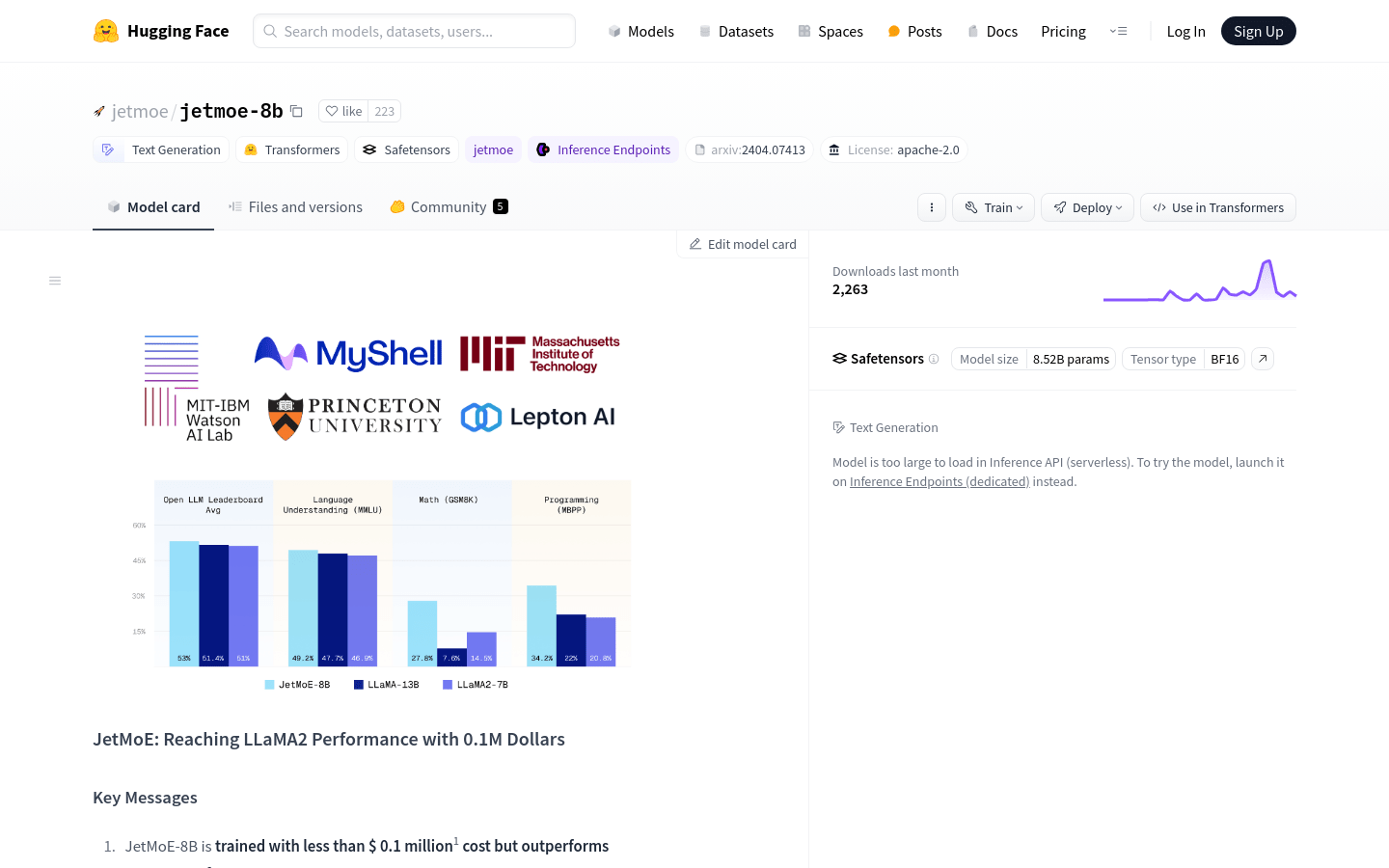

Yikang Shen、Zhen Guo、Tianle Cai、Zengyi Qinが開発したJetMoE-8Bは、最小限のコストでトレーニングされたオープンソースの、アカデミアに優しいAIモデルです。100万ドル未満という控えめなトレーニング予算にもかかわらず、JetMoE-8BはLLaMA2-7Bなどの数十億ドル規模のモデルを上回っています。JetMoE-8Bはパブリックデータセットと手頃な価格のコンピューティングリソースのみを使用し、費用対効果が高く高性能な言語モデルの新たな基準を打ち立てています。

主な機能:

?? 手頃な価格のトレーニング:コンシューマーグレードのGPUでわずか100万ドルでトレーニングされたJetMoE-8Bは、品質を犠牲にすることなく費用効率の高いAI開発を実現します。

? 高性能:推論中に22億個のアクティブパラメータを使用したJetMoE-8Bは、Gemma-2Bなどの同様の計算コストを持つモデルと比較して優れたパフォーマンスを実現します。

? オープンソース:パブリックデータセットとオープンソースのコードのみを使用するJetMoE-8Bは、AIコミュニティにおけるコラボレーションとアクセシビリティを促進します。

ユースケース:

カスタマーサポートの強化:JetMoE-8Bは、顧客の問い合わせに効率的かつ正確な応答を提供するチャットボットに利用でき、ユーザーの満足度を向上させ、サポートチームの作業負荷を軽減します。

研究支援:学術機関はJetMoE-8Bを活用して自然言語処理タスクを実施し、言語学、心理学、社会科学などの分野での進歩を促進できます。

パーソナライズされたコンテンツの生成:コンテンツクリエイターは、JetMoE-8Bを使用して、カスタマイズされた記事、製品の説明、またはマーケティング資料を生成し、エンゲージメントとコンバージョン率を最適化できます。

結論:

JetMoE-8BはAI開発における画期的な成果であり、従来のモデルのほんの一部のコストで比類のないパフォーマンスを提供します。学術研究、商用アプリケーション、社会的な影響のいずれにおいても、JetMoE-8Bは、多額の費用をかけずに最先端の言語モデルの力を利用できるようにします。JetMoE-8Bの効率性と効果を今すぐ体験し、AIイノベーションの最前線に加わりましょう。