What is JetMoE-8B?

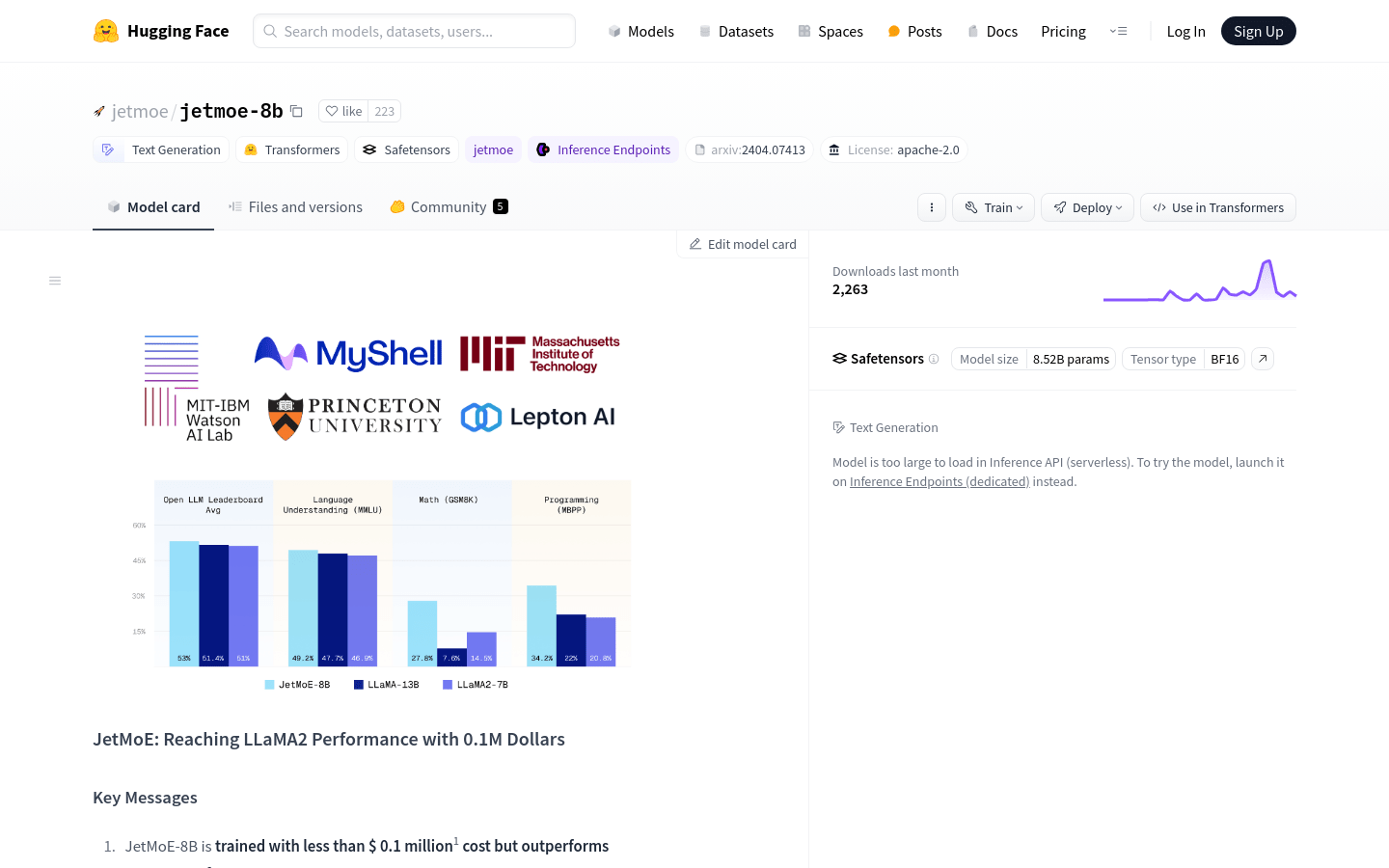

JetMoE-8B 由 Yikang Shen、Zhen Guo、Tianle Cai 和 Zengyi Qin 开发,是一款开源的、学术界友好的 AI 模型,以最低成本进行训练。尽管其训练预算仅为 10 万美元,但 JetMoE-8B 超越了数十亿美元的模型,如 LLaMA2-7B。仅使用公共数据集和负担得起的计算资源,JetMoE-8B 为高性价比、高性能语言模型设定了新标准。

主要特点:

-

?? 经济实惠的训练:JetMoE-8B 仅在消费级 GPU 上花费 10 万美元进行训练,展示了经济高效的 AI 开发,同时不牺牲质量。

-

? 高性能:在推理期间拥有 22 亿个活动参数,与计算成本相似的模型(如 Gemma-2B)相比,JetMoE-8B 实现了卓越的性能。

-

? 开源:仅利用公共数据集和开源代码,JetMoE-8B 促进了 AI 社区的协作和可访问性。

用例:

-

增强客户支持:JetMoE-8B 可以为聊天机器人提供支持,以对客户查询提供高效且准确的响应,从而提高用户满意度并减少支持团队的工作量。

-

研究辅助:学术机构可以利用 JetMoE-8B 进行自然语言处理任务,促进语言学、心理学和社会科学等领域的进步。

-

个性化内容生成:内容创建者可以使用 JetMoE-8B 生成定制文章、产品描述或营销材料,优化参与度和转化率。

结论:

JetMoE-8B 代表了 AI 开发的突破,以传统模型一小部分的成本提供了无与伦比的性能。无论是用于学术研究、商业应用还是社会影响,JetMoE-8B 都使用户能够利用最先进的语言模型的力量,而无需耗费巨资。立即体验 JetMoE-8B 的高效性和有效性,加入 AI 创新的前沿。

More information on JetMoE-8B

Launched

Pricing Model

Free

Starting Price

Global Rank

Follow

Month Visit

<5k

Tech used