What is JetMoE-8B?

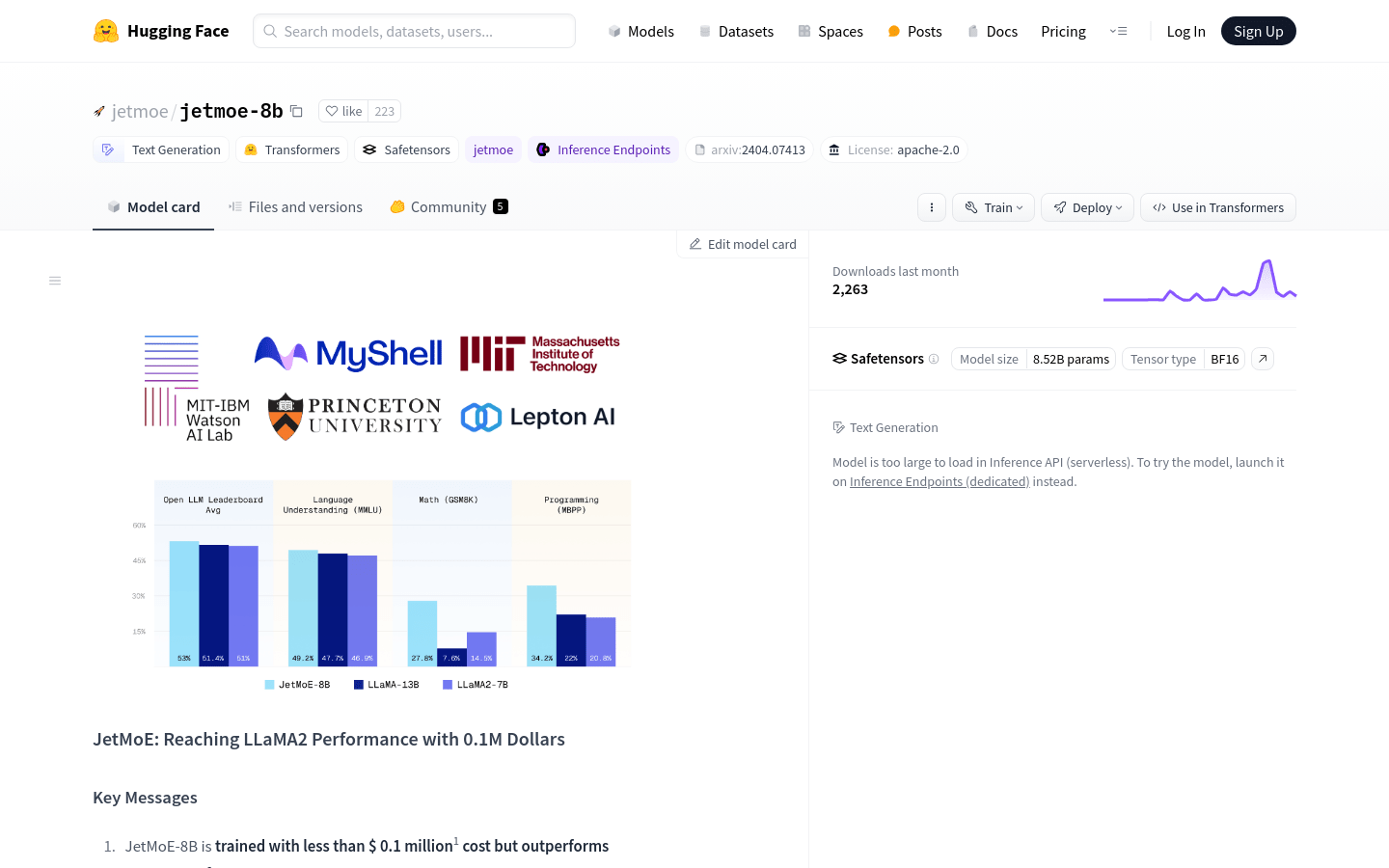

Yikang Shen, Zhen Guo, Tianle Cai, Zengyi Qin이 개발한 JetMoE-8B는 최소한의 비용으로 훈련된 오픈 소스의 학계 친화적인 AI 모델입니다. 100만 달러 미만의 적은 훈련 비용에도 불구하고 JetMoE-8B는 LLaMA2-7B와 같은 수십억 달러 규모의 모델을 능가합니다. JetMoE-8B는 공개 데이터 세트와 저렴한 컴퓨팅 리소스만을 사용하여 비용 효율적이고 성능이 뛰어난 언어 모델에 대한 새로운 표준을 설정합니다.

주요 특징:

?? 저렴한 훈련: 소비자용 GPU에서 단 100만 달러로 훈련된 JetMoE-8B는 품질을 희생하지 않고도 비용 효율적인 AI 개발을 보여줍니다.

? 높은 성능: 추론 중에 22억 개의 활성 파라미터를 사용하는 JetMoE-8B는 Gemma-2B와 같이 유사한 계산 비용을 가진 모델에 비해 뛰어난 성능을 달성합니다.

? 오픈 소스: 공개 데이터 세트와 오픈 소스 코드만을 사용하여 JetMoE-8B는 AI 커뮤니티에서 협업과 접근성을 촉진합니다.

사용 사례:

고객 지원 향상: JetMoE-8B는 채팅봇에 힘을 실어 고객 문의에 효율적이고 정확하게 대응하여 사용자 만족도를 높이고 지원 팀의 업무량을 줄입니다.

연구 지원: 학술 기관은 자연어 처리 과제에 JetMoE-8B를 활용하여 언어학, 심리학, 사회과학과 같은 분야의 발전을 촉진할 수 있습니다.

개인 맞춤형 콘텐츠 생성: 콘텐츠 제작자는 JetMoE-8B를 사용하여 맞춤형 기사, 제품 설명 또는 마케팅 자료를 생성하여 참여도와 전환율을 최적화할 수 있습니다.

결론:

JetMoE-8B는 AI 개발의 획기적인 사건으로, 기존 모델의 비용의 일부에 불과한 비용으로 탁월한 성능을 제공합니다. 학술 연구, 상업적 응용 또는 사회적 영향을 위한 것이든, JetMoE-8B를 통해 사용자는 엄청난 비용 없이 최첨단 언어 모델의 힘을 활용할 수 있습니다. 지금 바로 JetMoE-8B의 효율성과 효과를 경험하고 AI 혁신의 최전선에 합류하세요.