What is JetMoE-8B?

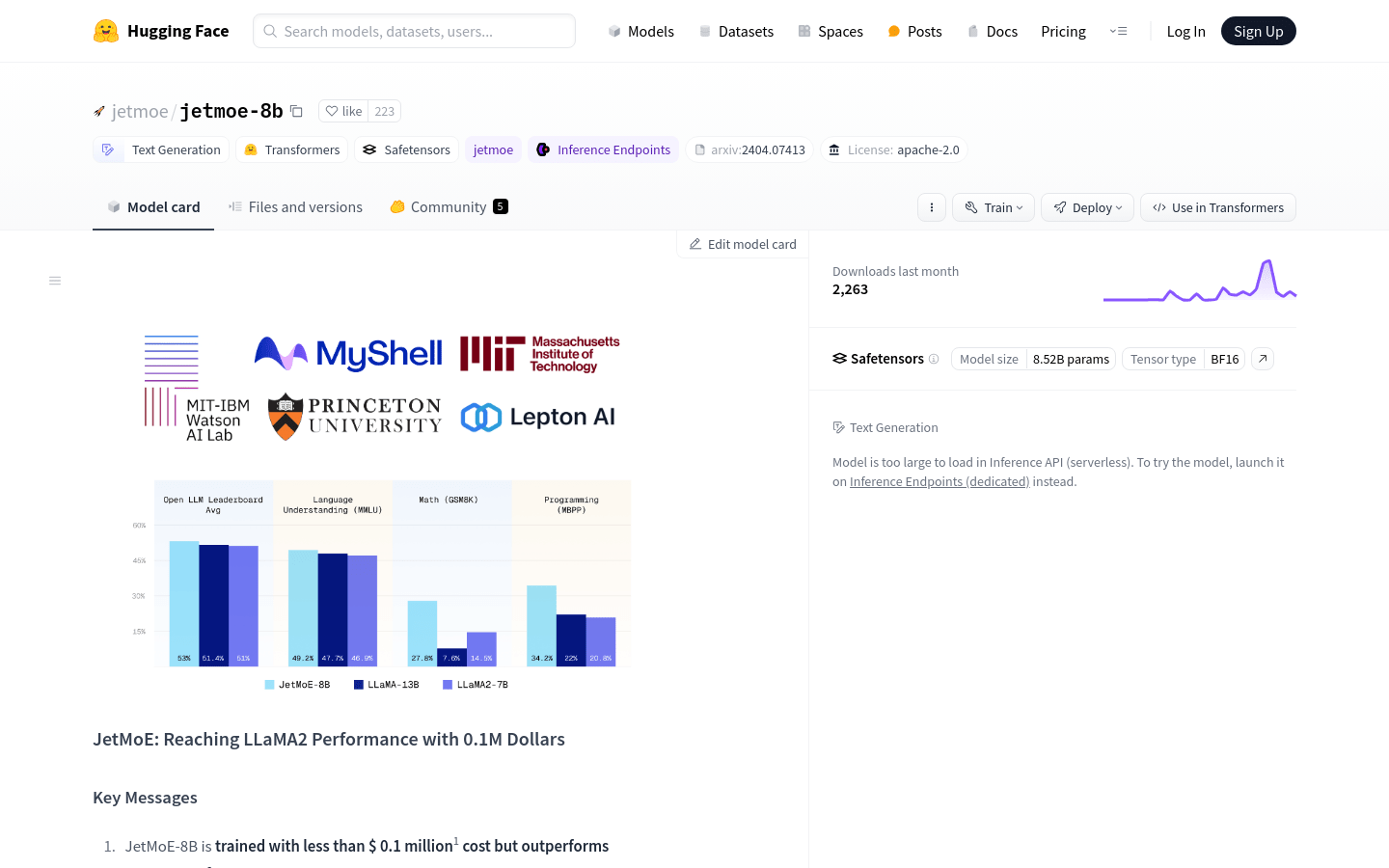

由 Yikang Shen、Zhen Guo、Tianle Cai 及 Zengyi Qin 所開發的 JetMoE-8B 是一款開放原始碼、對學術界友善、訓練成本極低的 AI 模型。儘管其訓練預算不到 100 萬美元,JetMoE-8B 卻超越了 LLaMA2-7B 等數十億美元的模型。僅以公開的資料集和經濟實惠的運算資源,JetMoE-8B 為具成本效益、高性能的語言模型樹立了新標準。

主要特色:

?? 經濟實惠的訓練:僅使用消費者等級的 GPU 以 100 萬美元訓練,JetMoE-8B 示範了在不犧牲品質的情況下,以具成本效益的方式開發 AI。

? 高性能:在推論期間有 22 億個活躍參數,JetMoE-8B 達到了較同等運算成本模型(例如 Gemma-2B)更優異的性能。

? 開放原始碼:僅採用公開資料集和開放原始碼,JetMoE-8B 促進了 AI 社群中的協作和可及性。

使用案例:

增強客戶支援:JetMoE-8B 可強化聊天機器人,讓其能提供有效且準確的回應,進而提升使用者滿意度,並減輕支援團隊的工作負擔。

研究協助:學術機構可利用 JetMoE-8B 進行自然語言處理任務,促進語言學、心理學和社會科學等領域的進步。

個人化內容產生:內容建立者可以使用 JetMoE-8B 產生客製化的文章、產品說明或行銷素材,最佳化參與度及轉換率。

結論:

JetMoE-8B 代表了 AI 發展的突破,以傳統模型成本的一小部分提供無與倫比的性能。無論是為了學術研究、商業應用,還是社會影響,JetMoE-8B 都能讓使用者利用最先進的語言模型的力量,而無需大筆花費。立即體驗 JetMoE-8B 的效率和效能,並加入 AI 創新的最前線。

More information on JetMoE-8B

Launched

Pricing Model

Free

Starting Price

Global Rank

Follow

Month Visit

<5k

Tech used