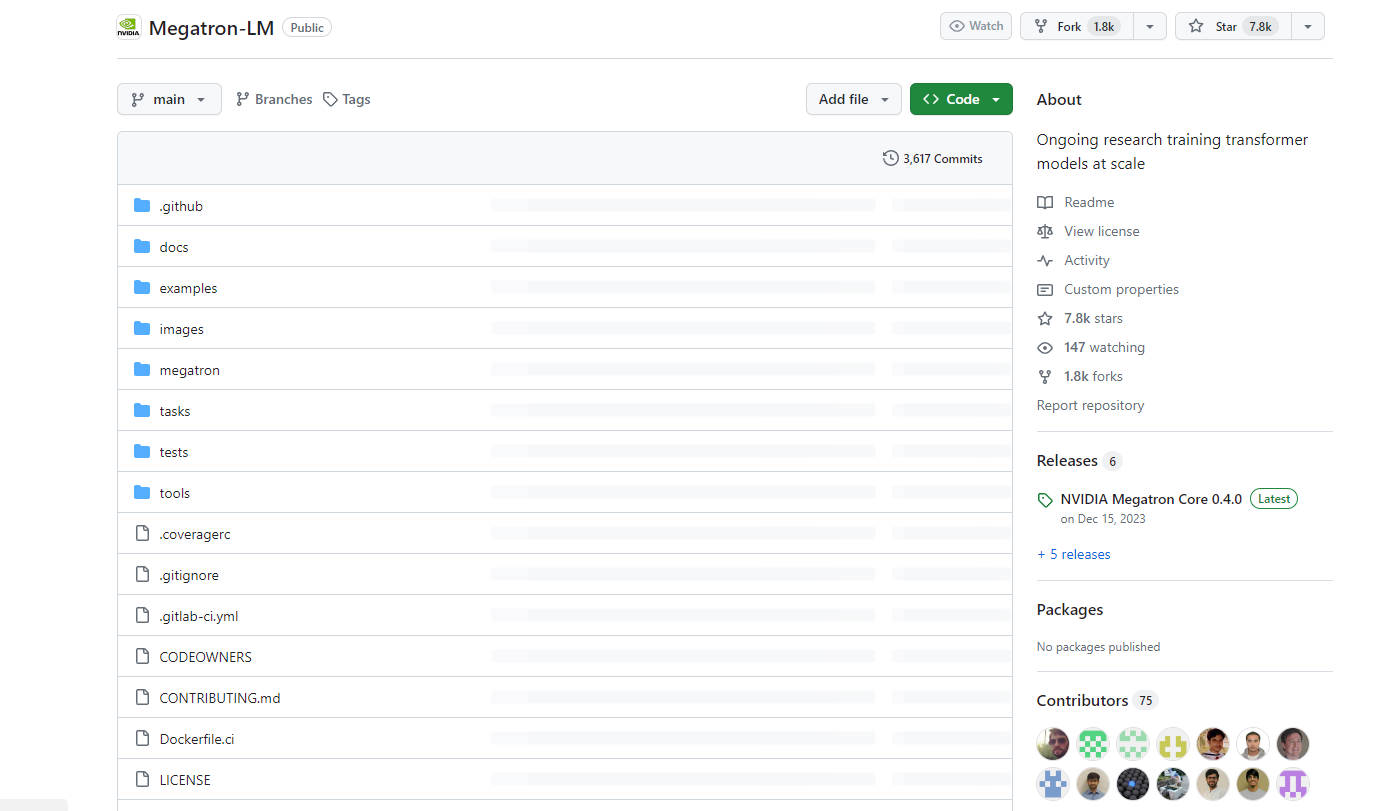

What is Megatron-LM?

NVIDIAが開発したMegatronは、大規模な言語モデルのトレーニングを効率化する強力なトランスフォーマーです。GPT、BERT、T5などのモデルに対して、効率的なモデルパラレルおよびマルチノード事前トレーニング機能を提供します。Megatronにより、企業は数十億から数兆のパラメーターを持つ、高度な自然言語処理モデルの構築とトレーニングの課題を克服できます。

主な機能:

? 効率的なトレーニング: Megatronは、モデルパラレルとデータパラレルの両方を使用して、数百億のパラメーターを持つ言語モデルの効率的なトレーニングを可能にします。

? モデルパラレル: テンソル、シーケンス、パイプラインのモデルパラレルをサポートし、複数のGPUとノード間でモデルを拡張できます。

? 多様な事前トレーニング: Megatronは、GPT、BERT、T5などのさまざまなトランスフォーマーベースのモデルの事前トレーニングを容易にし、大規模生成言語モデルの開発を可能にします。

ユースケース:

? 言語モデリング: Megatronは、大規模言語モデルの事前トレーニングに使用され、テキスト生成、翻訳、要約などのタスクのための強力なモデルの作成を可能にします。

?️ 情報検索: オープン領域の質問応答に対するニューラルレトリバーのトレーニングに使用され、検索結果の精度と関連性を向上させます。

? 対話エージェント: Megatronは、大規模なマルチアクター生成対話モデリングを可能にすることで対話エージェントに力を与え、自動化された会話の品質と自然さを向上させます。

結論:

Megatronは、NVIDIAによって開発された最先端のAIツールで、大規模なトランスフォーマーモデルをトレーニングするように設計されています。効率的なトレーニング機能、モデルパラレルのサポート、さまざまな言語モデルの事前トレーニングの汎用性を備えたMegatronは、企業が優れたパフォーマンスと精度を備えた、高度な自然言語処理モデルの構築とトレーニングを可能にします。言語モデリング、情報検索、対話エージェントのいずれであっても、MegatronはAI研究者と開発者にとって貴重な資産です。

More information on Megatron-LM

Megatron-LM 代替ソフト

もっと見る 代替ソフト-

Tsinghua大学のKVCache.AIチームとQuJing Techが開発したオープンソースプロジェクト、KTransformersは、大規模言語モデルの推論を最適化します。ハードウェアの敷居を下げ、24GB VRAMのシングルGPU上で671Bパラメータのモデルを実行可能にし、推論速度を向上(前処理最大286トークン/秒、生成最大14トークン/秒)させ、個人利用、企業利用、学術利用に適しています。

-

Transformer Lab:コーディング不要で、LLMをローカル環境で構築、チューニング、実行できるオープンソースプラットフォーム。数百ものモデルをダウンロードし、様々なハードウェアでファインチューニング、チャット、評価など、様々な機能をご利用いただけます。

-

MonsterGPT: チャットを通じてカスタムAIモデルのファインチューニングとデプロイが可能。複雑なLLM・AIタスクを簡素化し、60種類以上のオープンソースモデルに手軽にアクセスできます。

-

NVIDIA NeMo および NVIDIA TensorRT-LLM 向けに最適化されたモデルファミリーである Nemotron-4 340B は、最先端の指示モデルと報酬モデル、ならびに生成 AI トレーニング用のデータセットを含んでいます。

-