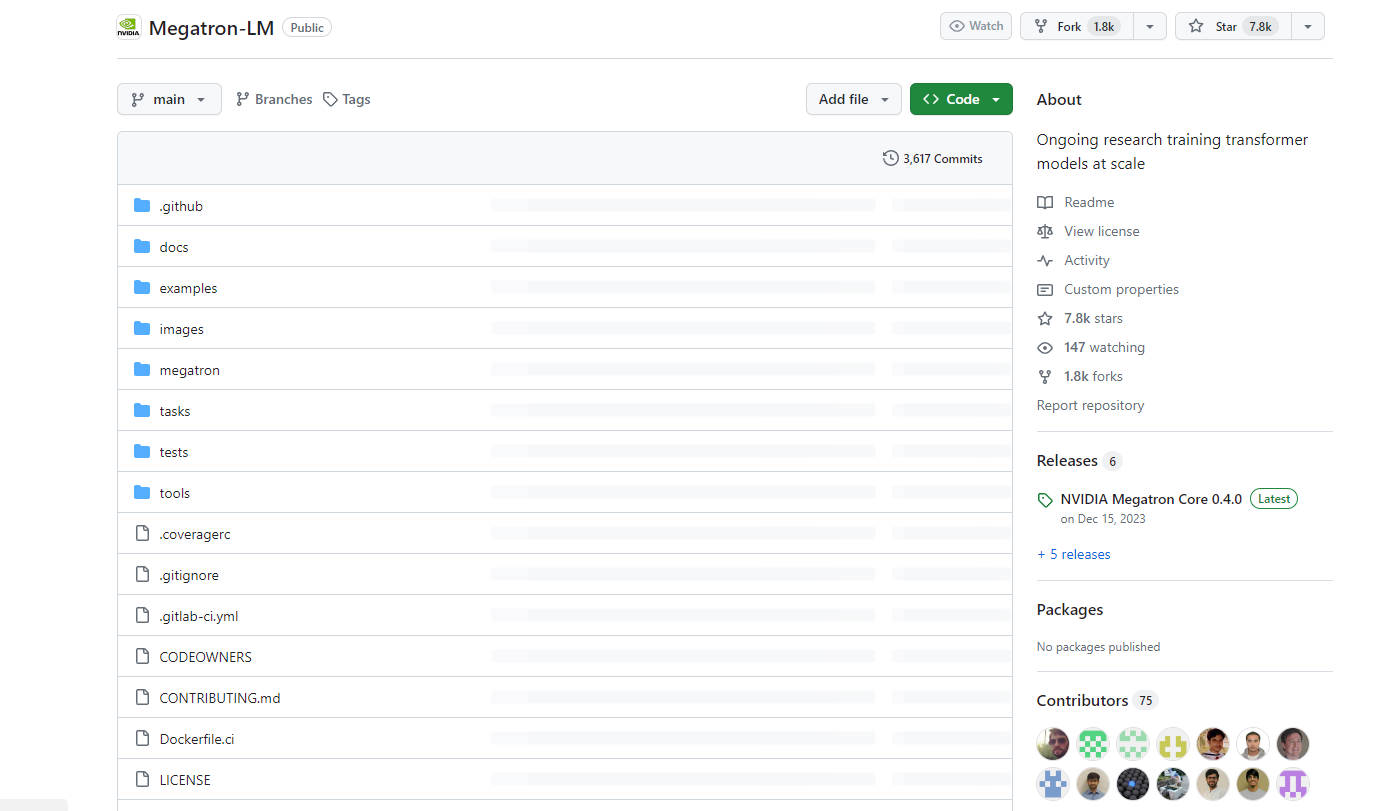

What is Megatron-LM?

Megatron 是由NVIDIA研發的強大轉換器,可大規模訓練大型語言模型。它為大型語言模型(如:Generative Pre-trained Transformers (Generative Pre-trained Transformers)、BERT 和 T5)提供高效的模型平行和多節點預訓練功能。使用 Megatron,企業可以輕鬆建立並訓練參數量達數十億甚至數兆的進階自然語言處理模型。

主要功能:

? 訓練:Megatron 能夠使用模型和資料有效訓練參數量達數百億個的語言模型。

? 模型平行:它支援張量、序列和平行模型平行,允許模型在多個節點和節點間擴充。

? 多功能預訓練:Megatron 簡化了各種基於轉換器的模型(例如:Generative Pre-trained Transformers (Generative Pre-trained Transformers)、BERT 和 T5)的預訓練,能建立大型生成式語言模型。

使用案例:

? 語言建模:Megatron 用於大型語言模型預訓練,能建立功能強大的模型,用於文字生成、翻譯和摘要等任務。

?️ 資訊檢索:它用於訓練開放領域問答的神經檢索器,以提高搜尋結果的準確性和相關性。

? 會話代理人:Megatron 採用大型多重行為者生成式對話建模,為會話代理人提供支援,提升自動對話的品質和自然度。

結論:

Megatron 是由NVIDIA研發的尖端 AI 工具,旨在大規模訓練大型轉換器模型。Megatron 具有有效訓練功能、支援模型平行,以及預訓練各種語言模型的多功能性,讓企業可以輕鬆建立並訓練精密的自然語言處理模型,並達到卓越效能和準確度。無論是語言建模、資訊檢索或會話代理人,Megatron 都是 AI 研究人員和工程師不可或缺的資產。

More information on Megatron-LM

Megatron-LM 替代方案

更多 替代方案-

KTransformers 是由清華大學 KVCache.AI 團隊與 QuJing Tech 共同開發的開源專案,旨在優化大型語言模型的推論過程。它能降低硬體門檻,讓使用者僅需配備 24GB 顯示記憶體的單張 GPU,即可運行 6710 億參數的模型。此外,它還能大幅提升推論速度(預處理階段最高可達每秒 286 個 tokens,生成階段最高可達每秒 14 個 tokens),非常適合個人、企業以及學術機構使用。

-

Transformer Lab:一個開源平台,讓您可在本地端建構、微調和執行大型語言模型 (LLM),無需編碼。下載數百個模型,跨硬體微調,聊天、評估等等。

-

MonsterGPT:透過對話輕鬆微調並部署專屬AI模型。讓複雜的大型語言模型(LLM)與人工智慧(AI)任務變得更簡單。輕鬆存取超過 60 個開源模型。

-

Nemotron-4 340B,是一系列針對 NVIDIA NeMo 和 NVIDIA TensorRT-LLM 優化的模型,包含最先進的指令和獎勵模型,以及用於生成式 AI 訓練的數據集。

-