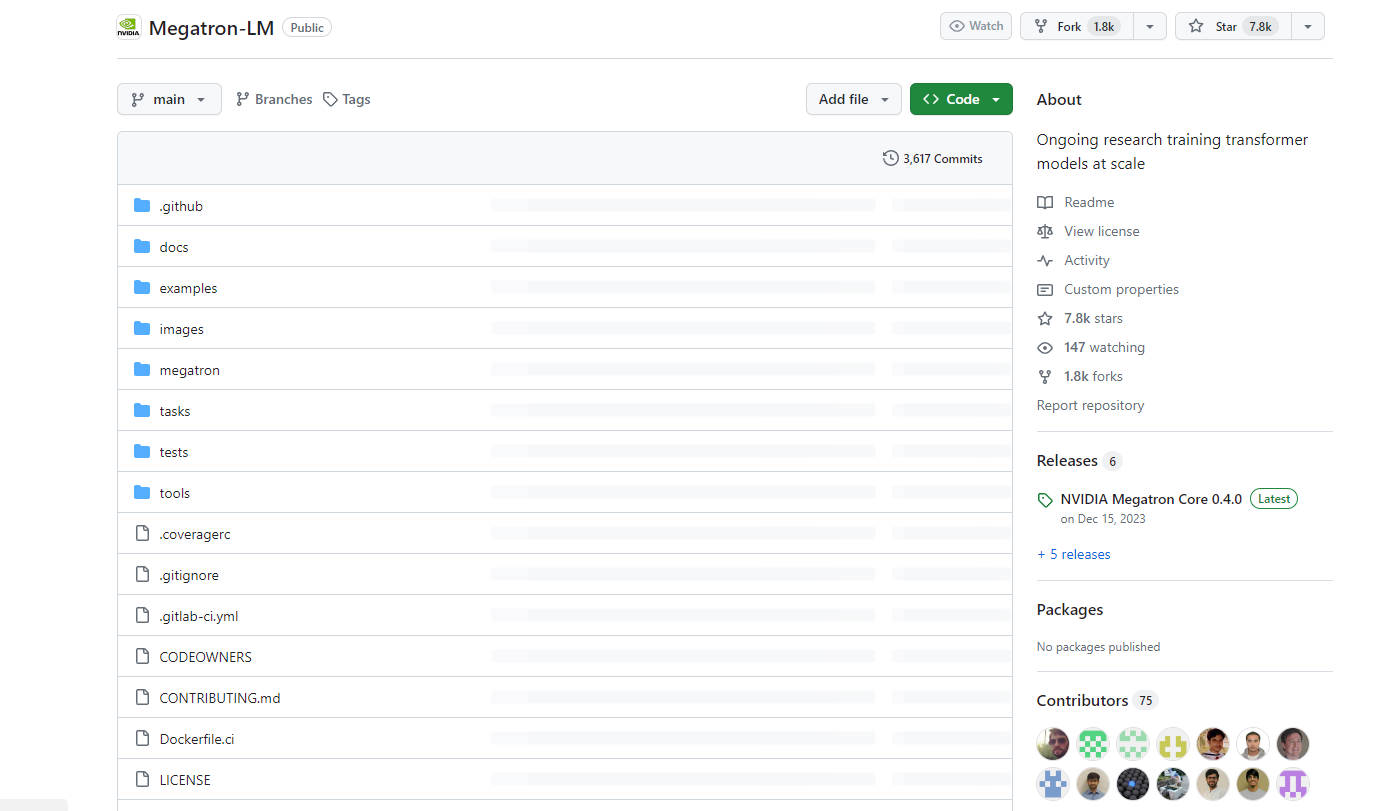

What is Megatron-LM?

Megatron 是 NVIDIA 为大规模训练大语言模型而开发的一个功能强大的转换器。它为 GPT、BERT 和 T5 等模型提供了高效的模型并行和多节点预训练功能。借助 Megatron,企业可以克服构建和训练包含数十亿和数万亿个参数的复杂自然语言处理模型的挑战。

主要功能:

? 高效训练:Megatron 能够利用模型和数据并行性,高效训练包含数百亿个参数的语言模型。

? 模型并行:它支持张量、序列和管道模型并行,允许模型跨多个 GPU 和节点进行扩展。

? 多功能预训练:Megatron 便于预训练各种基于转换器的模型,如 GPT、BERT 和 T5,使得能够开发大规模生成式语言模型。

用例:

? 语言建模:Megatron 用于大规模语言模型预训练,能够创建用于文本生成、翻译和摘要等任务的强大模型。

?️ 信息检索:它用于训练开放域问题解答的神经检索器,提高搜索结果的准确性和相关性。

? 会话代理:Megatron 通过启用大规模多参与者生成式对话建模来增强会话代理,从而提高自动化对话的质量和自然性。

结论:

Megatron 是 NVIDIA 开发的尖端 AI 工具,旨在大规模训练大型转换器模型。凭借其高效的训练能力、对模型并行的支持以及在预训练各种语言模型方面的多功能性,Megatron 使企业能够构建和训练复杂自然语言处理模型,并实现卓越的性能和准确性。无论是语言建模、信息检索还是会话代理,Megatron 都是 AI 研究人员和开发人员的宝贵资产。

More information on Megatron-LM

Megatron-LM 替代

Megatron-LM 替代-

KTransformers 是由清华大学 KVCache.AI 团队和 QuJing Tech 共同开发的开源项目,旨在优化大型语言模型的推理过程。它能够降低硬件门槛,在 24GB 显存的单 GPU 上运行 6710 亿参数的模型,并提升推理速度(预处理速度高达 286 tokens/s,生成速度高达 14 tokens/s),适用于个人、企业和学术用途。

-

Transformer Lab:一个开源平台,无需编码即可在本地构建、微调和运行大型语言模型 (LLM)。下载数百个模型,跨硬件微调,聊天,评估等等。

-

MonsterGPT:聊天即刻微调与部署定制AI模型。让复杂的LLM与AI任务变得轻而易举。轻松访问60多款开源模型。

-

借助 MegaLLM 统一网关,加速上线 AI 功能。通过单一 API 即可接入 Claude、GPT-5、Gemini、Llama 等 70 多种模型,并内置分析工具、智能降级机制与使用追踪功能。

-

Nemotron-4 340B 是一个针对 NVIDIA NeMo 和 NVIDIA TensorRT-LLM 优化的模型系列,包含最先进的指令和奖励模型,以及一个用于生成式 AI 训练的数据集。