What is Qwen2-VL?

Qwen2-VLは、視覚世界の理解に明瞭さと深みをもたらすために設計された、最新世代のビジュアル言語モデルです。Qwen2を基盤として構築されたQwen2-VLは、画像とビデオの理解において大幅な進歩を遂げ、さまざまなアプリケーションにとって汎用性の高いツールとなっています。

主な機能:

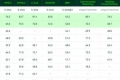

高度な画像解釈: Qwen2-VLは、さまざまな解像度とアスペクト比の画像を理解することに優れています。MathVista、DocVQA、RealWorldQA、MTVQAなどの視覚理解ベンチマークにおける卓越したパフォーマンスにより、同分野の最先端を走っています。

長尺ビデオの理解: Qwen2-VLは、20分を超えるビデオの理解にも対応できる機能を備えています。この機能により、ビデオベースの質問応答、対話、コンテンツ作成など、幅広いアプリケーションが可能になります。

ビジュアルインテリジェントエージェント: Qwen2-VLは、複雑な推論と意思決定能力により、スマートフォンやロボットに統合することができ、視覚的な手がかりとテキストによる指示に基づいて自動操作を実行できます。

多言語サポート: Qwen2-VLは、英語と中国語に加えて、ほとんどのヨーロッパ言語、日本語、韓国語、アラビア語、ベトナム語など、画像内の多言語テキストの解釈をサポートすることで、グローバルなユーザーに対応しています。

モデルのパフォーマンス: Qwen2-VLは、2Bから72Bまでのサイズで提供され、特に文書理解において、いくつかの主要なモデルを凌駕しています。72Bバージョンは、オープンソースのマルチモーダルモデルの新しいベンチマークを確立しています。

モデルの制限: Qwen2-VLは多くの長所を提供しますが、ビデオからの音声抽出、2023年6月までの知識カットオフ、複雑な指示やシーン、カウント、人物認識、3次元空間認識の処理における課題など、制限もいくつかあります。

モデルアーキテクチャ: Qwen2-VLのアーキテクチャには、動的解像度サポートやMultimodal Rotated Position Embedding (M-ROPE)などの革新的な機能が含まれており、マルチモーダルデータの処理と理解能力を強化しています。

アクセシビリティとライセンス: Qwen2-VL-2BとQwen2-VL-7Bは、Apache 2.0ライセンスの下でオープンソース化されており、Hugging Face TransformersやvLLMなどのプラットフォームへの統合により、開発者が利用できます。

結論として、Qwen2-VLは視覚理解を強化し、幅広いアプリケーションを提供する強力なツールです。高度な機能、卓越したパフォーマンス、オープンソースによる提供により、開発者と研究者にとって貴重なリソースとなっています。