What is Opik?

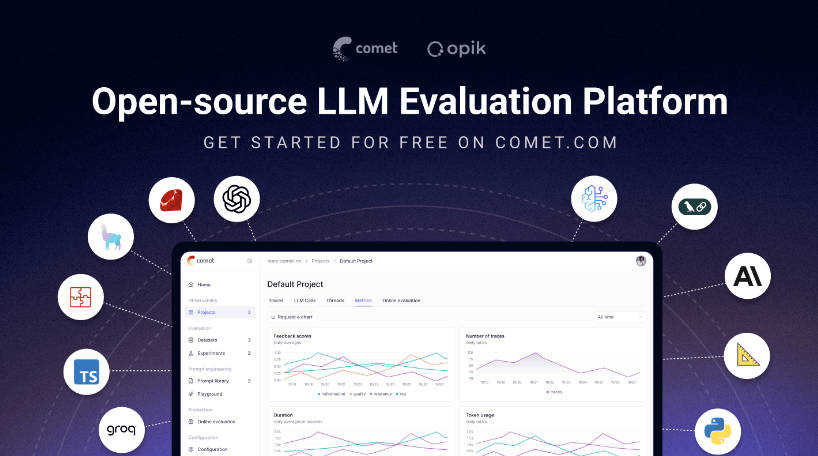

信頼性が高く、本番環境に対応したLLMアプリケーションの構築には、予測不能なモデルの挙動からシステム全体のパフォーマンス確保に至るまで、特有の課題が伴います。Opikは、RAGシステム、エージェントワークフロー、その他のLLMを活用したアプリケーションの構築、評価、監視に必要な明瞭性と制御を提供するために設計された、包括的なオープンソースプラットフォームです。プロトタイプから本番環境への移行を確信を持って進めるための不可欠なツールを提供します。

Key Features

Opikは、LLMアプリケーションのライフサイクル全体を管理するための、強力で統合されたツールキットを提供します。

🔍 Comprehensive Tracing and Observability アプリケーションロジックのあらゆるステップを完全に可視化します。Opikは、LLM呼び出し、エージェントのアクティビティ、ツール使用の詳細なトレースをキャプチャし、問題を迅速にデバッグするために必要な完全なコンテキストを提供します。LangChain、LlamaIndex、Autogen、OpenAIなどのフレームワーク向けに豊富なネイティブ統合ライブラリを備えているため、わずか数分で強力な可観測性をスタックに追加できます。

🧑⚖️ Automated LLM-as-a-Judge Evaluation 単純な合否テストを超えて、Opikは、強力なLLM-as-a-Judgeメトリクスを使用して、高度な評価を自動化することを可能にします。ハルシネーション、回答の関連性、コンテキストの精度といった複雑な品質を体系的に評価し、アプリケーションがユーザーに届く前に高い品質基準を満たすことを保証します。

📊 Production-Ready Monitoring and Dashboards 自信を持ってアプリケーションを大規模にデプロイ、管理できます。Opikは大量の本番ワークロード(1日あたり4000万以上のトレース)を処理できるように構築されており、パフォーマンスデータをリアルタイムでログ記録および分析できます。本番環境のダッシュボードを使用して、フィードバックスコア、トークン使用量、レイテンシを監視し、オンライン評価ルールを設定して問題発生時に捕捉できます。

⚙️ Integrated Optimization and Guardrails Opikは、問題の特定だけでなく、システムの積極的な改善も支援します。Opik Agent Optimizer を使用して、プロンプトとエージェントを体系的に強化し、パフォーマンスを向上させ、コストを削減します。Opik Guardrails を導入して、責任あるAIプラクティスを強制し、アプリケーションが安全かつ予測可能に動作することを保証します。

How Opik Solves Your Problems:

Pinpoint Failures in Your RAG System: RAGチャットボットが無関係な回答を提供した場合、その理由を知る必要があります。Opikの詳細なトレーシングは、最初のクエリと取得されたドキュメントから、最終的なプロンプトとLLMの生成に至るまで、シーケンス全体を検査することを可能にします。これにより、問題が情報検索、コンテキストの形成、またはモデル自体にあるかを即座に特定できます。

Automate Pre-Deployment Quality Checks: アプリケーションの新しいバージョンをプッシュする前に、デグレがないことを確認する必要があります。Opikの評価スイートをPyTest統合を介してCI/CDパイプラインと統合することで、ベンチマークデータセットをアプリケーションに対して自動的に実行し、LLM-as-a-judgeを使用してハルシネーションや有害性などの重要な要素を評価し、不適切なデプロイメントを防止できます。

Optimize Cost and Performance in Production: 稼働中のエージェントの運用コストが上昇していることに気づきます。Opikのダッシュボードを使用すると、トークン消費量とレイテンシを時間とともに追跡し、特定のトレースを掘り下げて非効率なプロンプトを見つけ、Opik Agent Optimizerを使用してそれらを改善することで、パフォーマンスを直接向上させ、運用費用を削減できます。

Why Choose Opik?

Open-Source and Deployment Flexibility: Opikは、データとインフラストラクチャを完全に制御できるようにします。DockerやKubernetesを使用してプラットフォームを自社システムでセルフホストし、最大限のプライバシーとカスタマイズを実現することも、管理されたComet.comクラウドサービスを利用して設定なしで即座に開始することも可能です。

A Unified, End-to-End Platform: Opikは単一目的のツールではなく、開発ライフサイクル全体を通してあなたをサポートする統一されたプラットフォームです。トレーシングによる初期デバッグから、評価による正式なテスト、そして本番環境での監視と最適化まで、Opikは単一の一貫したワークフローを提供します。

Conclusion:

Opikは、大規模言語モデルを使用した構築の複雑さを克服するために必要な専門ツールを提供します。深い可観測性、堅牢な評価、強力な最適化機能を提供することで、より信頼性が高く、効率的で、安全なLLMアプリケーションを作成することを可能にします。