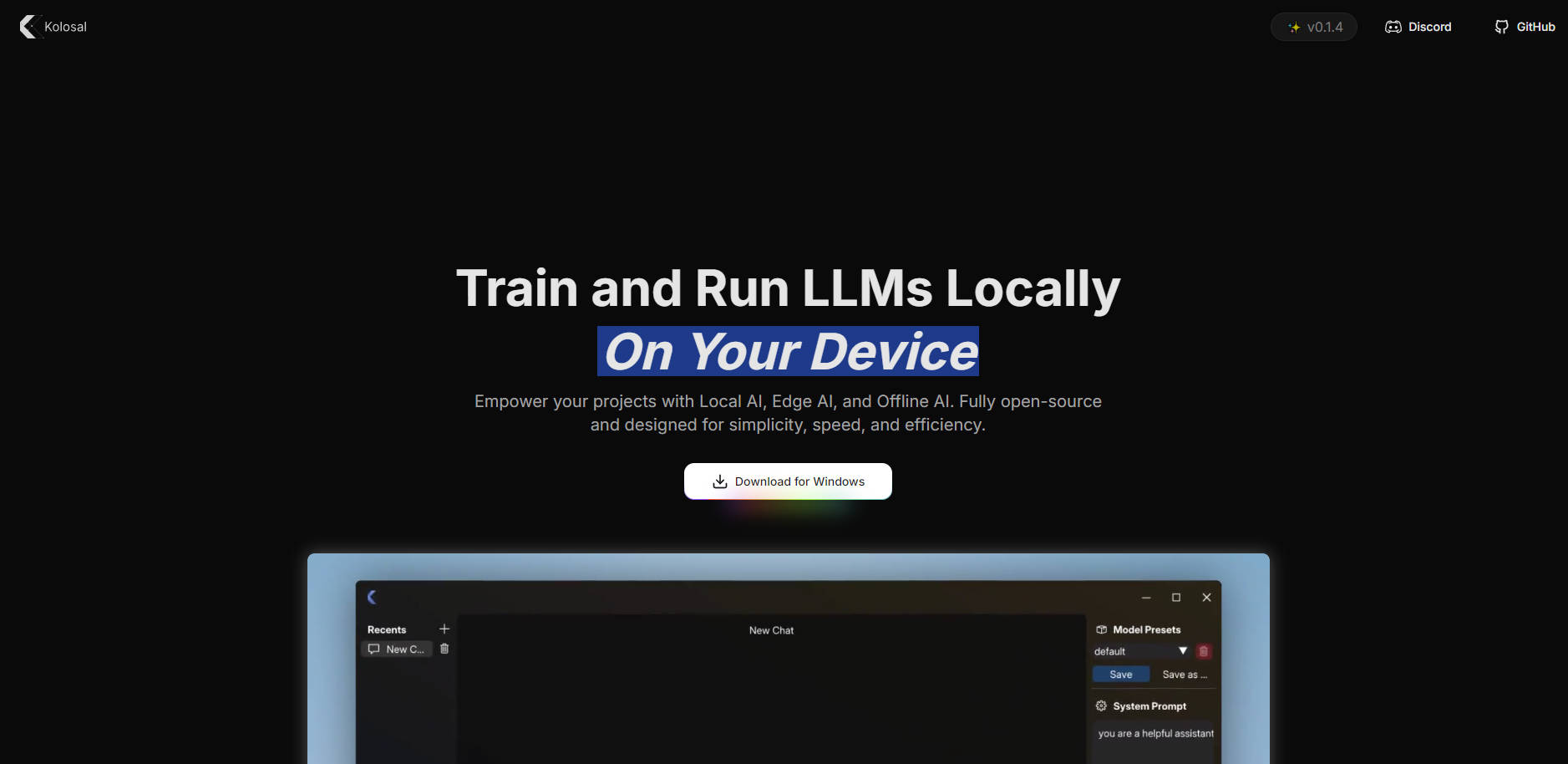

What is Kolosal AI?

ChatGPT나 Gemini처럼 컴퓨터 자원을 과도하게 소모하고 개인정보를 위협하는 거대 AI 시스템들, 알고 계시죠? 속도나 효율성을 희생하지 않고도 노트북, 데스크탑, 심지어 라즈베리 파이와 같은 기기에서 강력한 언어 모델을 직접 실행할 수 있다면 어떨까요? Kolosal AI를 만나보세요. 개방형 플랫폼인 Kolosal AI를 통해 대규모 언어 모델(LLM)을 로컬에서 학습하고 배포하여 데이터를 안전하게 보호하고 에너지 소비량을 줄일 수 있습니다. 무엇보다 놀라운 점은, 단 20MB의 용량으로 대용량 경쟁 제품들과 동등하거나 더 빠른 속도로 LLM을 실행한다는 것입니다.

주요 기능:

? 초경량

Kolosal AI는 단 20MB로 Ollama나 LMStudio 같은 플랫폼의 0.1~0.2%에 불과합니다. 이렇게 작은 패키지가 최고 수준의 성능을 제공한다는 사실에 놀라실 겁니다.

? 개인정보 보호

기기에서 직접 LLM을 실행하여 모든 데이터를 로컬에서 안전하게 유지합니다. 민감한 정보를 클라우드로 보낼 필요가 없습니다.

? 친환경

기기에서 AI 모델을 실행하여 클라우드 기반 AI 시스템에 비해 에너지 사용량을 크게 줄이고 친환경에 기여합니다.

⚙️ 폭넓은 호환성

AVX2 명령어를 지원하는 CPU 또는 AMD/NVIDIA GPU를 사용하든 Kolosal AI는 완벽하게 작동합니다. 라즈베리 파이와 같은 에지 기기에서도 사용 가능합니다.

?️ 맞춤형 학습

합성 데이터 생성 및 개인화된 가드레일을 사용하여 모델을 미세 조정하여 정확하고 맞춤화된 AI 애플리케이션을 더욱 쉽게 구축할 수 있습니다.

활용 사례:

1. 개별 개발자를 위한 로컬 AI 추론

클라우드 서비스에 의존하지 않고 개인 노트북에서 LLM을 실행하고 싶은 개발자라면 Kolosal AI가 빠르고 효율적인 온디바이스 추론을 제공합니다. 부수적인 프로젝트를 위한 모델 조정이나 새로운 아이디어 테스트 등 모든 작업을 오프라인으로 수행하여 데이터를 안전하게 보호할 수 있습니다.

2. IoT 기기의 에지 배포

지연 시간을 최소화하고 사용자 개인정보를 보호하기 위해 로컬에서 언어를 처리해야 하는 스마트 홈 기기를 개발하는 팀의 일원이라면, Kolosal AI를 통해 라즈베리 파이와 같은 저전력 하드웨어에서도 원활한 성능을 보장하는 경량 언어 모델을 에지 기기에 배포할 수 있습니다.

3. 기업을 위한 맞춤형 모델 학습

독점 데이터를 사용하여 대규모 언어 모델을 학습해야 하는 기업이라면, Kolosal AI를 통해 비용이 많이 드는 클라우드 기반 솔루션에 의존하지 않고 로컬에서 모델을 학습하고 미세 조정하여 비용을 절감하고 데이터 보안을 향상시킬 수 있습니다. 또한, 멀티 GPU 지원을 통해 대규모 데이터 세트도 처리할 수 있도록 학습을 확장할 수 있습니다.

결론:

막대한 에너지를 소비하고 개인정보를 위협하는 클라우드 기반 솔루션이 AI 시장을 지배하는 현실에서 Kolosal AI는 신선한 대안을 제시합니다. 고성능 GPU 워크스테이션이든 저전력 라즈베리 파이든, 빠르고 가볍게 사용자 기기에서 실행되도록 설계되었습니다. 개방형 소스의 유연성, 폭넓은 호환성 및 개인정보 보호 중심 접근 방식을 통해 Kolosal AI는 개별 개발자와 대기업 모두에게 기존의 절충 없이 AI의 힘을 활용할 수 있도록 지원합니다. 지금 바로 Kolosal AI를 다운로드하여 로컬에서 미래를 만들어 보세요.

FAQ:

Q: Kolosal AI는 정말 무료로 사용할 수 있나요?

A: 네! Kolosal AI는 Apache 2.0 라이선스에 따라 개방형 소스로 제공되므로 자유롭게 사용, 수정 및 배포할 수 있습니다.

Q: 오래된 노트북에서도 Kolosal AI를 실행할 수 있나요?

A: 물론입니다. Kolosal AI는 경량으로 설계되어 오래된 노트북과 라즈베리 파이와 같은 저전력 기기를 포함한 다양한 기기에서 효율적으로 실행될 수 있습니다.

Q: Kolosal AI는 어떻게 개인정보를 보호하나요?

A: 모든 데이터 처리가 사용자 기기에서 로컬로 수행되므로 데이터가 외부 서버로 전송되지 않습니다. 이를 통해 개인정보가 안전하게 보호됩니다.