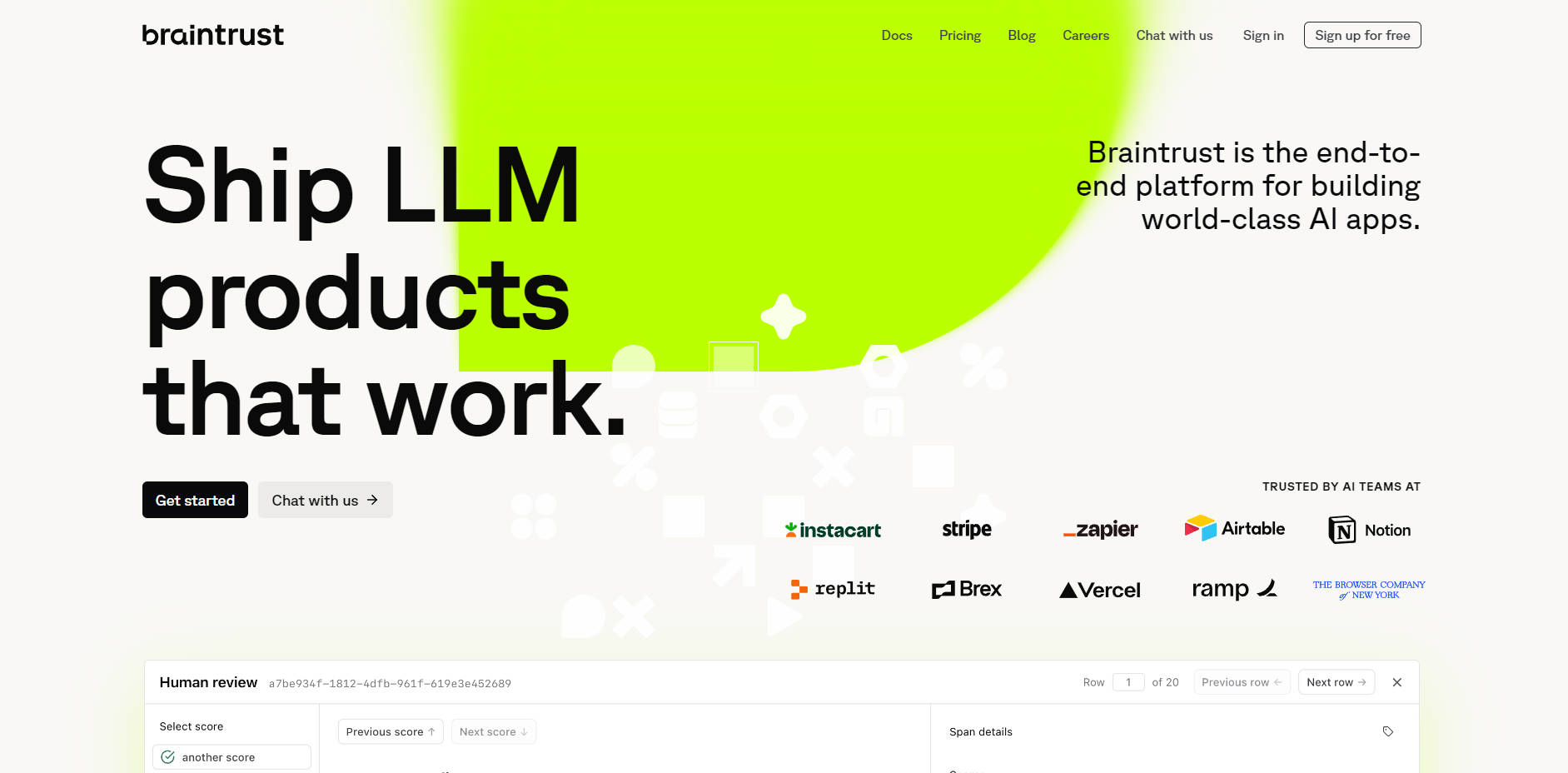

What is Braintrust?

大型语言模型(LLM)应用的开发面临着诸多独有挑战,例如输出结果难以预测、缺乏系统化测试等。Braintrust 正是专为AI团队打造的端到端评估平台,旨在助您攻克这些复杂难题。我们提供开发、测试和监控LLM驱动产品所需的全套工具,助您以严谨的工程化方法,确保交付的应用在真实世界中稳定可靠地运行。

主要功能

Braintrust 提供一套集成的工具套件,旨在为您的AI开发生命周期带来清晰的洞察和全面的掌控。

📊 全面的模型与提示词评估 告别盲测,拥抱量化。您可以基于自身数据集,系统性地比较不同提示词和模型(支持OpenAI、Anthropic、Google等提供商)。通过使用行业标准或自定义评分器,生成关于质量、成本和延迟的客观量化指标,从而帮助您做出数据驱动的决策。

🧪 交互式开发演练场 在强大的协作式工作空间中加速您的迭代周期。该演练场支持您快速原型化并并行测试不同的提示词、模型和数据组合。这有助于您快速构建假设并找到有效方案,且无需进行复杂耗时的设置。

🗂️ 集中式与版本化数据集 为所有评估数据建立单一可信来源。您可以在一个安全、可扩展的位置集中捕获、管理和版本化您的“黄金”测试用例和已评分的生产示例。这确保您的团队每次都能执行一致且可重现的评估。

📈 生产日志与监控 深入洞察您的应用在部署后的实际表现。Braintrust 支持您记录和分析真实世界的用户交互,提供可操作的洞察,帮助您调试问题、识别新的边缘案例,并基于实际用户行为持续提升产品质量。

Braintrust 如何解决您的问题:

Braintrust 旨在解决AI构建过程中遇到的日常实际挑战。您可以通过以下方式运用它:

改进表现不佳的AI功能: 当用户报告AI驱动功能出现问题时,您可以使用 Braintrust 记录这些问题交互。将这些示例整理成新的评估数据集,然后在 Playground 中尝试改进的提示词或不同的模型。最后,进行全面评估,将新版本与旧版本进行比较,确保在发布之前,您的修复带来了可衡量的改进。

为新任务比较LLM提供商: 选择合适的模型对性能和成本至关重要。借助 Braintrust,您可以设置一个实验,使用相同的提示词和数据集对来自多个提供商的模型进行测试。评估结果将清晰地并列展示模型的准确性、速度和成本,使您能够针对特定用例做出明智的、基于证据的决策。

确保CI/CD管道中的质量: 使用SDK将 Braintrust 评估直接集成到您的开发工作流中。就像您为传统软件运行单元测试一样,每次代码更改时,您都可以自动运行AI评估。这有助于您及早发现回归,并确保每次更新都能保持或提升AI应用的质量。

独特优势

真正的端到端工作流: Braintrust 的强大之处在于其工具的无缝集成。该平台建立了一个持续的反馈循环,让您能够从记录生产问题、创建测试用例,到在演练场中迭代,并最终自信地部署经过验证的改进。

专为现代工程技术栈打造: 我们深知AI开发是一项需要团队协作、并融入现有流程的工作。凭借强大的SDK(支持TypeScript/Python)、稳健的API以及实现最大化数据控制的自托管选项,Braintrust 旨在增强您的工程技术栈,而非对其造成干扰。

总结:

Braintrust 用结构化、迭代式且数据驱动的流程,取代了AI开发中的盲目猜测。它赋能您的整个团队——从开发者到产品经理——高效协作,自信地交付更高质量的AI产品。

探索 Braintrust 如何为您的AI开发生命周期带来可靠性和精确性!