What is Hatchet.run?

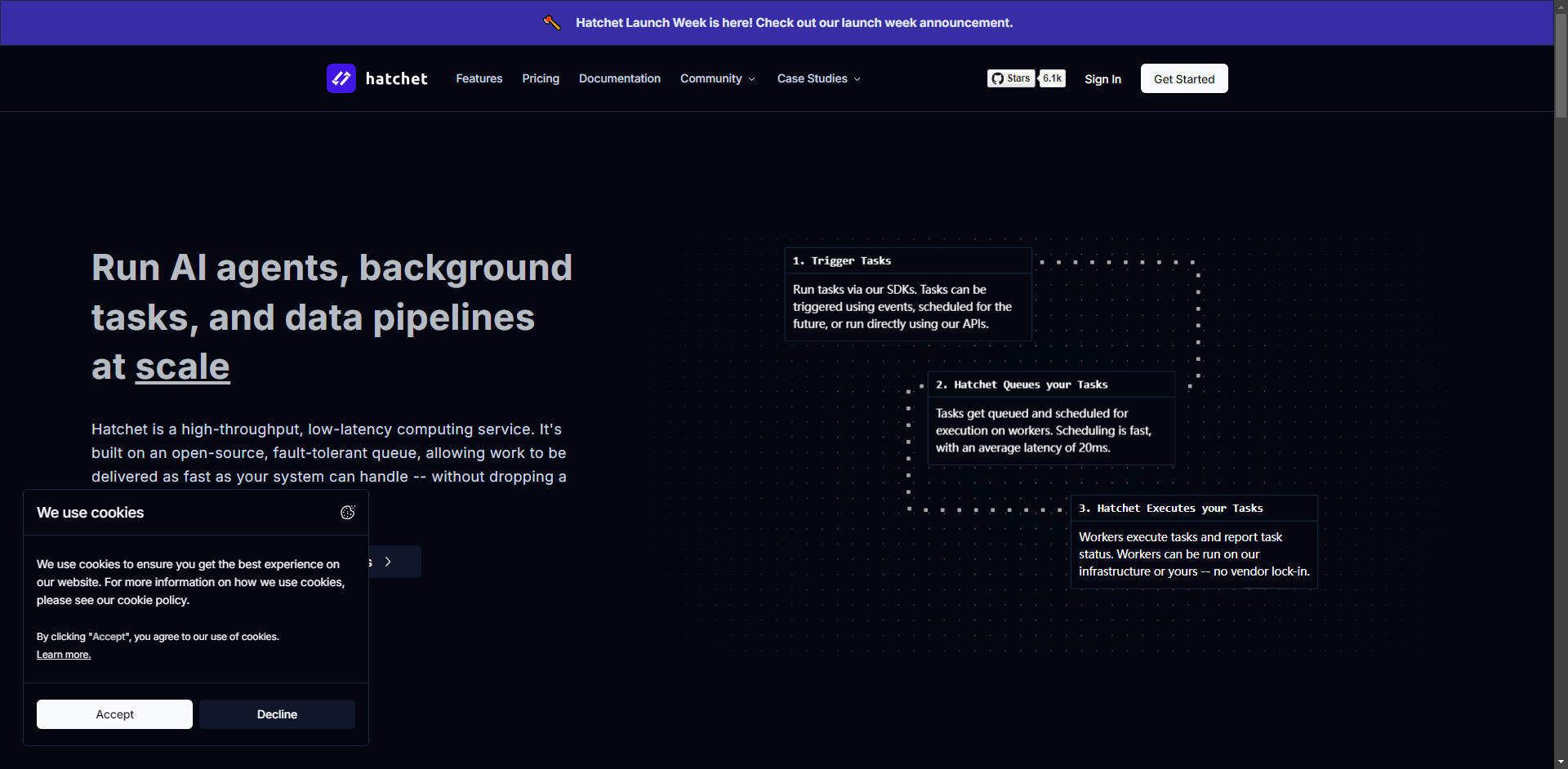

Hatchet 是一个高吞吐量、低延迟的编排平台,旨在简化构建弹性分布式网络应用和智能体AI流水线的复杂性。Hatchet 作为一个持久化执行层,取代了管理复杂自建任务队列或脆弱发布/订阅系统来扩展应用的需要。工程团队利用 Hatchet 轻松分发函数、管理流量控制并确保任务可靠完成,从而能够纯粹专注于业务逻辑,而非基础设施的持久性。

主要特性

Hatchet 提供必要的控制和持久性,以在大规模下可靠运行后台任务和数据流水线。

1. 持久化且容错的执行

Hatchet 确保工作能够完成,即使您的应用程序在任务执行过程中崩溃。每次任务调用都会持久化记录到 PostgreSQL,使系统能够跟踪进度,并在中断处精确自动恢复工作流。这种持久化执行模型杜绝了工作丢失,防止了重复调用(这对 LLM 交互至关重要),并确保即使在系统故障期间,用户请求也不会丢失。

2. ⚡️ 高吞吐量、低延迟任务调度

Hatchet Engine 针对速度进行了优化,为处理数千个并发任务的“热”工作节点提供低于 25 毫秒的任务调度延迟。它利用智能分配规则,无需复杂的 manual 配置即可自动管理并发性、公平性和优先级,确保您的工作节点以其可处理的速度接收任务。

3. ⚙️ 代码优先的工作流编排

将复杂逻辑定义为易于版本化和测试的代码。您可以将简单的函数(称为任务)组合成复杂的父子关系或有向无环图 (DAGs)。这使开发人员能够将大型复杂操作分解为更小、可重用的步骤,从而简化开发,并使跨 Python、Typescript 和 Go 环境的部署更加便捷。

4. 📊 内置可观测性与告警

Hatchet 内置实时监控工具,可提供分布式系统的即时可见性。您将获得实时仪表盘、指标和全面的日志记录,这些日志能够将任务失败与系统日志直接关联起来。可定制的 Slack 和电子邮件告警确保在任务或工作流失败时立即通知您,最大限度地缩短检测和响应时间。

应用场景

Hatchet 在需要高可靠性、复杂调度和海量吞吐量的场景中表现出色。

1. 实时数据摄取与 ETL 流水线 对于需要最新上下文的应用程序,例如为大型语言模型(LLMs)提供数据的向量数据库,Hatchet 提供快速、可靠的 ETL(提取、转换、加载)功能。您可以定义能够以高吞吐量摄取、处理和更新数据源的工作流,并利用 Hatchet 的流量控制来管理并发性,防止在大数据高峰期间出现瓶颈。

2. 扩展智能体AI系统 Hatchet 专门设计用于支持现代AI智能体的复杂性。事件驱动触发、子工作流生成和动态路由等功能使您能够构建多步骤、复杂的智能体,这些智能体能够可靠地响应外部事件、管理长时间运行的对话,并在多个外部服务之间进行协调。

3. 平滑应用负载峰值 如果您的应用程序遇到不可预测的流量激增(例如限时抢购、突然的病毒式增长),Hatchet 的持久化队列机制能够即时接收所有传入请求。然后,它会平滑执行曲线,确保任务以受控、可持续的速度分发给您的工作节点,从而防止工作节点过载,并保证关键用户请求得到处理而不会丢失。

总结

Hatchet 助力工程团队部署弹性、可扩展的分布式应用,同时不牺牲速度或可靠性。通过提供一个统一的平台用于任务编排、流量控制和容错,它显著降低了运营开销和开发复杂性。

准备好构建持久化、可扩展的工作流了吗?立即查阅完整的文档或快速开始使用 Hatchet Cloud。