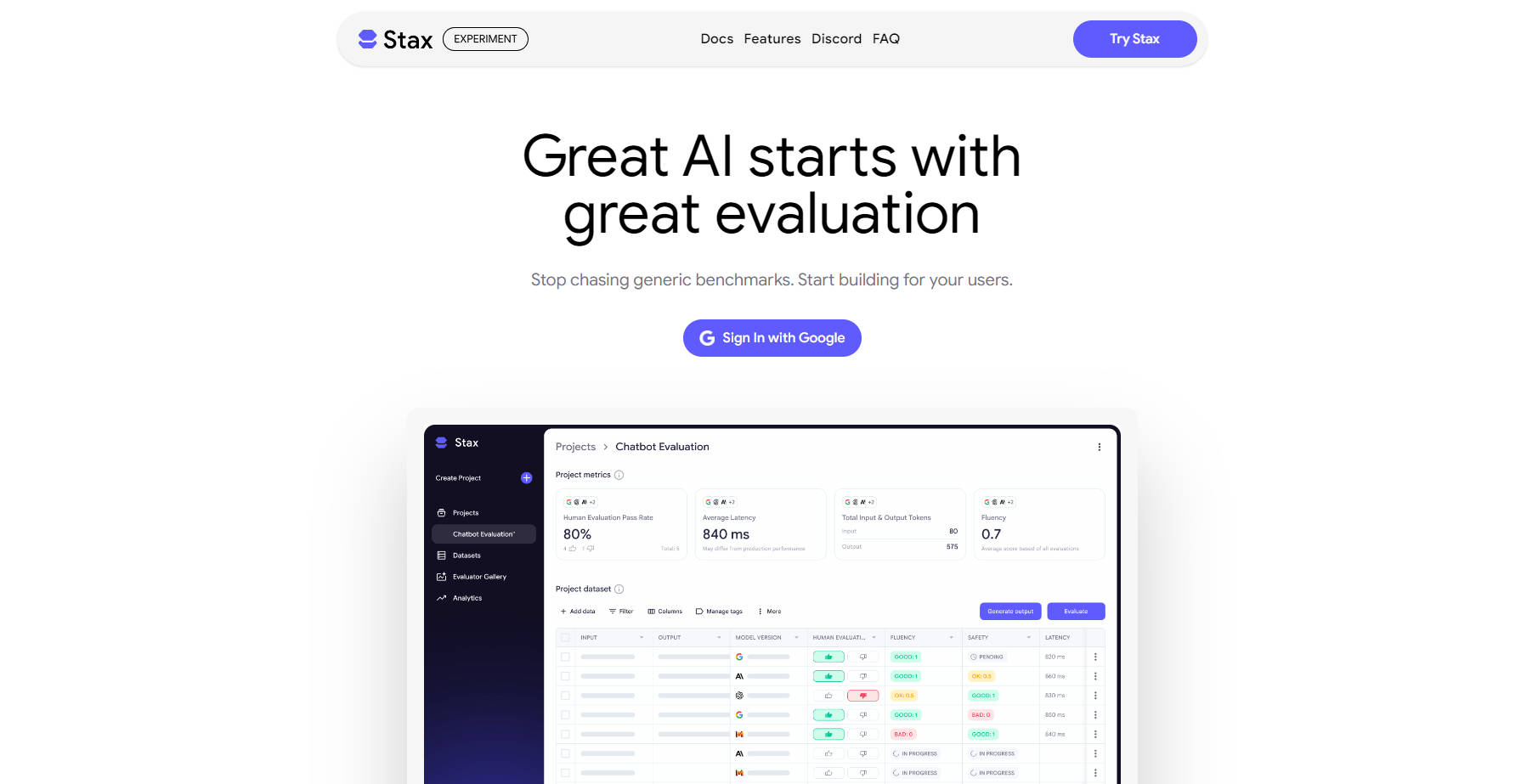

What is Stax?

Stax 是一個 AI 評估平台,旨在協助開發者和產品團隊,快速且自信地推出其基於大型語言模型(LLM)的應用程式。它解決了準確評估 AI 效能的關鍵挑戰,透過讓您根據自身獨特的標準來測試模型和提示,確保您的應用程式真正滿足使用者需求。

主要功能

📊 管理與建構測試資料集: 輕鬆匯入您現有的正式環境資料集,或利用 Stax 透過提示任何主流 LLM 來建構新的資料集。這確保您的評估始終與您的特定使用情境相關。

⚙️ 運用預建與自訂評估器: 超越通用基準測試的範疇。使用一套預設評估器來衡量指令遵循和冗贅度等標準指標,或建立自訂評估器以測試品牌語氣或特定業務邏輯等細緻的品質。

📈 做出數據驅動的決策: 獲取關於品質、延遲和權杖計數的實用數據。Stax 提供您所需的洞察,以自信地識別出最適合您應用的 AI 模型、提示或迭代版本,從「憑感覺判斷」轉變為可驗證的結果。

🚀 快速評估,加速發佈: 以強大、可重複的評估取代耗時、手動的一次性測試。這有助於快速創新和自信部署,讓您能夠迅速迭代和發佈。

應用情境

最佳化聊天機器人回應: 產品團隊可以使用 Stax 測試用於客戶支援聊天機器人的各種 LLM 模型和提示。他們可以建立自訂評估器,以確保回應符合品牌形象、準確且實用,從而提高客戶滿意度。

精進內容生成: 開發 AI 內容生成工具的行銷團隊,可以根據語氣、風格和事實準確性等特定標準評估不同的 LLM 輸出。Stax 幫助他們快速識別出最佳的模型和提示組合,能夠持續生成高品質、符合品牌形象的內容。

為新功能進行 LLM 效能基準測試: 在推出由 LLM 驅動的新功能之前,開發者可以使用 Stax 比較多個模型和提示工程方法。他們可以分析延遲和輸出品質等關鍵指標的效能,確保該功能在正式環境中可靠且高效地運行。

為何選擇 Stax?

Stax 的獨特之處在於,它將重點從通用的排行榜轉向您的特定需求。雖然通用基準測試提供廣泛的概覽,但 Stax 讓您能夠真正了解 LLM 或提示如何為 您的獨特使用情境 發揮效能。

客製化評估: 不同於專注於廣泛指標的平台,Stax 讓您能夠定義和衡量對您的產品和使用者真正重要的事物,而不只是標準基準測試。這意味著您的評估將直接影響您產品的成功。

可操作的洞察: Stax 提供關於品質、延遲和權杖計數等關鍵效能指標的紮實數據,使您能夠做出明智的決策。您將清楚了解哪些方案有效,從而自信地開發並推出突破性產品。

端到端工作流程: 從模型的初步實驗、提示和編排的快速比較,到利用託管資料集和自訂評估器進行規模化評估,Stax 提供了一套完整且可重複的工作流程。您可以視覺化追蹤彙總的 AI 效能,監控改進情況,並自信地為產品發佈做準備。

結論

Stax 提供了一整套 AI 評估工具,為您帶來有效開發和部署 LLM 驅動應用程式所需的清晰度、速度和信心。停止追逐通用基準測試,開始透過數據驅動的洞察為您的使用者建構創新產品吧。