Las mejores XLNet alternativas en 2025

-

LanguageX: El Agente de Traducción de IA. Orqueste IA personalizada, edición en tiempo real y selección inteligente de motores para traducciones profesionales de alta calidad.

-

Crea y despliega sin esfuerzo IA conversacional (chat, voz, multimodal) con la plataforma sin código de NLX. Integra tus sistemas fácilmente.

-

Simplifica el trabajo con los grandes lenguajes de modelado utilizando Xytext. Clasificar tickets de soporte, convertir textos no estruturados y generar contenidos de marketing.

-

¡Revolucione el desarrollo de LLM con LLM-X! Integre sin problemas grandes modelos de lenguaje en su flujo de trabajo con una API segura. Aumente la productividad y desbloquee el poder de los modelos de lenguaje para sus proyectos.

-

Plataforma totalmente administrada para que los equipos capaciten, implementen y escalen LLMs en producción sin ningún esfuerzo adicional de ingeniería.

-

ConsoleX es un entorno unificado para LLM que integra interfaces de chat de IA, un entorno de juego de API de LLM y evaluación por lotes, compatible con todos los LLM principales y la función de depuración de llamadas, así como muchas funciones mejoradas en comparación con los entornos oficiales.

-

Investigación en curso para entrenar modelos Transformer a escala

-

NLUX simplifica la conexión de grandes modelos de lenguaje con tu aplicación web, lo que te permite crear interfaces interactivas impulsadas por IA sin esfuerzo.

-

Una familia de modelos de lenguaje pionera para aplicaciones de IA avanzadas. Explore modelos de código abierto eficientes con escalado capa por capa para mayor precisión.

-

Descubre el potencial de los grandes modelos lingüísticos con 04-x. Con privacidad mejorada, integración fluida y una interfaz fácil de usar para el aprendizaje de idiomas, la escritura creativa y la resolución de problemas técnicos.

-

Para acelerar la inferencia de los LLM y mejorar la percepción de los LLM de información clave, comprime el indicador y KV-Cache, que logra una compresión de hasta 20 veces con una pérdida de rendimiento mínima.

-

Descubre EXAONE 3.5 de LG AI Research. Un conjunto de modelos generativos ajustados por instrucciones bilingües (inglés y coreano) con parámetros que van de 2.4 mil millones a 32 mil millones. Admite contextos largos de hasta 32 mil tokens, con un rendimiento de primer nivel en escenarios del mundo real.

-

Descubre StableLM, un modelo de lenguaje de código abierto de Stability AI. Genera texto y código de alto rendimiento en dispositivos personales con modelos pequeños y eficientes. Tecnología de IA transparente, accesible y de apoyo para desarrolladores e investigadores.

-

FutureX: Evalúe dinámicamente la capacidad predictiva de los agentes LLM para eventos futuros en el mundo real. Obtenga perspectivas sin adulterar sobre la auténtica inteligencia artificial.

-

GPT-NeoX-20B es un modelo de lenguaje autoregresivo de 20 mil millones de parámetros entrenado en el Conjunto de Datos utilizando la biblioteca GPT-NeoX.

-

Transformer Lab: Una plataforma de código abierto para construir, ajustar y ejecutar LLMs localmente sin necesidad de programar. Descarga cientos de modelos, ajusta finamente en diferentes hardwares, chatea, evalúa y mucho más.

-

WizardLM-2 8x22B es el modelo Wizard más avanzado de Microsoft AI. Demuestra un rendimiento altamente competitivo en comparación con los principales modelos propietarios y supera constantemente a todos los modelos de código abierto de última generación existentes.

-

Descubre el poder de Lepton Search, una plataforma de PNL de código abierto con conversaciones de turnos múltiples, respuesta a preguntas y generación de texto. Revoluciona tus aplicaciones con una comprensión del lenguaje eficiente y versátil.

-

Un motor de inferencia y servicio de alto rendimiento y bajo consumo de memoria para LLM

-

Mejora los modelos de lenguaje, mejora el rendimiento y obtiene resultados precisos. WizardLM es la herramienta definitiva para tareas de codificación, matemáticas y PNL.

-

LangExtract: biblioteca de Python para la extracción verificable de datos de LLM. Convierte texto no estructurado en datos estructurados, precisos y con fundamento en el origen, en los que puedes confiar.

-

Descubra XAgent, un agente autónomo de código abierto que resuelve tareas de manera autónoma, segura y colaborativa. Desde el análisis de datos hasta el entrenamiento de modelos, XAgent es versátil y eficaz.

-

¡Explora InternLM2, una herramienta de IA con modelos abiertos! Destaca en tareas de contexto extenso, razonamiento, matemáticas, interpretación de código y redacción creativa. Descubre sus aplicaciones versátiles y sus sólidas capacidades de utilización de herramientas para la investigación, el desarrollo de aplicaciones y las interacciones de chat. Mejora tu panorama de IA con InternLM2.

-

AgentX: Crea e implementa con facilidad agentes y equipos de IA especializados. Automatiza tareas, potencia la eficiencia y optimiza el servicio al cliente para tu negocio. Sin necesidad de código.

-

XX.AI es un asistente de escritura de IA para tu escritorio. Te ayuda a escribir, comunicarte y ser más productivo. Impulsado por GPT-4, Claude 3 y DALL-E 3, XX.AI es mejor que los servicios basados en la web. Te ayuda con la escritura y mucho más.

-

Nexal AI es una plataforma integral que combina múltiples modelos de IA, incluyendo ChatGPT, Claude, Gemini, Leonardo, Dall-E, Meta AI, Mistral, y más. Ofrece una interfaz unificada para un acceso fácil y flexible a estas poderosas herramientas.

-

Conecta tu sitio web a la Web de IA con NLWeb. Herramientas y protocolos de código abierto que utilizan Schema.org permiten el acceso en lenguaje natural para agentes de IA y usuarios.

-

Los modelos de lenguaje de la serie Qwen2.5 ofrecen capacidades mejoradas con conjuntos de datos más grandes, más conocimiento, mejores habilidades de codificación y matemáticas, y una alineación más cercana a las preferencias humanas. De código abierto y disponible a través de API.

-

KTransformers, un proyecto de código abierto del equipo KVCache.AI de Tsinghua y QuJing Tech, optimiza la inferencia de modelos de lenguaje grandes. Reduce los umbrales de hardware, ejecuta modelos de 671B parámetros en GPUs individuales de 24GB de VRAM, aumenta la velocidad de inferencia (hasta 286 tokens/s en pre-procesamiento, 14 tokens/s en generación) y es adecuado para uso personal, empresarial y académico.

-

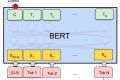

Código de TensorFlow y modelos preentrenados para BERT