What is Chonkie?

La construcción de sistemas de Generación Aumentada por Recuperación (RAG, por sus siglas en inglés) eficaces a menudo depende de la calidad de la preparación de los datos fuente. Un paso fundamental, aunque frecuentemente desafiante, es dividir los documentos en fragmentos significativos y listos para la IA, un proceso conocido como "chunking". Los desarrolladores se enfrentan repetidamente a la necesidad de soluciones de "chunking" robustas pero sencillas, y a menudo encuentran que las bibliotecas existentes son demasiado complejas y voluminosas, o carecen de características esenciales.

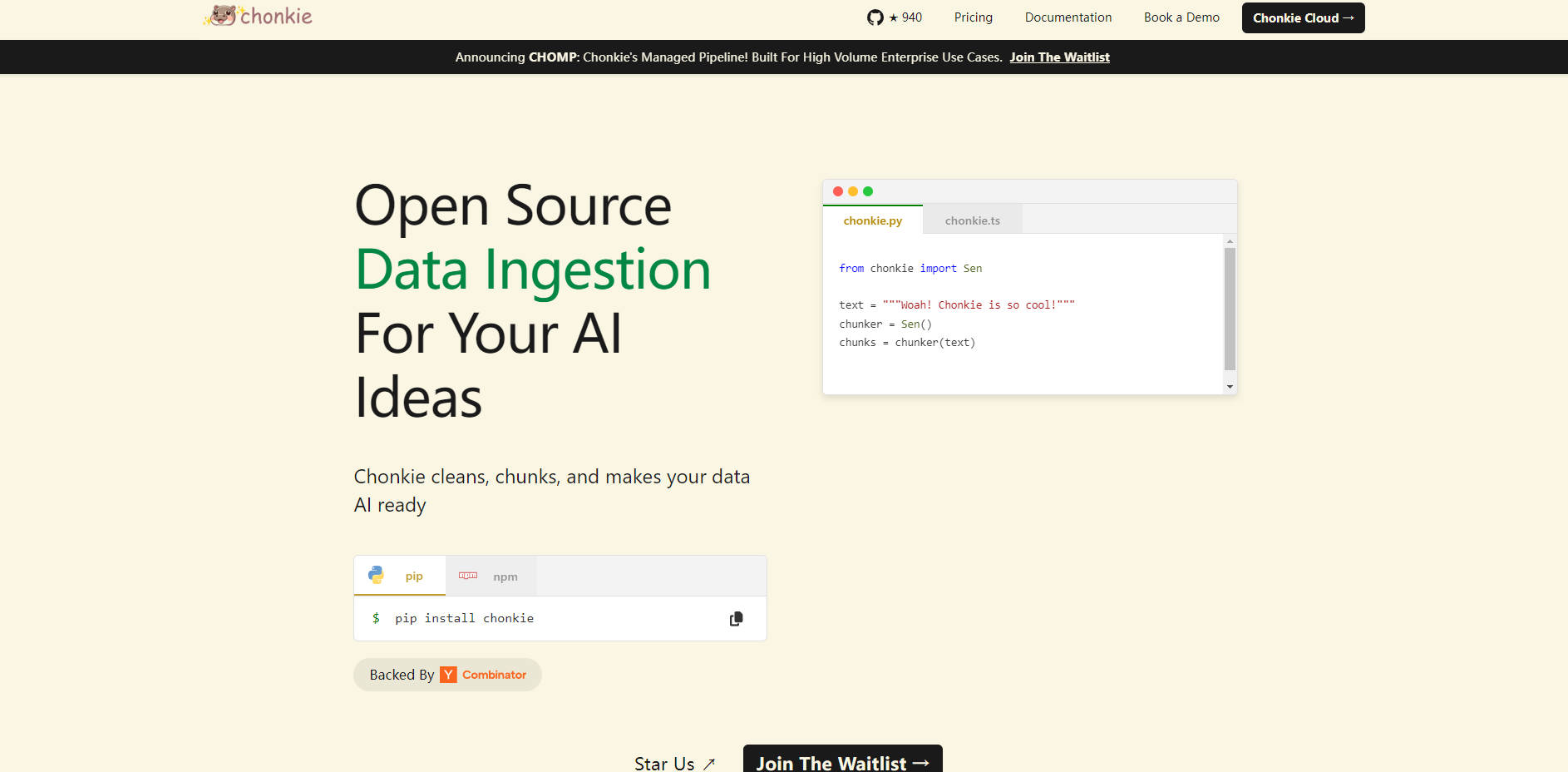

Chonkie aborda este desafío directamente. Está diseñada como una biblioteca enfocada y de alto rendimiento que proporciona las herramientas esenciales para transformar datos de texto sin procesar en fragmentos optimizados para las aplicaciones RAG, manteniendo la simplicidad y la eficiencia.

Capacidades Clave

Integración Sencilla ✨: Comienza rápidamente con un simple

pip instally una API intuitiva. Integra el "chunking" en tu pipeline con una configuración mínima, lo que te permite concentrarte en otros aspectos de tu sistema RAG.Velocidad Excepcional ⚡: Procesa tus datos de texto a velocidades impresionantes. Los benchmarks muestran que Chonkie realiza tareas comunes de "chunking" significativamente más rápido que las alternativas: hasta 33 veces más rápido para el "chunking" de tokens y 2.5 veces más rápido para el "chunking" semántico.

Notablemente Ligera 🪶: Evita dependencias y sobrecargas innecesarias. Chonkie cuenta con un tamaño de instalación mínimo, manteniendo las dependencias de tu proyecto ligeras. Incluso con características avanzadas como el "chunking" semántico, sigue siendo sustancialmente más ligera que las bibliotecas de la competencia.

Estrategias de "Chunking" Integrales 🧠: Accede a una variedad de métodos de "chunking", incluyendo los basados en tokens, basados en oraciones, recursivos, semánticos, específicos de código, e incluso métodos que aprovechan modelos neuronales o LLM, lo que garantiza que tengas la herramienta adecuada para diferentes tipos de texto y objetivos de recuperación.

Amplio Soporte del Ecosistema 🌍: Conéctate sin problemas con tu stack de IA existente. Chonkie se integra con numerosos tokenizadores (más de 5), proveedores de embeddings (más de 6), proveedores de LLM (más de 2) y bases de datos vectoriales (más de 3 como Chroma, Qdrant, Turbopuffer), ofreciendo flexibilidad en tus opciones de herramientas.

Procesamiento de Datos Estructurados (Pipeline CHOMP) 📄👨🍳🦛🏭🤝: Utiliza un enfoque de pipeline modular (CHOMP) que guía tus datos desde documentos sin procesar a través de la limpieza (Chef), el "chunking" (Chunker), el enriquecimiento (Refinery) y la salida final (Porters para la exportación, Handshakes para la ingesta de la base de datos vectorial). Esta estructura promueve la claridad y la personalización.

Lista para Múltiples Idiomas 🌐: Maneja texto en varios idiomas de forma inmediata con soporte para más de 5 idiomas, ampliando la aplicabilidad de tus sistemas RAG a nivel mundial.

Casos de Uso

Mejora de la Precisión del Chatbot de IA: Al aplicar estrategias avanzadas de "chunking" como

RecursiveChunkeroSemanticChunker, los desarrolladores pueden asegurarse de que los fragmentos de texto recuperados proporcionados a un LLM para responder a una consulta sean más relevantes y contextualmente completos. Esto conduce a respuestas más precisas y reduce significativamente los casos de alucinación.Aceleración de los Pipelines de Ingesta de Datos: Para las aplicaciones que manejan grandes volúmenes de datos de texto, la velocidad del proceso de "chunking" es fundamental. El uso de los métodos de "chunking" rápidos de Chonkie permite a los desarrolladores procesar y preparar los datos para las bases de datos vectoriales mucho más rápido, lo que conduce a actualizaciones más rápidas y a menores costos de cómputo para sus sistemas RAG.

Manejo de Diversos Tipos de Documentos: Al construir RAG sobre un conjunto de datos heterogéneo que incluye documentos, código y texto estructurado, los desarrolladores pueden utilizar los "chunkers" especializados de Chonkie, como el

CodeChunker, dentro del flexible pipeline CHOMP. Esto asegura que cada tipo de dato sea procesado óptimamente antes de ser indexado, mejorando el rendimiento de la recuperación en toda la base de conocimiento.

Conclusión

Chonkie proporciona una solución enfocada, de alto rendimiento y fácil de integrar para la tarea esencial del "chunking" de texto en los pipelines RAG. Su velocidad, su huella mínima, sus diversos métodos de "chunking" y su amplio soporte de integración la convierten en una herramienta valiosa para los desarrolladores que buscan construir aplicaciones de IA más eficientes, precisas y mantenibles. Al simplificar y acelerar la etapa de preparación de datos, Chonkie te ayuda a construir un mejor contexto para tus modelos y a lograr resultados de IA superiores.