What is GGML?

ggml.ai: IA en el borde, una biblioteca de tensores de vanguardia diseñada para el aprendizaje automático, que permite modelos grandes y alto rendimiento en hardware cotidiano. Con características como compatibilidad con coma flotante de 16 bits, cuantificación de enteros, diferenciación automática y optimización para Apple Silicon, ggml revoluciona la inferencia en dispositivos con una asignación de memoria mínima y una salida de lenguaje guiada.

Características principales:

-

? Biblioteca de tensores para aprendizaje automático: Escrita en C, ggml admite modelos grandes en hardware básico, lo que permite una integración perfecta en diversos proyectos.

-

?️ Rendimiento optimizado: Con soporte de coma flotante de 16 bits y cuantificación de enteros, ggml garantiza un cálculo eficiente, aprovechando algoritmos de optimización integrados como ADAM y L-BFGS.

-

? Compatibilidad versátil: Desde la optimización de Apple Silicon hasta la compatibilidad con WebAssembly, ggml se adapta a varias arquitecturas sin dependencias de terceros, lo que garantiza una integración fluida en cualquier entorno.

-

? Alta eficiencia: Las asignaciones de memoria cero durante el tiempo de ejecución y la compatibilidad con la salida de lenguaje guiada agilizan el desarrollo, lo que mejora la productividad y el rendimiento.

Casos de uso:

-

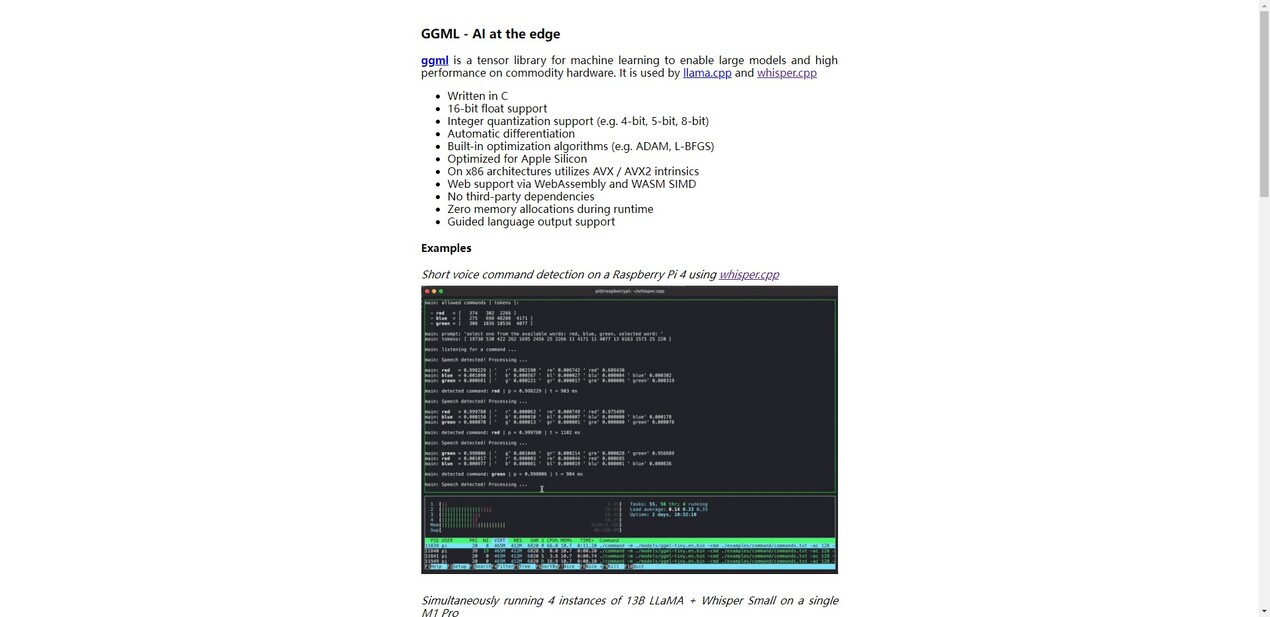

Detección de comandos de voz basados en el borde: Utilice ggml para la detección de comandos de voz cortos en dispositivos como Raspberry Pi 4, lo que garantiza respuestas rápidas y precisas.

-

Inferencia de múltiples instancias: Ejecute múltiples instancias de modelos de lenguaje grandes como LLaMA en Apple M1 Pro, maximizando la eficiencia computacional para diversas aplicaciones.

-

Procesamiento del lenguaje en tiempo real: Logre una generación rápida de tokens con modelos de lenguaje grandes en hardware de vanguardia como M2 Max, lo que mejora las capacidades de procesamiento del lenguaje natural para diversas tareas.

Conclusión:

ggml.ai ofrece una solución transformadora para la inferencia en dispositivos, lo que permite a los desarrolladores aprovechar todo el potencial del aprendizaje automático en hardware cotidiano. Únase a nosotros para simplificar el desarrollo de IA, explorar nuevas posibilidades y ampliar los límites de la innovación. Experimente la eficiencia y flexibilidad de ggml.ai hoy mismo y desbloquee el futuro de la inferencia en dispositivos.