What is GGML?

ggml.ai - L'IA en périphérie, une bibliothèque de tenseurs de pointe conçue pour l'apprentissage automatique, permettant des modèles volumineux et des performances élevées sur du matériel courant. Avec des fonctionnalités telles que la prise en charge des flottants 16 bits, la quantification d'entiers, la différenciation automatique et l'optimisation pour Apple Silicon, ggml révolutionne l'inférence sur les appareils avec une allocation de mémoire minimale et une sortie linguistique guidée.

Fonctionnalités principales :

? Bibliothèque de tenseurs pour l'apprentissage automatique : Écrite en C, ggml prend en charge les modèles volumineux sur des matériels courants, permettant une intégration transparente dans divers projets.

?️ Performances optimisées : Avec la prise en charge des flottants 16 bits et la quantification d'entiers, ggml assure un calcul efficace, en exploitant des algorithmes d'optimisation intégrés tels qu'ADAM et L-BFGS.

? Compatibilité polyvalente : De l'optimisation Apple Silicon à la prise en charge de WebAssembly, ggml s'adapte à diverses architectures sans dépendances tierces, garantissant une intégration fluide dans n'importe quel environnement.

? Haute efficacité : Aucune allocation de mémoire pendant l'exécution et la prise en charge de sortie linguistique guidée rationalisent le développement, améliorant la productivité et les performances.

Cas d'utilisation :

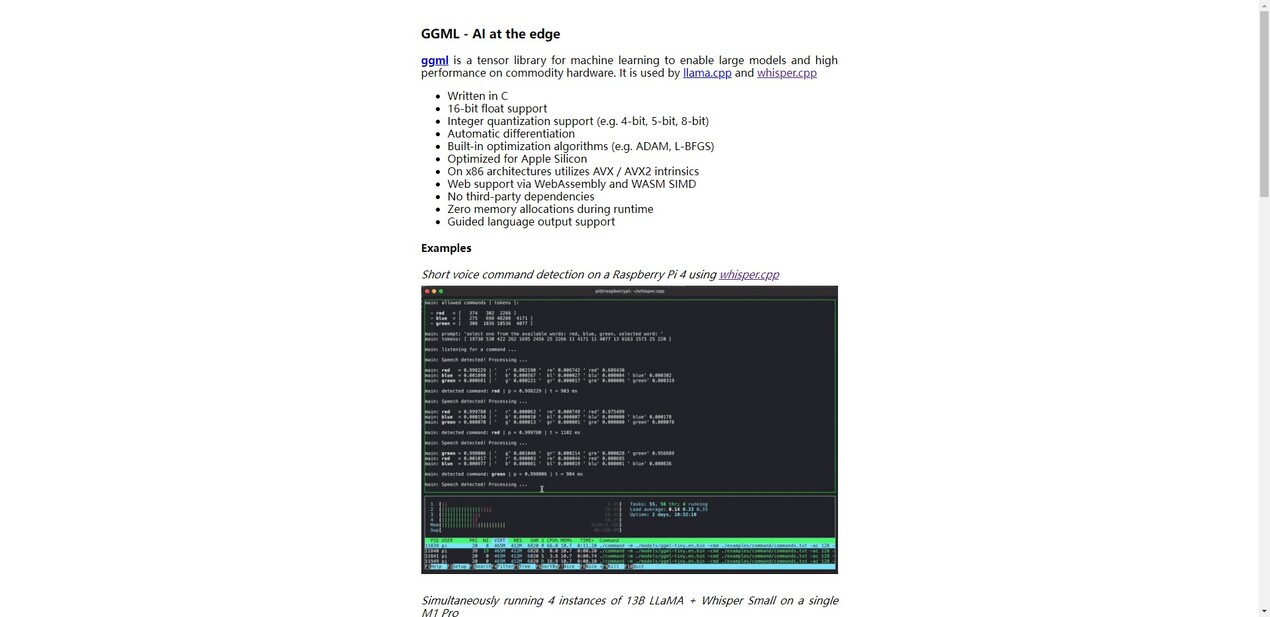

Détection de commande vocale basée sur la périphérie : Utilisez ggml pour la détection de commande vocale courte sur des appareils comme Raspberry Pi 4, garantissant des réponses rapides et précises.

Inférence multi-instance : Exécutez plusieurs instances de grands modèles linguistiques comme LLaMA sur Apple M1 Pro, maximisant l'efficacité de calcul pour diverses applications.

Traitement du langage en temps réel : Obtenez une génération rapide de jetons avec de grands modèles linguistiques sur du matériel de pointe comme M2 Max, améliorant les capacités de traitement du langage naturel pour diverses tâches.

Conclusion :

ggml.ai offre une solution transformatrice pour l'inférence sur les appareils, permettant aux développeurs d'exploiter tout le potentiel de l'apprentissage automatique sur du matériel courant. Rejoignez-nous pour simplifier le développement de l'IA, explorer de nouvelles possibilités et repousser les limites de l'innovation. Faites l'expérience de l'efficacité et de la flexibilité de ggml.ai dès aujourd'hui et ouvrez les portes de l'avenir de l'inférence sur les appareils.