What is Gpt-oss?

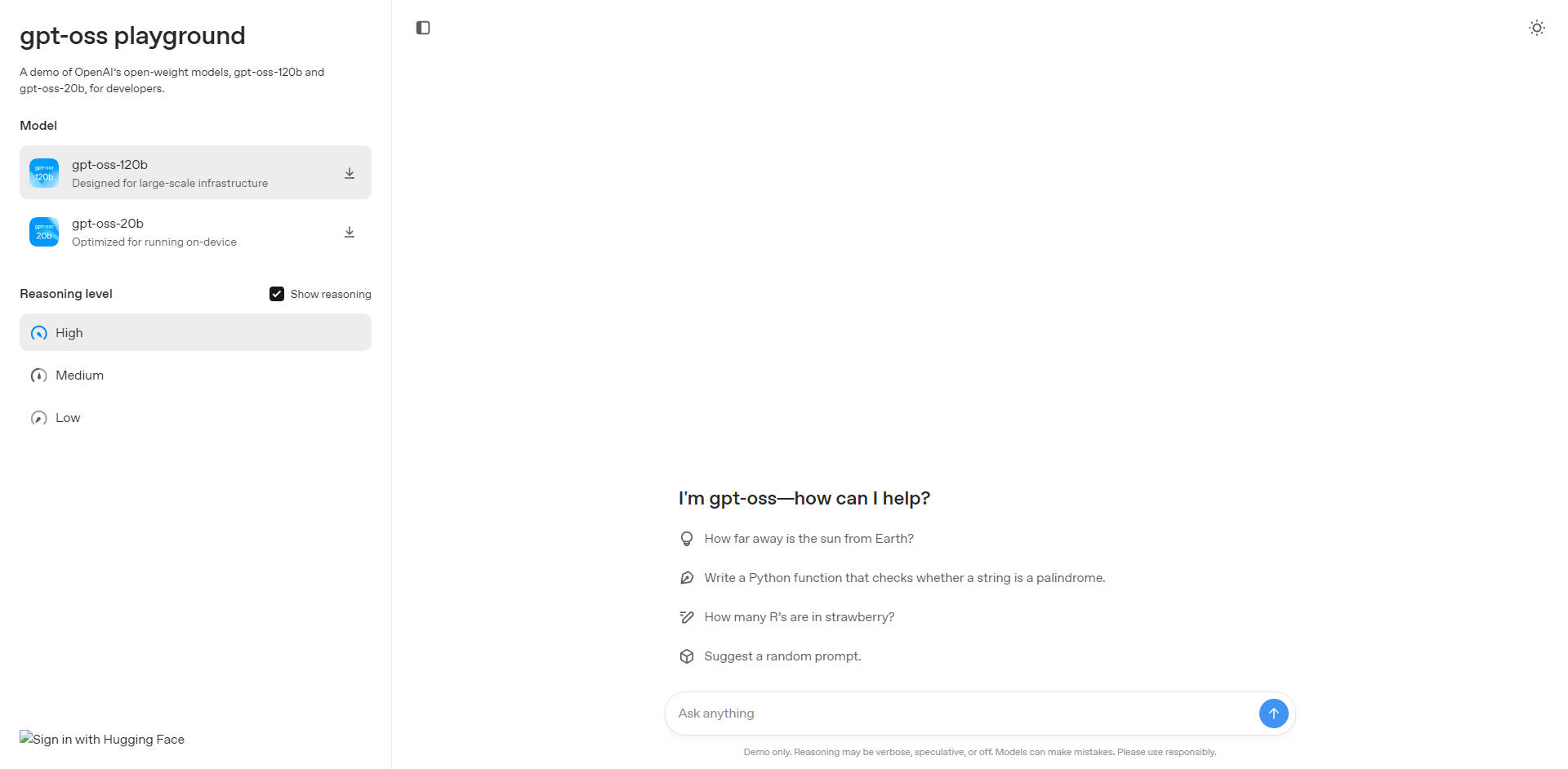

OpenAI presenta gpt-oss-120b y gpt-oss-20b, dos potentes y altamente eficientes modelos de lenguaje de código abierto. Diseñados para desarrolladores, investigadores y empresas, resuelven un desafío crucial: acceder a un rendimiento de IA de vanguardia sin las limitaciones de las APIs propietarias. Con licencia bajo la flexible Apache 2.0, ahora puede ejecutar, personalizar y ajustar estos modelos directamente en su propia infraestructura, desde servidores de alta gama hasta hardware de consumo.

Características clave

🚀 Modelos duales para un rendimiento escalable Elija el modelo que mejor se adapte a sus necesidades. gpt-oss-120b ofrece un rendimiento de razonamiento a la par de los modelos propietarios líderes y se ejecuta eficientemente en una única GPU de 80 GB. Para una máxima accesibilidad, gpt-oss-20b ofrece capacidades impresionantes en dispositivos de borde y hardware con tan solo 16 GB de memoria, lo que lo hace ideal para aplicaciones locales y en el dispositivo.

🤖 Uso superior de herramientas y razonamiento Estos modelos están diseñados para flujos de trabajo complejos basados en agentes. Sobresalen en el seguimiento de instrucciones, utilizando herramientas como la búsqueda web y la ejecución de código Python, y empleando el razonamiento en Cadena de Pensamiento (CoT) para resolver problemas. Esto los convierte en una base sólida para construir agentes de IA sofisticados que pueden interactuar con sistemas externos para completar tareas.

⚙️ Optimizados para la eficiencia con MoE Los modelos gpt-oss utilizan una arquitectura de Mezcla de Expertos (MoE), un diferenciador clave respecto a los modelos densos tradicionales. Al activar solo una fracción de sus parámetros totales para cada tarea (5.100 millones para el modelo de 120B, 3.600 millones para el de 20B), reducen drásticamente los costos computacionales y los requisitos de memoria, lo que permite su excepcional relación rendimiento-hardware.

🛡️ Estándares de seguridad avanzados incorporados La seguridad es un principio fundamental de esta versión. Los modelos han sido sometidos a un extenso entrenamiento de seguridad, incluyendo técnicas de filtrado de datos y alineación para rechazar solicitudes dañinas. Se rigen por los mismos criterios de seguridad internos que los modelos propietarios más avanzados de OpenAI, proporcionando una base confiable para sus aplicaciones.

🔧 Totalmente abierto y personalizable Con la licencia Apache 2.0, tiene la libertad de innovar. Puede ajustar los modelos en sus conjuntos de datos privados para tareas especializadas e inspeccionar su proceso completo y no supervisado de Cadena de Pensamiento (CoT). Esta transparencia es invaluable para la investigación, la depuración y el monitoreo del comportamiento del modelo.

Ventajas únicas

Los modelos gpt-oss no son solo otra versión de código abierto. Están diseñados para ofrecer una combinación distintiva de rendimiento, eficiencia y transparencia que los distingue.

Rendimiento que rivaliza con los sistemas propietarios: Mientras que muchos modelos abiertos comprometen la capacidad, gpt-oss-120b ofrece resultados competitivos y, en algunos casos, superiores a los de los modelos propietarios líderes como o4-mini de OpenAI. En exigentes puntos de referencia para consultas relacionadas con la salud (HealthBench) y matemáticas de competición (AIME), los modelos gpt-oss superan incluso a sistemas de primer nivel como o1 y GPT-4o.

Eficiencia sin precedentes para la potencia: A diferencia de los modelos densos que son computacionalmente costosos, gpt-oss aprovecha su arquitectura MoE para ofrecer un rendimiento de élite en hardware accesible. La capacidad de ejecutar un modelo de la clase de 120 mil millones de parámetros en una única GPU o un modelo de 20 mil millones de parámetros en un portátil estaba anteriormente fuera del alcance de la mayoría de los desarrolladores.

Los únicos modelos de OpenAI con CoT no supervisado: Mientras que nuestros modelos de API tienen un razonamiento alineado, los modelos gpt-oss se lanzan intencionadamente con una Cadena de Pensamiento (CoT) no supervisada. Este enfoque único proporciona una visión sin filtros del proceso de razonamiento del modelo, ofreciendo una herramienta esencial para investigadores y desarrolladores centrados en la seguridad, la alineación y la interpretabilidad.

Un linaje de entrenamiento de vanguardia: Estos modelos son el resultado directo de las mismas técnicas avanzadas de post-entrenamiento y aprendizaje por refuerzo utilizadas para crear los modelos de inferencia propietarios más capaces de OpenAI. Está obteniendo los beneficios de una metodología de entrenamiento de clase mundial en un paquete totalmente abierto y adaptable.

Conclusión:

Los modelos gpt-oss-120b y gpt-oss-20b representan un paso significativo hacia la democratización del acceso a una IA potente. Acortan la brecha entre la flexibilidad del código abierto y la capacidad bruta de los sistemas propietarios de vanguardia. Ya sea usted un desarrollador independiente prototipando en un portátil, un investigador que empuja los límites de la seguridad de la IA, o una empresa que implementa soluciones en local, estos modelos le proporcionan la potencia, la eficiencia y el control que necesita para construir la próxima generación de aplicaciones de IA.

¡Descubra cómo gpt-oss puede acelerar su trabajo hoy mismo!

FAQ

1. ¿Cuál es la principal diferencia entre los modelos gpt-oss-120b y gpt-oss-20b? La diferencia principal radica en el equilibrio entre rendimiento y requisitos de hardware. gpt-oss-120b es el modelo más potente, diseñado para una máxima capacidad de razonamiento y finalización de tareas, y está optimizado para ejecutarse en una única GPU de 80 GB. gpt-oss-20b está diseñado para una máxima eficiencia y accesibilidad, ofreciendo un rendimiento sólido en hardware de consumo con tan solo 16 GB de memoria, lo que lo hace perfecto para escenarios de computación en el dispositivo o en el borde.

2. ¿Cómo se comparan estos modelos abiertos con el uso de las APIs de OpenAI? Los modelos gpt-oss son ideales cuando se requiere control total, personalización o la necesidad de ejecutar modelos en un entorno local o privado para la seguridad de los datos. Puede ajustarlos ampliamente e inspeccionar su funcionamiento interno. Nuestros modelos de API siguen siendo la mejor opción si necesita un servicio totalmente gestionado, capacidades multimodales (como visión), integraciones de herramientas incorporadas y actualizaciones de plataforma fluidas sin gestionar la infraestructura.

3. ¿Qué significa "Cadena de Pensamiento (CoT) no supervisada" para mí como desarrollador? Significa que tiene acceso al proceso de "pensamiento" crudo y paso a paso del modelo antes de que produzca una respuesta final. Esto es increíblemente valioso para la depuración, la comprensión del comportamiento del modelo y la realización de investigación sobre seguridad. Sin embargo, dado que no está filtrada, la CoT no debe mostrarse a los usuarios finales, ya que puede contener imprecisiones o contenido que no cumpla con los estándares de seguridad de la salida final.

More information on Gpt-oss

Gpt-oss Alternativas

Más Alternativas-

¡OLMo 2 32B: El LLM de código abierto que desafía a GPT-3.5! Código, datos y pesos gratuitos. Investiga, personaliza y crea una IA más inteligente.

-

DeepCoder: IA con código de contexto de 64K. ¡Modelo de código abierto de 14B supera las expectativas! Contexto extenso, entrenamiento mediante RL y rendimiento superior.

-

MonsterGPT: Afina y despliega modelos de IA personalizados a través de chat. Simplifica tareas complejas de LLM e IA. Accede fácilmente a más de 60 modelos de código abierto.

-

GPT-NeoX-20B es un modelo de lenguaje autoregresivo de 20 mil millones de parámetros entrenado en el Conjunto de Datos utilizando la biblioteca GPT-NeoX.

-

Un espacio de trabajo GenAI seguro y compartido para equipos. Unifica los modelos de IA más avanzados, el conocimiento de proyectos y las conversaciones. Colaborar con confianza, crear juntos e impulsar la productividad, todo en un solo lugar.