What is PromptShuttle?

¿Cansado de lidiar con prompts de LLM dispersos por todo tu código base? ¿Sientes que experimentar con diferentes modelos e iteraciones es un proceso lento y doloroso? ¡No estás solo! La gestión de prompts a medida que tu aplicación crece puede volverse rápidamente caótica, dificultando la colaboración y haciendo que la visibilidad sea inexistente.

¡Ahí es donde entra PromptShuttle! Es tu monitor y proxy de LLM simple y potente, diseñado para desacoplar completamente tus prompts de tu código. Esto significa que puedes experimentar libremente, colaborar sin problemas con tu equipo y expertos en el dominio, e implementar actualizaciones de prompts sin tocar nunca el código de tu aplicación principal. ¡Obtén una visibilidad nítida del uso de tu LLM e itera con confianza hacia prompts de clase mundial!

✨ Experimenta sin esfuerzo: Prueba prompts con una gran variedad de LLM, por separado o todos a la vez, y compara instantáneamente los resultados en paralelo. ¡Encuentra la combinación perfecta de modelo y prompt más rápido que nunca!

🤝 Colabora como un profesional: Administra diferentes versiones de prompts, agrega comentarios en línea (¡estilo // o /* */!) para un contexto nítido, y rastrea cada cambio con una interfaz de usuario sencilla. ¡Está diseñado para que los equipos trabajen juntos sin problemas!

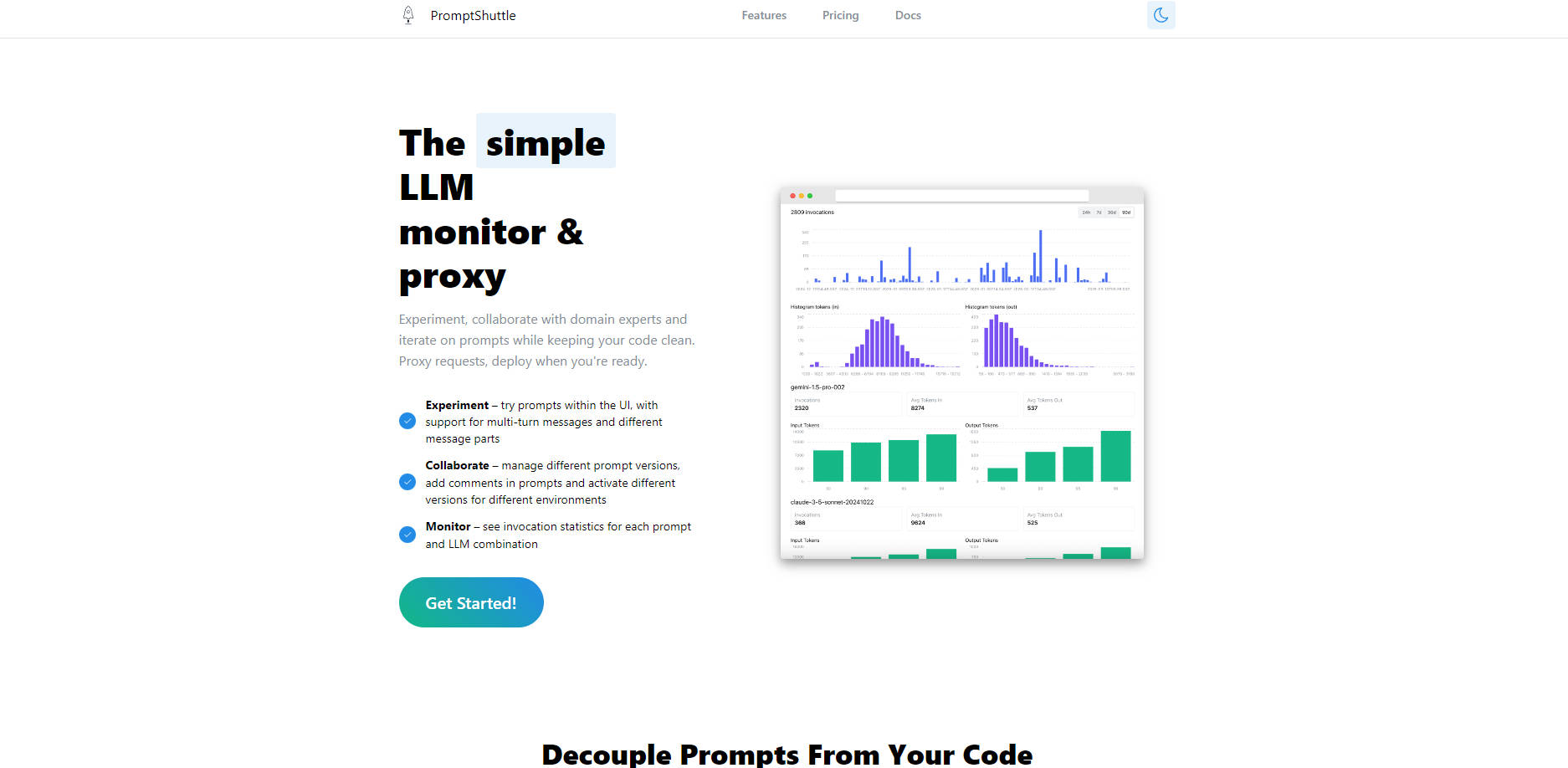

📈 Supervisa con confianza: Visualiza estadísticas detalladas de invocación para cada combinación de prompt y LLM directamente en un solo lugar. ¡Comprende el rendimiento, rastrea el uso y toma decisiones basadas en datos para optimizar tus flujos de trabajo de LLM!

🔗 Desacopla los prompts del código: Mueve toda la lógica de tus prompts fuera del código de tu aplicación. ¡Actualiza los prompts, cambia de modelo o implementa nuevas versiones por entorno sin escribir ni implementar código nuevo!

🚦 Simplifica la integración de LLM: ¡Utiliza PromptShuttle como un proxy inteligente! Accede a docenas de modelos (como GPT-4o, Claude 3.7 Sonnet, Llama3, Gemini 1.5, ¡y muchos más!) a través de una única API unificada. ¡Obtén registros consolidados, facturación centralizada e incluso configura conmutaciones por error automatizadas!

✏️ Crea plantillas dinámicas: Crea fácilmente plantillas para tus prompts utilizando [[tokens]] y reemplaza los valores con un simple objeto JSON en tus llamadas a la API. ¡Crea prompts reutilizables y flexibles que se adapten a tus necesidades!

👻 Prueba sin costo: Utiliza el respondedor "Fake LLM" integrado para probar tus plantillas de prompts a fondo durante el desarrollo sin incurrir en costos de la API de LLM. ¡Itera rápidamente y ahorra dinero!

Mira PromptShuttle en acción:

Iteración rápida de prompts: Como desarrollador, estás creando una nueva característica que depende de una tarea específica de LLM. Utiliza la interfaz de usuario de Experimentación y Fake LLM de PromptShuttle para redactar y probar rápidamente variaciones de tu prompt, comparar resultados entre diferentes modelos como GPT-4o y Claude 3.7, y encontrar el mejor absoluto antes de integrarlo en tu aplicación.

Perfeccionamiento de prompts en equipo: Tu producto requiere respuestas matizadas y los expertos en el dominio tienen información crucial sobre la redacción de los prompts. Utiliza las funciones de colaboración de PromptShuttle (control de versiones y comentarios) para permitir que los expertos en el dominio y los gerentes de producto sugieran y rastreen los cambios en los prompts gestionados fuera del código base, asegurando que todos contribuyan al mejor resultado posible.

Flujos de trabajo de producción robustos: Has implementado una aplicación que depende de LLM. Utiliza PromptShuttle como proxy para manejar todas las solicitudes de LLM. Supervisa las estadísticas de uso para obtener información sobre el rendimiento, administra las versiones de los prompts para diferentes entornos (staging vs. producción) y aprovecha las conmutaciones por error automatizadas para aumentar la fiabilidad de tus integraciones de LLM, ¡al igual que TenderStrike lo hace para su análisis de IA!

PromptShuttle hace que la creación, gestión y supervisión de tus prompts de LLM sea sencilla y eficiente. Es la forma inteligente de mantener tu código limpio, impulsar la colaboración en equipo y obtener una visibilidad esencial de tu actividad de LLM.

¿Listo para simplificar tu flujo de trabajo de LLM?

¡Regístrate gratis hoy y obtén acceso instantáneo a todos los modelos!

More information on PromptShuttle

PromptShuttle Alternativas

PromptShuttle Alternativas-

SysPrompt es una plataforma integral diseñada para simplificar la gestión, prueba y optimización de prompts para Modelos de Lenguaje Extensos (LLMs). Se trata de un entorno colaborativo donde los equipos pueden trabajar juntos en tiempo real, realizar un seguimiento de las versiones de los prompts, ejecutar evaluaciones y probar diferentes modelos de LLM, todo en un solo lugar.

-

Optimice la ingeniería de prompts para LLM. PromptLayer ofrece gestión, evaluación y observabilidad en una única plataforma. Cree una IA mejor, más rápido.

-

PromptTools es una plataforma de código abierto que ayuda a los desarrolladores a construir, monitorizar y mejorar aplicaciones de LLM mediante la experimentación, la evaluación y la retroalimentación.

-

Prueba, compara y perfecciona tus prompts en más de 50 LLM al instante, sin necesidad de claves API ni registros. Aplica esquemas JSON, ejecuta pruebas y colabora. Crea una IA mejor, más rápido con LangFast.

-

Mejora el rendimiento del Modelo de lenguaje con promptfoo. Itera más rápido, mide las mejoras en calidad, detecta regresiones y más. Perfecto para investigadores y desarrolladores.