What is PromptShuttle?

Fatigué de jongler avec des prompts de LLM éparpillés dans votre code ? Avez-vous l'impression qu'expérimenter avec différents modèles et itérations est un processus lent et pénible ? Vous n'êtes pas le seul ! Gérer les prompts au fur et à mesure que votre application se développe peut rapidement devenir chaotique, rendant la collaboration difficile et la visibilité inexistante.

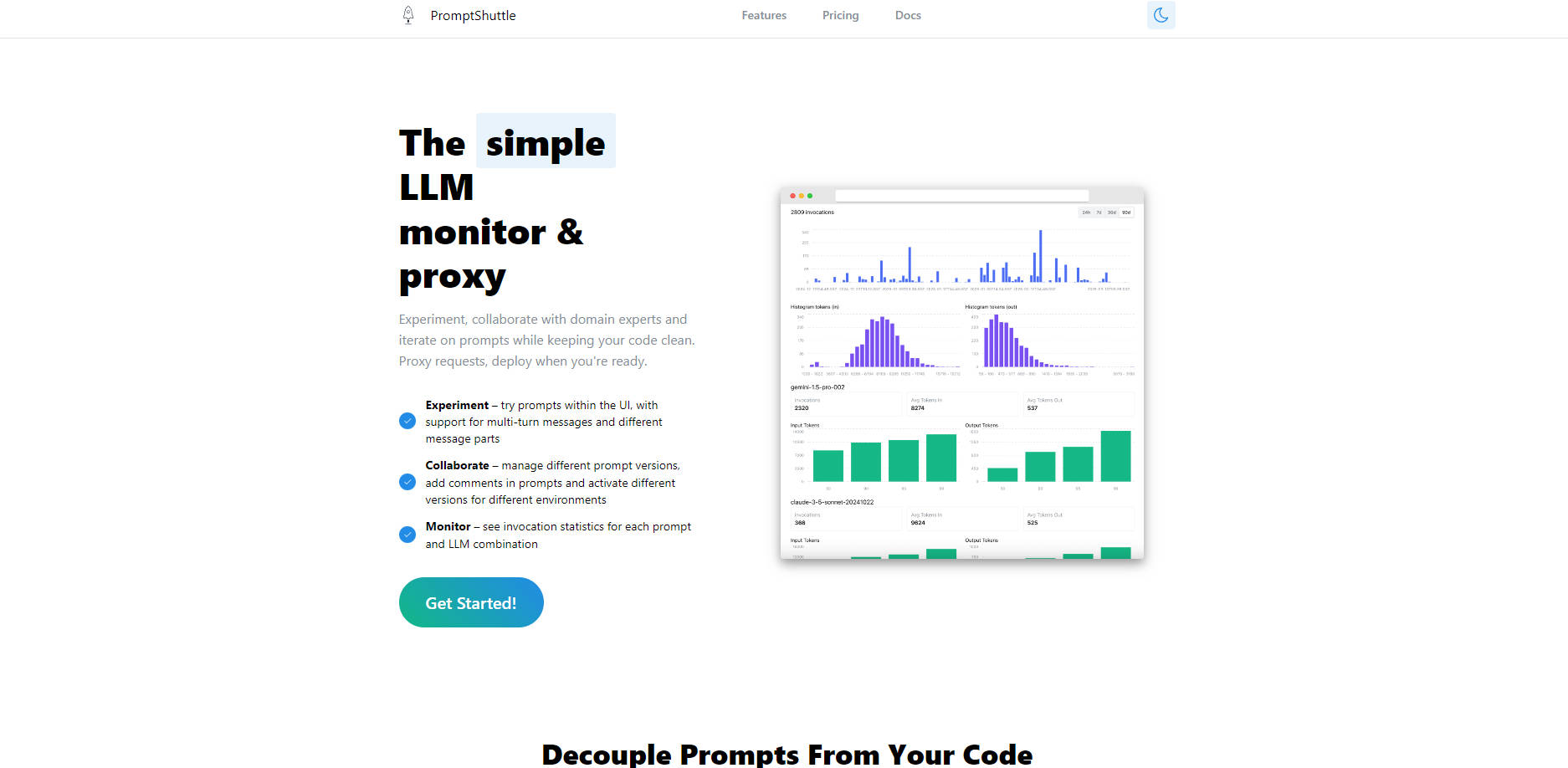

C'est là que PromptShuttle entre en jeu ! C'est votre moniteur et proxy LLM simple et puissant, conçu pour découpler complètement vos prompts de votre code. Cela signifie que vous pouvez expérimenter librement, collaborer de manière transparente avec votre équipe et vos experts du domaine, et déployer des mises à jour de prompts sans jamais toucher au code de votre application principale. Bénéficiez d'une visibilité parfaite sur votre utilisation des LLM et itérez en toute confiance vers des prompts de classe mondiale !

✨ Expérimentez sans effort : Testez les prompts sur une grande variété de LLM – séparément ou tous en même temps – et comparez instantanément les résultats côte à côte. Trouvez la combinaison parfaite de modèle et de prompt plus rapidement que jamais !

🤝 Collaborez comme un pro : Gérez différentes versions de prompts, ajoutez des commentaires en ligne (style // ou /* */ !) pour un contexte parfaitement clair, et suivez chaque modification grâce à une interface utilisateur simple. Il est conçu pour que les équipes travaillent ensemble de manière transparente !

📈 Surveillez en toute confiance : Consultez des statistiques d'invocation détaillées pour chaque combinaison de prompt et de LLM, le tout au même endroit. Comprenez les performances, suivez l'utilisation et prenez des décisions basées sur les données pour optimiser vos flux de travail LLM !

🔗 Découplez les prompts du code : Déplacez complètement votre logique de prompt hors du code de votre application. Mettez à jour les prompts, changez de modèle ou déployez de nouvelles versions par environnement sans écrire ni déployer de nouveau code !

🚦 Simplifiez l'intégration des LLM : Utilisez PromptShuttle comme un proxy intelligent ! Accédez à des dizaines de modèles (tels que GPT-4o, Claude 3.7 Sonnet, Llama3, Gemini 1.5 et bien d'autres !) via une API unique et unifiée. Bénéficiez de journaux consolidés, d'une facturation centralisée et configurez même des basculements automatisés !

✏️ Créez des modèles dynamiques : Créez facilement des modèles pour vos prompts en utilisant [[tokens]] et remplacez les valeurs par un simple objet JSON dans vos appels API. Créez des prompts réutilisables et flexibles qui s'adaptent à vos besoins !

👻 Testez sans frais : Utilisez le répondeur "Fake LLM" intégré pour tester minutieusement vos modèles de prompts pendant le développement sans encourir de frais d'API LLM. Itérez rapidement et économisez de l'argent !

Découvrez PromptShuttle en action :

Itération rapide des prompts : En tant que développeur, vous créez une nouvelle fonctionnalité qui repose sur une tâche LLM spécifique. Utilisez l'interface utilisateur d'expérimentation de PromptShuttle et Fake LLM pour rédiger et tester rapidement des variations de votre prompt, comparer les résultats entre différents modèles tels que GPT-4o et Claude 3.7, et trouver le meilleur avant de l'intégrer à votre application.

Affinement des prompts en équipe : Votre produit nécessite des réponses nuancées, et les experts du domaine ont un apport crucial sur le libellé des prompts. Utilisez les fonctionnalités de collaboration de PromptShuttle – le contrôle de version et les commentaires – pour permettre aux experts du domaine et aux chefs de produit de suggérer et de suivre les modifications des prompts gérés en dehors du code, en veillant à ce que chacun contribue au meilleur résultat possible.

Flux de travail de production robustes : Vous avez déployé une application qui s'appuie sur des LLM. Utilisez PromptShuttle comme proxy pour gérer toutes les requêtes LLM. Surveillez les statistiques d'utilisation pour obtenir des informations sur les performances, gérez les versions de prompts pour différents environnements (staging vs. production) et tirez parti des basculements automatisés pour augmenter la fiabilité de vos intégrations LLM, tout comme TenderStrike le fait pour son analyse IA !

PromptShuttle rend la création, la gestion et la surveillance de vos prompts LLM simples et efficaces. C'est la façon intelligente de garder votre code propre, de stimuler la collaboration en équipe et d'obtenir une visibilité essentielle sur votre activité LLM.

Prêt à simplifier votre flux de travail LLM ?

Inscrivez-vous gratuitement dès aujourd'hui et obtenez un accès instantané à tous les modèles !

More information on PromptShuttle

PromptShuttle alternatives

PromptShuttle alternatives-

SysPrompt est une plateforme complète conçue pour simplifier la gestion, les tests et l'optimisation des invites pour les grands modèles de langage (LLM). C'est un environnement collaboratif où les équipes peuvent travailler ensemble en temps réel, suivre les versions des invites, effectuer des évaluations et tester différents modèles LLM — le tout en un seul endroit.

-

Rationalisez l'ingénierie des prompts LLM. PromptLayer propose la gestion, l'évaluation et l'observabilité sur une seule plateforme. Créez de meilleures IA, plus vite.

-

PromptTools est une plateforme open-source qui aide les développeurs à construire, surveiller et améliorer les applications LLM grâce à l'expérimentation, l'évaluation et la rétroaction.

-

Testez, comparez et peaufinez vos invites sur plus de 50 LLM instantanément, sans nécessiter de clés API ni d'inscription. Validez les schémas JSON, exécutez des tests et collaborez. Développez une IA plus performante plus rapidement avec LangFast.

-

Améliorez les performances du modèle linguistique avec promptfoo. Itérer plus rapidement, mesurer les améliorations de la qualité, détecter les régressions, et plus encore. Parfait pour les chercheurs et les développeurs.