What is PromptShuttle?

コードベース全体に散在するLLMプロンプトの管理にうんざりしていませんか? さまざまなモデルやイテレーションを試すのが、時間と手間のかかる苦痛なプロセスだと感じていませんか? ご安心ください、それはあなただけではありません! アプリケーションの成長に伴い、プロンプトの管理はすぐに煩雑になり、コラボレーションが困難になり、可視性が皆無になる可能性があります。

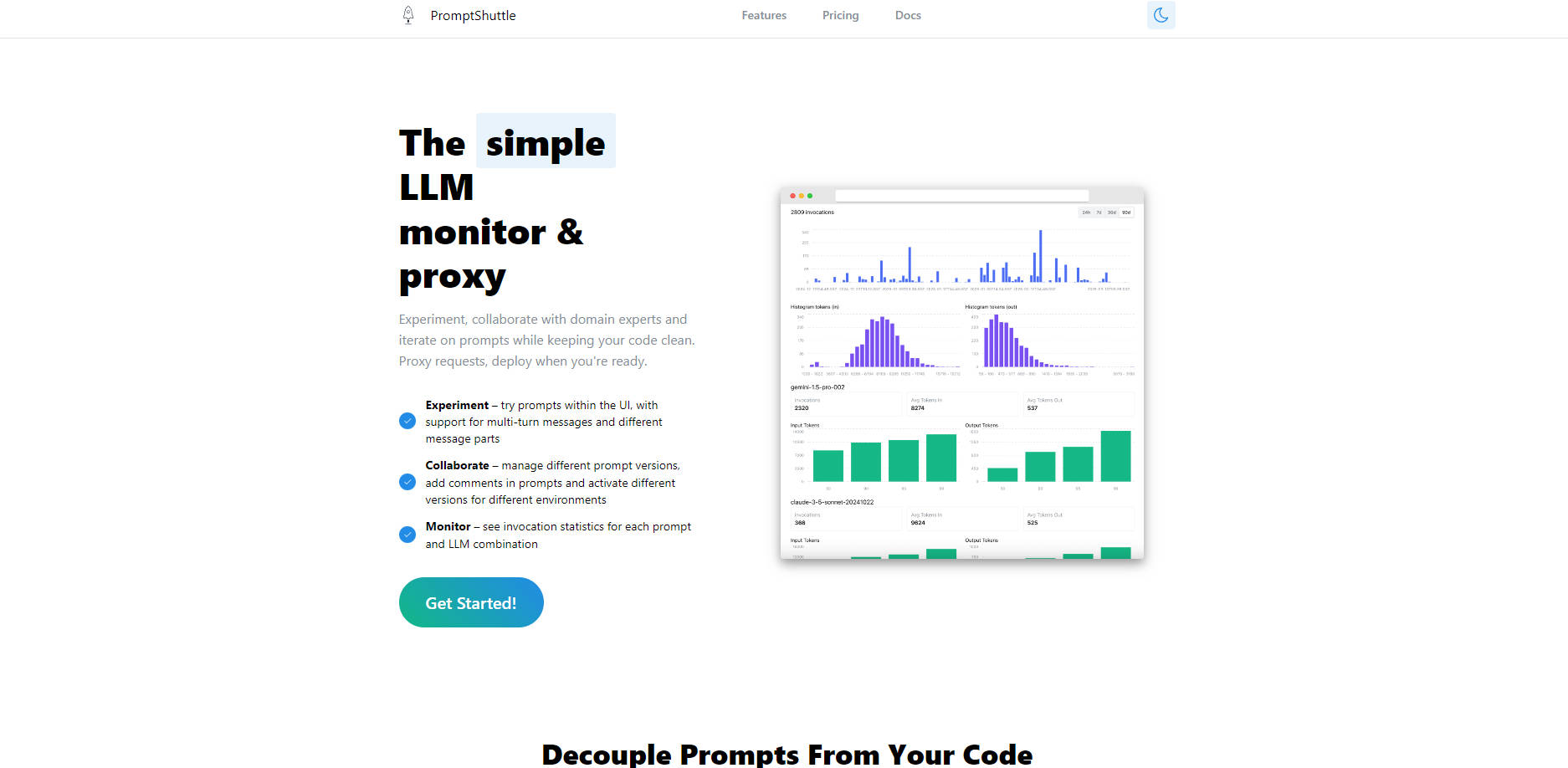

そこで、PromptShuttleの登場です! これは、プロンプトをコードから完全に分離するように設計された、シンプルで強力なLLMモニターおよびプロキシです。 つまり、自由に実験し、チームやドメインの専門家とシームレスにコラボレーションし、コアアプリケーションコードに一切触れることなくプロンプトの更新をデプロイできます。 LLMの使用状況を明確に把握し、世界レベルのプロンプトに向けて自信を持って反復することができます!

✨ 簡単な実験: 膨大な種類のLLMに対して、個別にまたは一度にプロンプトを試し、結果を即座に並べて比較します。 完璧なモデルとプロンプトの組み合わせをこれまで以上に迅速に見つけましょう!

🤝 プロのようなコラボレーション: さまざまなプロンプトバージョンを管理し、インラインコメント(// または /* */ スタイル!)を追加して、コンテキストを明確にし、シンプルなUIですべての変更を追跡します。 チームがシームレスに連携できるように構築されています!

📈 自信を持って監視: すべてのプロンプトとLLMの組み合わせに関する詳細な呼び出し統計を1か所で確認できます。 パフォーマンスを理解し、使用状況を追跡し、データに基づいた意思決定を行って、LLMワークフローを最適化します!

🔗 コードからプロンプトを分離: プロンプトのロジックをアプリケーションコードから完全に取り除きます。 プロンプトを更新したり、モデルを切り替えたり、新しいコードを作成またはデプロイすることなく、環境ごとに新しいバージョンをデプロイしたりできます!

🚦 LLM統合を簡素化: PromptShuttleをスマートプロキシとして使用してください! 単一の統合されたAPIを介して、多数のモデル(GPT-4o、Claude 3.7 Sonnet、Llama3、Gemini 1.5など!)にアクセスできます。 統合されたログ、一元化された請求、さらには自動フェールオーバーの設定も可能です!

✏️ 動的テンプレートの作成: [[tokens]]を使用してプロンプトを簡単にテンプレート化し、API呼び出しで単純なJSONオブジェクトを使用して値を置き換えます。 ニーズに合わせて適応できる、再利用可能で柔軟なプロンプトを作成します!

👻 コストをかけずにテスト: 組み込みの「Fake LLM」レスポンダーを使用して、LLM APIのコストを発生させることなく、開発中にプロンプトテンプレートを徹底的にテストします。 迅速に反復処理を行い、コストを節約しましょう!

PromptShuttleの動作をご覧ください:

迅速なプロンプトの反復: 開発者として、特定のLLMタスクに依存する新機能を構築しています。 PromptShuttleの実験UIとFake LLMを使用して、プロンプトのバリエーションをすばやく作成してテストし、GPT-4oやClaude 3.7などのさまざまなモデルで結果を比較して、アプリケーションに統合する前に最適なものを見つけます。

チームでのプロンプトの改良: 製品にはニュアンスのある応答が必要であり、ドメインの専門家はプロンプトの言い回しについて重要な意見を持っています。 PromptShuttleのコラボレーション機能(バージョニングとコメント)を使用して、ドメインの専門家とプロダクトマネージャーがコードベースの外部で管理されるプロンプトへの変更を提案および追跡できるようにし、すべての人が可能な限り最高の出力に貢献できるようにします。

堅牢な本番ワークフロー: LLMに依存するアプリケーションをデプロイしました。 PromptShuttleをプロキシとして使用して、すべてのLLMリクエストを処理します。 パフォーマンスに関する洞察を得るために使用状況の統計を監視し、さまざまな環境(ステージングと本番環境)のプロンプトバージョンを管理し、自動フェールオーバーを活用してLLM統合の信頼性を高めます。TenderStrikeがAI分析で行っているように!

PromptShuttleを使用すると、LLMプロンプトの構築、管理、監視が簡単かつ効率的になります。 コードをクリーンに保ち、チームのコラボレーションを促進し、LLMアクティビティに関する重要な可視性を獲得するためのスマートな方法です。

LLMワークフローを簡素化する準備はできましたか?

今すぐ無料登録して、すべてのモデルにすぐにアクセスしましょう!

More information on PromptShuttle

PromptShuttle 代替

PromptShuttle 代替-

SysPromptは、大規模言語モデル(LLM)のプロンプト管理、テスト、最適化を簡素化する包括的なプラットフォームです。チームがリアルタイムで共同作業を行い、プロンプトのバージョンの追跡、評価の実行、様々なLLMモデルでのテストを全て一元的に行える、協調的な環境を提供します。

-

LLMプロンプトエンジニアリングを効率化。PromptLayerは、管理、評価、そして可観測性を単一プラットフォームで提供します。より優れたAIを、より迅速に構築。

-

PromptToolsは、実験、評価、フィードバックを通じて、開発者がLLMアプリケーションを構築、監視、改善するのを支援するオープンソースプラットフォームです。

-

50種類以上のLLMを対象に、プロンプトのテスト、比較、洗練を瞬時に行えます — APIキーやサインアップは一切不要です。JSONスキーマの適用、テストの実行、そして共同作業も可能にします。LangFastで、より優れたAIをより迅速に構築しましょう。

-

prompfooで言語モデルのパフォーマンスを向上させましょう。イテレーションを迅速に、品質改善を測定し、回帰を検出するなど、研究者や開発者に最適です。