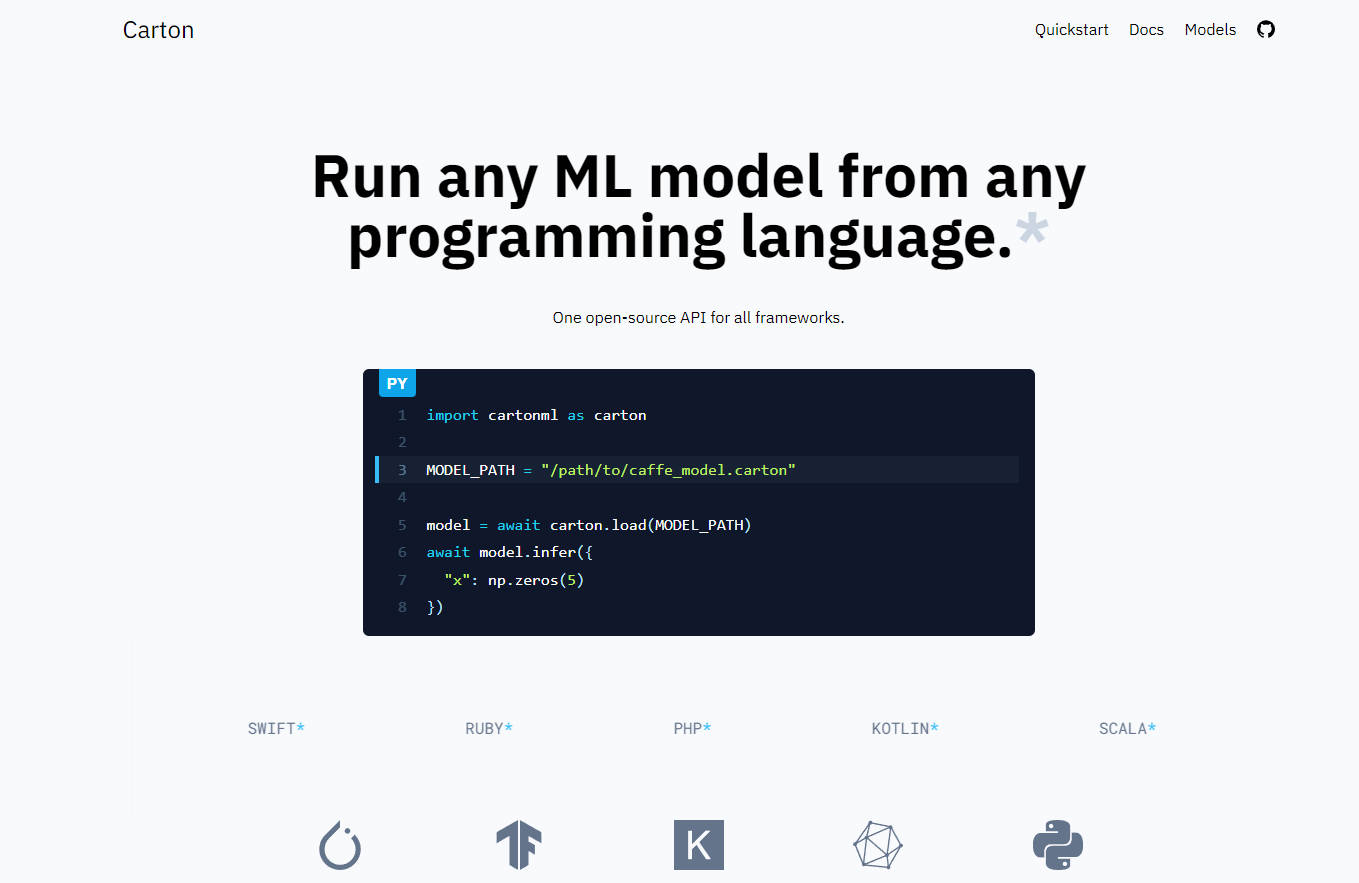

What is Carton?

Carton est un logiciel qui permet aux utilisateurs d'exécuter des modèles d'apprentissage automatique (ML) à partir de n'importe quel langage de programmation. Il découple le code d'inférence des frameworks ML spécifiques, permettant aux utilisateurs de suivre facilement les technologies de pointe. Carton a de faibles frais généraux et prend en charge diverses plates-formes, notamment x86_64 Linux et macOS, aarch64 Linux, aarch64 macOS et WebAssembly.

Fonctionnalités clés :

- Découple la mise en œuvre du framework ML : Carton permet aux utilisateurs d'exécuter des modèles ML sans être liés à des frameworks spécifiques tels que Torch ou TensorFlow.

- Frais généraux faibles : les premiers benchmarks montrent des frais généraux inférieurs à 100 microsecondes par appel d'inférence.

- Prise en charge de la plateforme : Carton prend actuellement en charge x86_64 Linux et macOS, aarch64 Linux, aarch64 macOS et WebAssembly.

- Emballage sans modification : une boîte en carton est la sortie de l'étape d'emballage qui contient le modèle d'origine et les métadonnées. Il ne modifie pas le modèle d'origine, évitant ainsi les étapes de conversion sujettes aux erreurs.

- Prise en charge des opérations personnalisées : Carton utilise le framework sous-jacent (par exemple, PyTorch) pour l'exécution des modèles, ce qui facilite l'utilisation d'opérations personnalisées comme TensorRT sans modifications.

- Prise en charge future d'ONNX : bien que Carton encapsule les modèles au lieu de les convertir comme le fait ONNX, il est prévu de prendre en charge les modèles ONNX dans Carton afin de permettre des cas d'utilisation intéressants tels que l'exécution de modèles dans le navigateur avec WASM.

Cas d'utilisation :

1. Expérimentation rapide : en découplant le code d'inférence des frameworks spécifiques et en réduisant les étapes de conversion, Carton permet une expérimentation plus rapide avec différents modèles ML.

2. Flexibilité de déploiement : avec sa prise en charge de la plateforme pour divers systèmes d'exploitation, notamment Linux et macOS sur différentes architectures comme x86_64 et aarch64, Carton offre une flexibilité dans le déploiement de modèles ML dans différents environnements.

3. Intégration d'opérations personnalisées : la possibilité d'utiliser des opérations personnalisées comme TensorRT permet aux développeurs d'optimiser plus facilement leurs flux de travail ML en fonction de leurs exigences spécifiques.

4. ML dans le navigateur : avec la future prise en charge des modèles ONNX et de WebAssembly, Carton peut être utilisé pour exécuter des modèles ML directement dans les navigateurs Web, ouvrant ainsi des possibilités pour les applications basées sur navigateur qui nécessitent des capacités d'apprentissage automatique.

More information on Carton

Top 5 Countries

Traffic Sources

Carton Alternatives

Plus Alternatives-

ONNX Runtime : Exécutez vos modèles de ML plus rapidement, où que vous soyez. Accélérez l'inférence et l'entraînement sur toutes les plateformes. Prise en charge de PyTorch, TensorFlow et bien plus encore !

-

Cortex est un moteur d'IA compatible OpenAI que les développeurs peuvent utiliser pour créer des applications LLM. Il est fourni avec une interface de ligne de commande et des bibliothèques clientes inspirées de Docker. Il peut être utilisé comme serveur autonome ou importé en tant que bibliothèque.

-

-

-