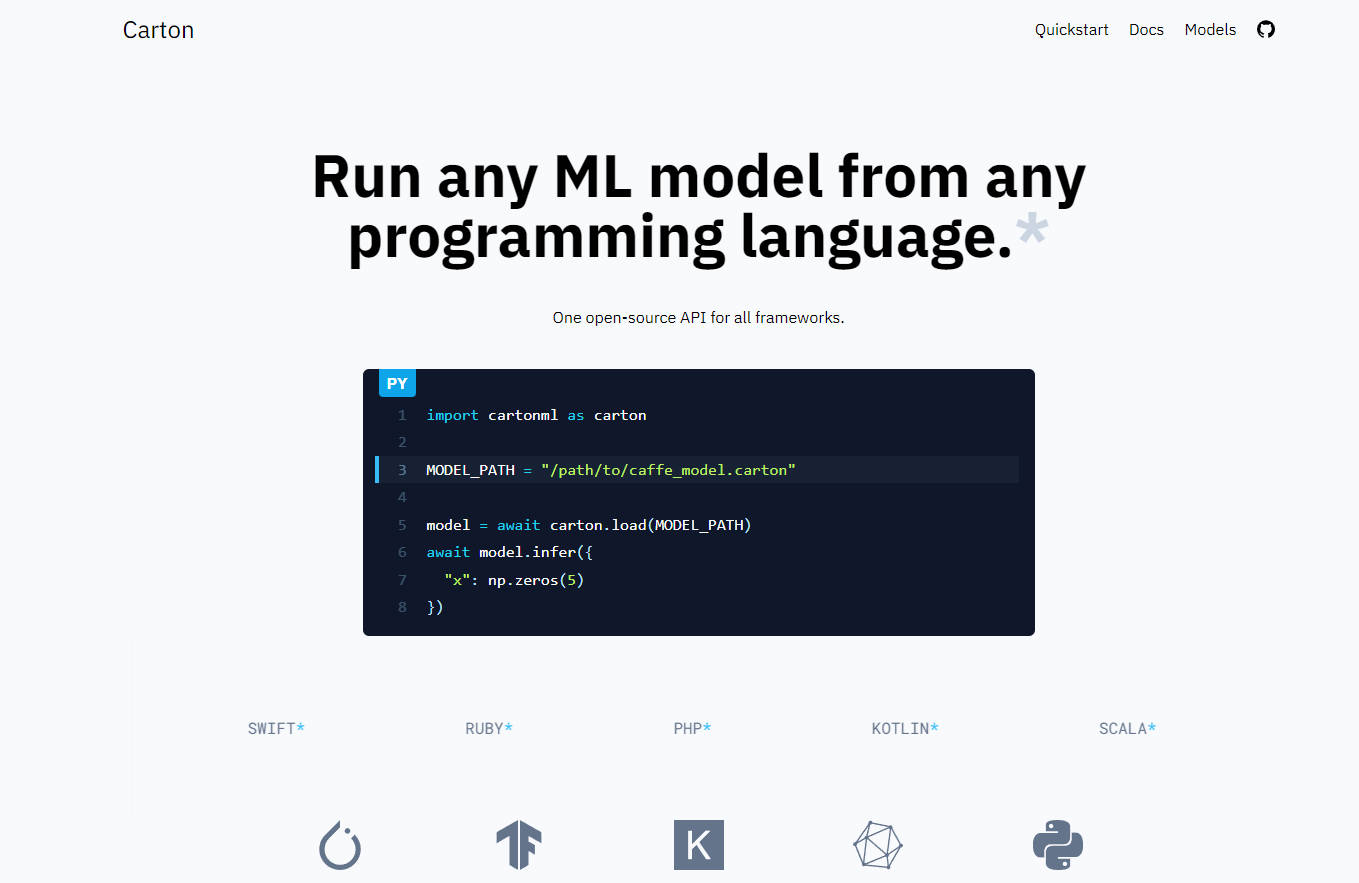

What is Carton?

Cartonは、ユーザーがすべてのプログラミング言語で機械学習(ML)モデルを実行することを可能にするソフトウェアです。特定のMLフレームワークから推論コードを切り離すことで、ユーザーは最先端のテクノロジーを簡単に把握できます。Cartonはオーバーヘッドが少なく、x86_64 LinuxとmacOS、aarch64 Linux、aarch64 macOS、WebAssemblyを含むさまざまなプラットフォームをサポートしています。

主な特徴:

-MLフレームワークの実装を切り離す:Cartonを使用することで、ユーザーはTorchやTensorFlowなどの特定のフレームワークに縛られることなくMLモデルを実行できます。

-オーバーヘッドが少ない:予備的なベンチマークでは、推論呼び出しあたりのオーバーヘッドが100マイクロ秒未満であることが示されています。

-プラットフォームサポート:Cartonは現在、x86_64LinuxとmacOS、aarch64 Linux、aarch64 macOS、WebAssemblyをサポートしています。

-変更なしでパッケージング:Cartonは、元のモデルとメタデータを含むパッキングステップの出力です。元のモデルを変更しないため、エラーを起こしやすい変換ステップを回避します。

-カスタム演算のサポート:Cartonでは、モデルを実行するために基になるフレームワーク(例:PyTorch)を使用するため、TensorRTなどのカスタム演算を簡単に変更せずに使用できます。

-将来のONNXサポート:CartonはONNXのようにモデルを変換するのではなくラップしますが、WASMでブラウザ内でモデルを実行するなど、興味深いユースケースを可能にするために、Carton内でONNXモデルをサポートする計画があります。

ユースケース:

1. 高速な実験:特定のフレームワークから推論コードを切り離し、変換ステップを減らすことで、CartonはさまざまなMLモデルをより迅速に実験できます。

2. デプロイメントの柔軟性:x86_64やaarch64などのさまざまなアーキテクチャでLinuxやmacOSを含むさまざまなオペレーティングシステムをサポートするプラットフォームサポートにより、Cartonはさまざまな環境にMLモデルをデプロイする柔軟性を提供します。

3. カスタム演算の統合:TensorRTなどのカスタム演算を使用する機能により、開発者は特定の要件に応じてMLワークフローを最適化しやすくなります。

4. ブラウザ内ML:ONNXモデルとWebAssemblyの将来のサポートにより、Cartonを使用してMLモデルをWebブラウザで直接実行できるようになり、機械学習機能を必要とするブラウザベースのアプリケーションの可能性が開かれます。