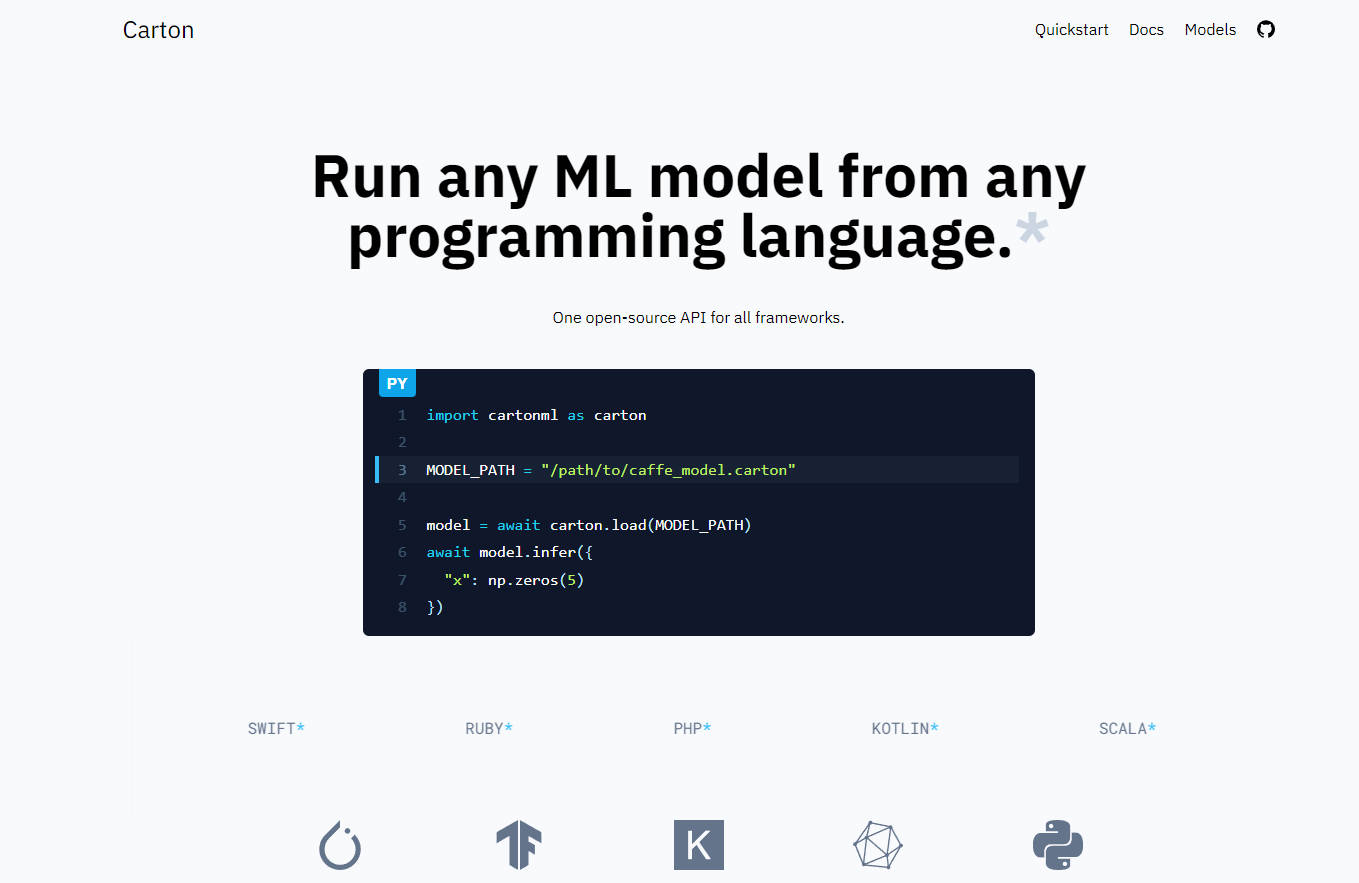

What is Carton?

Carton은 사용자가 어떤 프로그래밍 언어로든 기계 학습(ML) 모델을 실행할 수 있게 해주는 소프트웨어입니다. 이 소프트웨어는 추론 코드를 특정 ML 프레임워크에서 분리해 사용자가 최신 기술에 쉽게 대응할 수 있도록 해줍니다. Carton은 오버헤드가 적고 x86_64 Linux와 macOS, aarch64 Linux, aarch64 macOS, WebAssembly를 포함한 다양한 플랫폼을 지원합니다.

주요 특징:

- ML 프레임워크 구현 분리: Carton을 사용하면 Torch나 TensorFlow와 같은 특정 프레임워크에 구애받지 않고 ML 모델을 실행할 수 있습니다.

- 낮은 오버헤드: 예비 벤치마크에 따르면 추론 호출당 오버헤드는 100마이크로초 이하입니다.

- 플랫폼 지원: Carton은 현재 x86_64 Linux와 macOS, aarch64 Linux, aarch64 macOS, WebAssembly를 지원합니다.

- 수정 없이 패키징: Carton은 원래 모델과 메타데이터를 포함하는 패킹 단계의 출력입니다. 원래 모델을 수정하지 않아 오류가 발생하기 쉬운 변환 단계를 피할 수 있습니다.

- 사용자 지정 연산 지원: Carton은 기본 프레임워크(예: PyTorch)를 사용하여 모델을 실행하므로 TensorRT와 같은 사용자 지정 연산을 변경 없이 쉽게 사용할 수 있습니다.

- 향후 ONNX 지원: Carton은 ONNX처럼 모델을 변환하는 대신 모델을 래핑하지만 WASM으로 브라우저에서 모델을 실행하는 등의 흥미로운 사용 사례를 활용할 수 있도록 Carton 내에서 ONNX 모델을 지원할 계획입니다.

사용 사례:

1. 빠른 실험: Carton은 추론 코드를 특정 프레임워크에서 분리하고 변환 단계를 줄여 다양한 ML 모델을 사용한 빠른 실험을 가능하게 합니다.

2. 유연한 배포: Carton은 x86_64와 aarch64와 같은 다양한 아키텍처에서 Linux와 macOS를 포함한 다양한 운영 체제에 대한 플랫폼 지원을 제공하므로 여러 환경에 걸쳐 ML 모델을 유연하게 배포할 수 있습니다.

3. 사용자 지정 연산 통합: TensorRT와 같은 사용자 지정 연산을 사용할 수 있으므로 개발자는 특정 요구 사항에 따라 ML 워크플로우를 더 쉽게 최적화할 수 있습니다.

4. 브라우저 내 ML: 향후 ONNX 모델과 WebAssembly에 대한 지원을 통해 Carton을 사용하면 ML 모델을 웹 브라우저에서 직접 실행하여 기계 학습 기능이 필요한 브라우저 기반 애플리케이션의 가능성을 열어줄 수 있습니다.