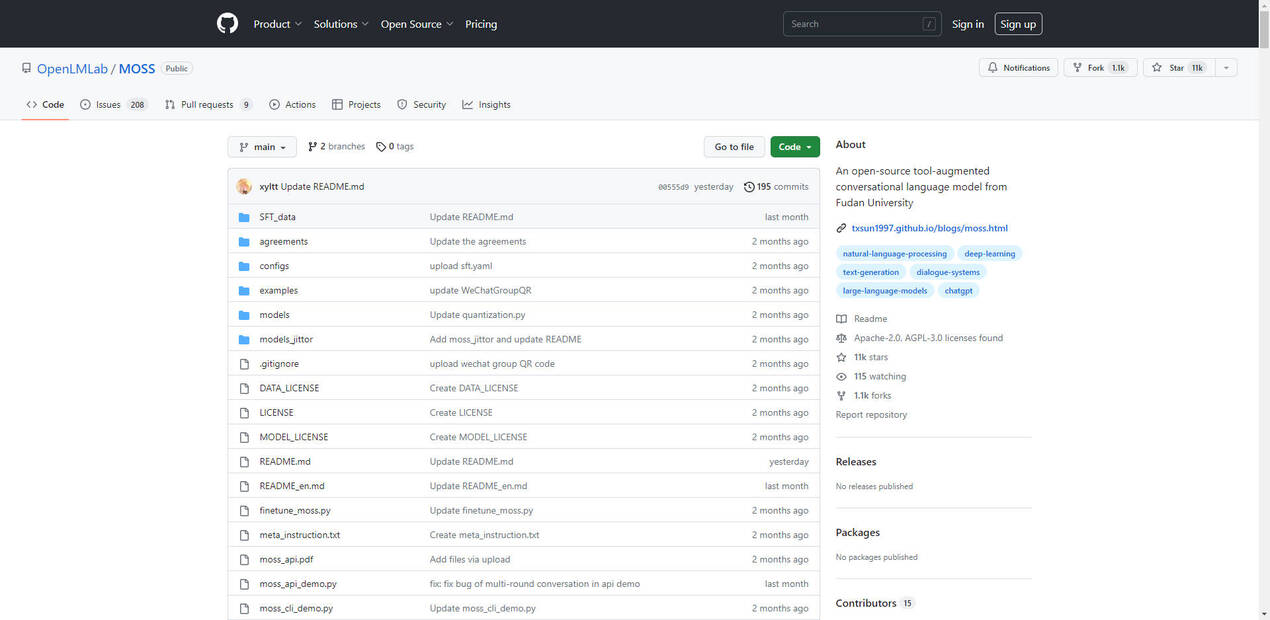

What is MOSS?

MOSS est un modèle de langage conversationnel avancé et open-source développé par l'Université Fudan. Il se distingue par ses capacités exceptionnelles en anglais et en chinois, ainsi que par son riche écosystème de plugins qui améliorent ses fonctionnalités. Avec un nombre impressionnant de 160 milliards de paramètres, les modèles de la série MOSS-Moon, comme moss-moon-003-sft, sont conçus pour offrir des performances exceptionnelles même sur un seul GPU A100/A800 ou deux GPU 3090, et avec une précision inférieure, comme INT4/8, il peut fonctionner sur un seul GPU 3090.

Fonctionnalités clés

Capacité bilingue : ? MOSS excelle à la fois en anglais et en chinois, facilitant une communication fluide au-delà des frontières linguistiques.

Prise en charge étendue des plugins : ? MOSS s'intègre de manière transparente à une variété de plugins, élargissant ses capacités pour inclure la recherche sur le web, le calcul, la génération d'images, et bien plus encore.

Utilisation efficace des ressources : ? Malgré sa taille massive de paramètres, MOSS est optimisé pour une utilisation efficace des ressources, garantissant un fonctionnement fluide même sur du matériel haut de gamme.

Sécurité et fiabilité : ?️ MOSS est conçu avec la sécurité à l'esprit, reconnaissant ses limites en matière de génération d'erreurs factuelles ou de contenu biaisé.

Personnalisable et évolutif : ? MOSS peut être facilement personnalisé et mis à l'échelle pour différents cas d'utilisation, ce qui en fait un outil polyvalent pour diverses applications.