What is Pruna AI?

Pruna AI est un moteur d'optimisation de l'IA conçu pour rendre vos modèles d'apprentissage automatique plus petits, plus rapides et plus rentables. Il utilise des techniques de compression avancées telles que l'élagage et la quantification, sans nécessiter de refonte importante. Pruna s'intègre parfaitement à votre pipeline ML, prend en charge divers matériels et propose des solutions gratuites et professionnelles pour les utilisateurs individuels et les équipes.

Fonctionnalités clés

Optimisation automatique des modèles? : Pruna analyse automatiquement votre modèle et applique les méthodes d'optimisation les plus efficaces, telles que l'élagage, la quantification et la compilation, rationalisant ainsi le processus et vous faisant gagner un temps précieux.

Compatibilité flexible et universelle? : Pruna s'intègre parfaitement à n'importe quel pipeline ML et prend en charge toutes les principales méthodes de compression, vous permettant de l'intégrer facilement à votre workflow existant, quel que soit votre framework ou matériel préféré.

Agnostique du matériel? : La polyvalence de Pruna s'étend à sa compatibilité matérielle, assurant des performances stables sur diverses plates-formes, des serveurs cloud aux périphériques de périphérie.

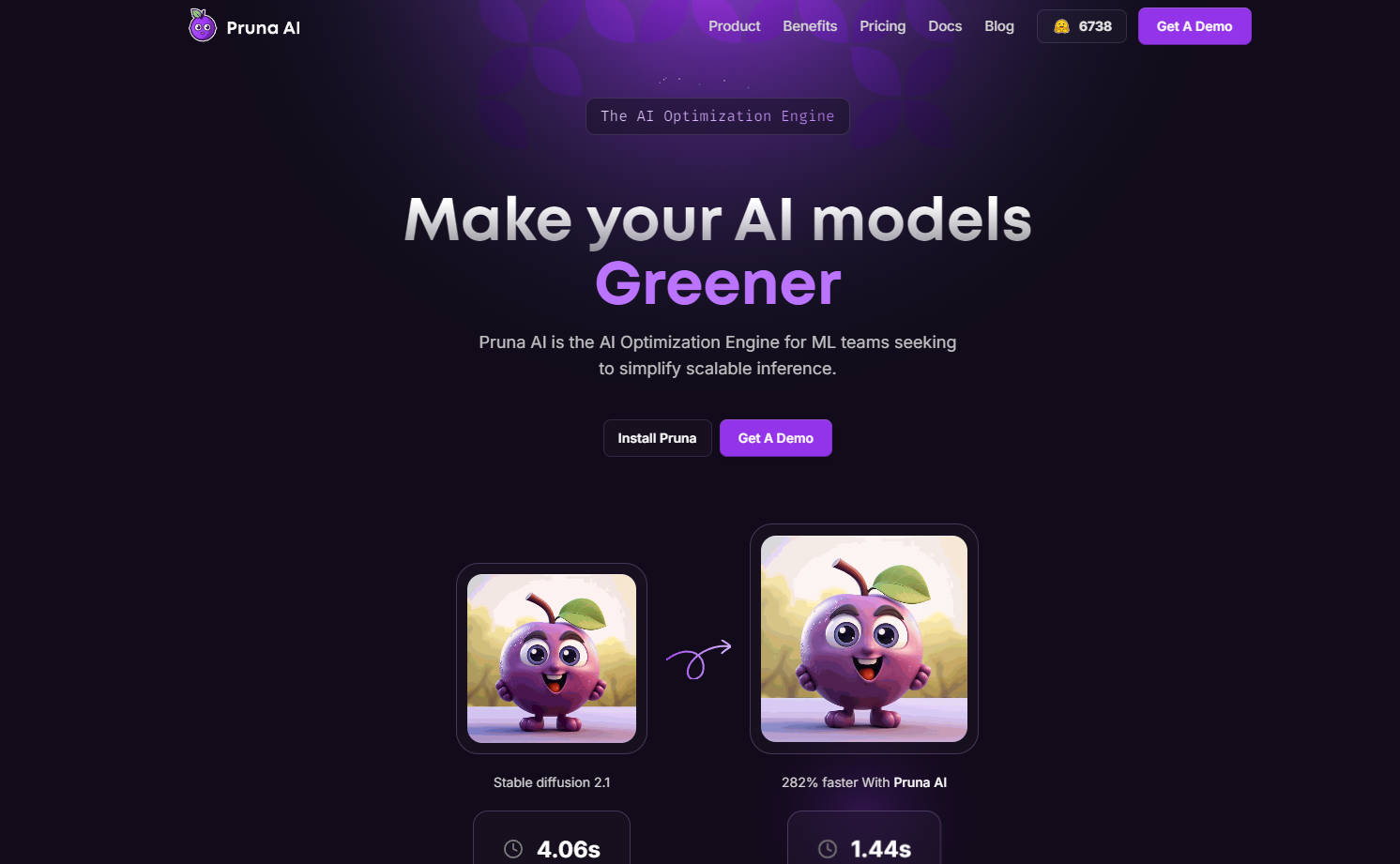

Amélioration significative des performances? : Pruna vous aide à obtenir des améliorations substantielles de la vitesse d'inférence et de la taille du modèle, vous permettant de déployer vos modèles de manière plus efficace et économique.

Réduction des coûts et de l'empreinte carbone? : En optimisant l'efficacité des modèles, Pruna réduit les frais généraux de calcul, ce qui entraîne une diminution des coûts de calcul dans le cloud et un impact environnemental moindre.

Cas d'utilisation

Déploiement d'un grand modèle linguistique (LLM) sur un appareil aux ressources limitées : Pruna peut compresser le LLM, lui permettant de fonctionner efficacement sur l'appareil sans sacrifier les performances.

Accélération de la vitesse d'inférence pour un modèle de vision par ordinateur dans une application en temps réel : Pruna peut optimiser le modèle pour un traitement plus rapide, permettant une détection d'objets ou une classification d'images plus rapide.

Réduction des coûts de calcul dans le cloud liés à l'exécution d'un modèle Stable Diffusion pour la génération d'images : Pruna peut compresser le modèle, minimisant ainsi les ressources informatiques nécessaires et réduisant les dépenses.

Conclusion

Pruna AI vous permet de libérer tout le potentiel de vos modèles d'IA en les optimisant pour l'efficacité. Grâce à son interface conviviale, à ses puissantes techniques d'optimisation et à son engagement en faveur de l'accessibilité, Pruna est la solution idéale pour les particuliers et les équipes souhaitant déployer des modèles d'IA performants de manière rentable et durable.

FAQ

1. Comment Pruna optimise-t-il les modèles ?

Pruna exploite une combinaison de techniques de pointe, notamment l'élagage, la quantification, la compilation et la mise en cache, pour réduire la taille du modèle et accélérer la vitesse d'inférence sans compromettre la précision.

2. Quels types de modèles Pruna prend-il en charge ?

Pruna est conçu pour optimiser un large éventail de modèles d'apprentissage automatique, notamment les LLM, les modèles de génération d'images et de vidéos, les modèles de vision par ordinateur et les modèles audio.

3. Pruna convient-il aux particuliers et aux entreprises ?

Oui, Pruna propose des solutions gratuites et professionnelles. La version gratuite est parfaite pour les utilisateurs individuels et les petites équipes, tandis que le plan entreprise offre des fonctionnalités avancées, notamment une assistance dédiée et des stratégies d'optimisation personnalisées, adaptées aux grandes organisations.

More information on Pruna AI

Top 5 Countries

Traffic Sources

Pruna AI Alternatives

Plus Alternatives-

-

Neutrino est un routeur IA intelligent qui vous permet d'obtenir des performances GPT4 à une fraction du coût en acheminant dynamiquement les invites vers le modèle le plus approprié, en trouvant un équilibre entre rapidité, coût et précision.

-

-

Kolosal AI est une plateforme open-source permettant aux utilisateurs d'exécuter des grands modèles de langage (LLM) localement sur des appareils tels que les ordinateurs portables, les ordinateurs de bureau et même les Raspberry Pi, en privilégiant la vitesse, l'efficacité, la confidentialité et le respect de l'environnement.

-

Boostez vos projets d'IA générative avec PeriFlow de FriendliAI. Moteur de service LLM le plus rapide, options de déploiement flexibles, approuvé par les leaders de l'industrie.