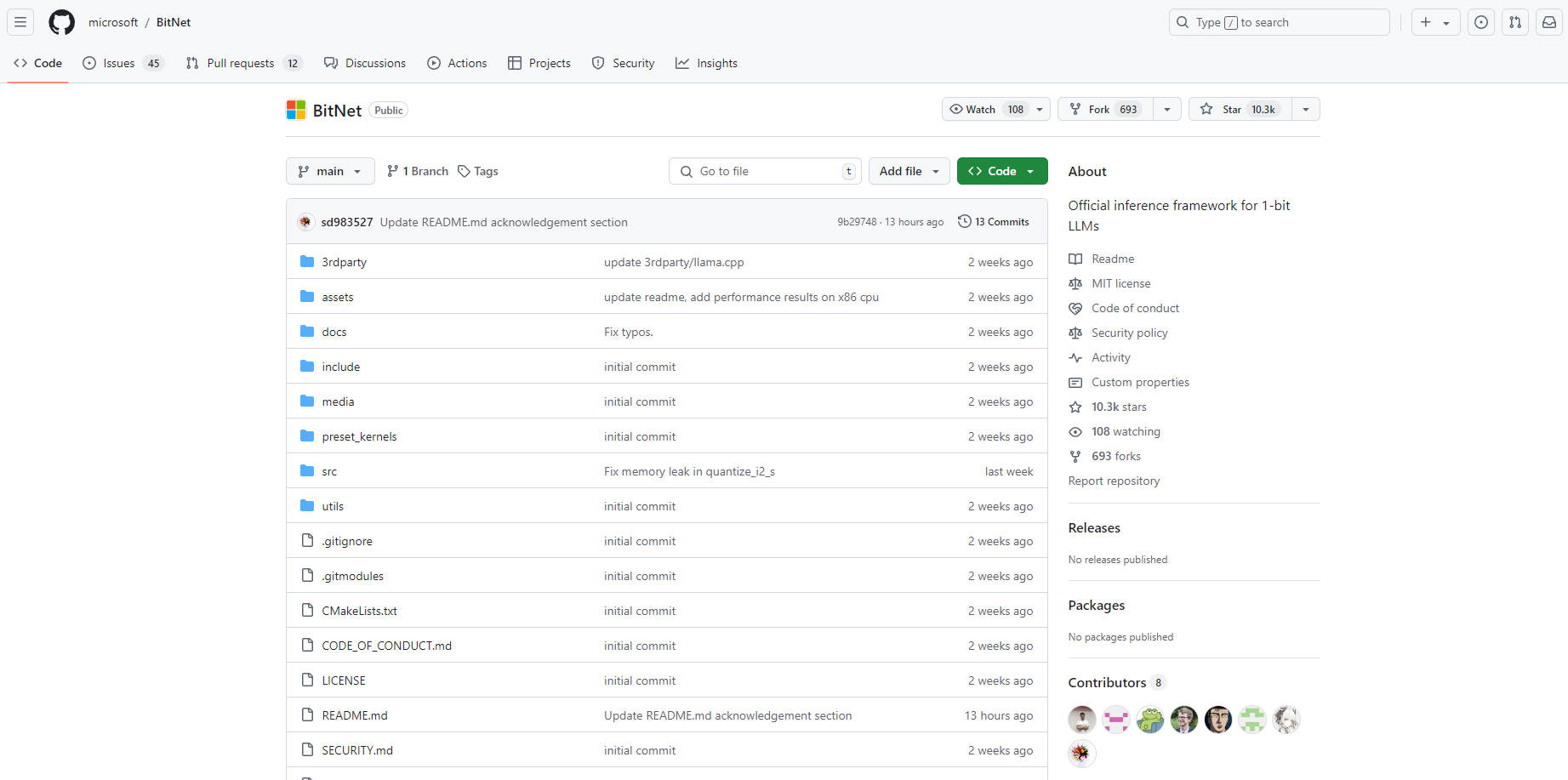

What is BitNet.cpp?

bitnet.cppは、BitNet b1.58のような1ビットの大規模言語モデル(LLM)向けに設計された画期的な推論フレームワークです。CPU(将来はNPUおよびGPUサポートを予定)で驚異的な速度と効率の向上を実現し、大規模なLLMであっても、人間の読書速度に匹敵する速度で単一のCPU上でローカルに実行できます。1ビットモデルに最適化することで、bitnet.cppは、ハードウェア要件とエネルギー消費を最小限に抑えながら、強力なAI機能へのアクセスを拡大します。

主な機能:

CPU中心の推論: ? GPUなどの特殊なハードウェアへの依存を排除し、CPU上で直接1ビットLLMを高速かつ効率的に実行できます。

速度向上: ? 標準的なLLM推論方法と比較して、ARM(1.37倍〜5.07倍)およびx86(2.37倍〜6.17倍)CPUの両方で大幅な速度向上を実現します。

エネルギー効率: ? エネルギー消費を55.4%〜82.2%削減し、環境にやさしいAI展開を促進します。

大規模モデルのローカル実行: ?️ ユーザーは、強力なサーバーやクラウドサービスを必要とせずに、標準的なCPU上で、100Bパラメータを超える大規模な1ビットLLMを実行できます。

ユースケース:

クラウド接続に依存せずに、個人のラップトップやモバイルデバイスでパーソナライズされたAIアシスタントを実行します。

インターネットアクセスが限られている地域で、オフラインの言語翻訳ツールを展開します。

研究者や開発者が、容易に入手可能なハードウェア上で大規模なLLMを自由に実験できるようにします。

結論:

bitnet.cppは、LLMをよりアクセスしやすく、持続可能なものにするための重要な進歩を表しています。効率的なCPUベースの推論を可能にすることで、幅広いデバイスに強力なAI機能を展開し、高価なインフラストラクチャへの依存を減らし、大規模言語モデルへのアクセスを拡大するための道を切り開きます。bitnet.cppは、LLM展開の風景を再構築し、新しい波のAIアプリケーションを可能にすることを約束します。