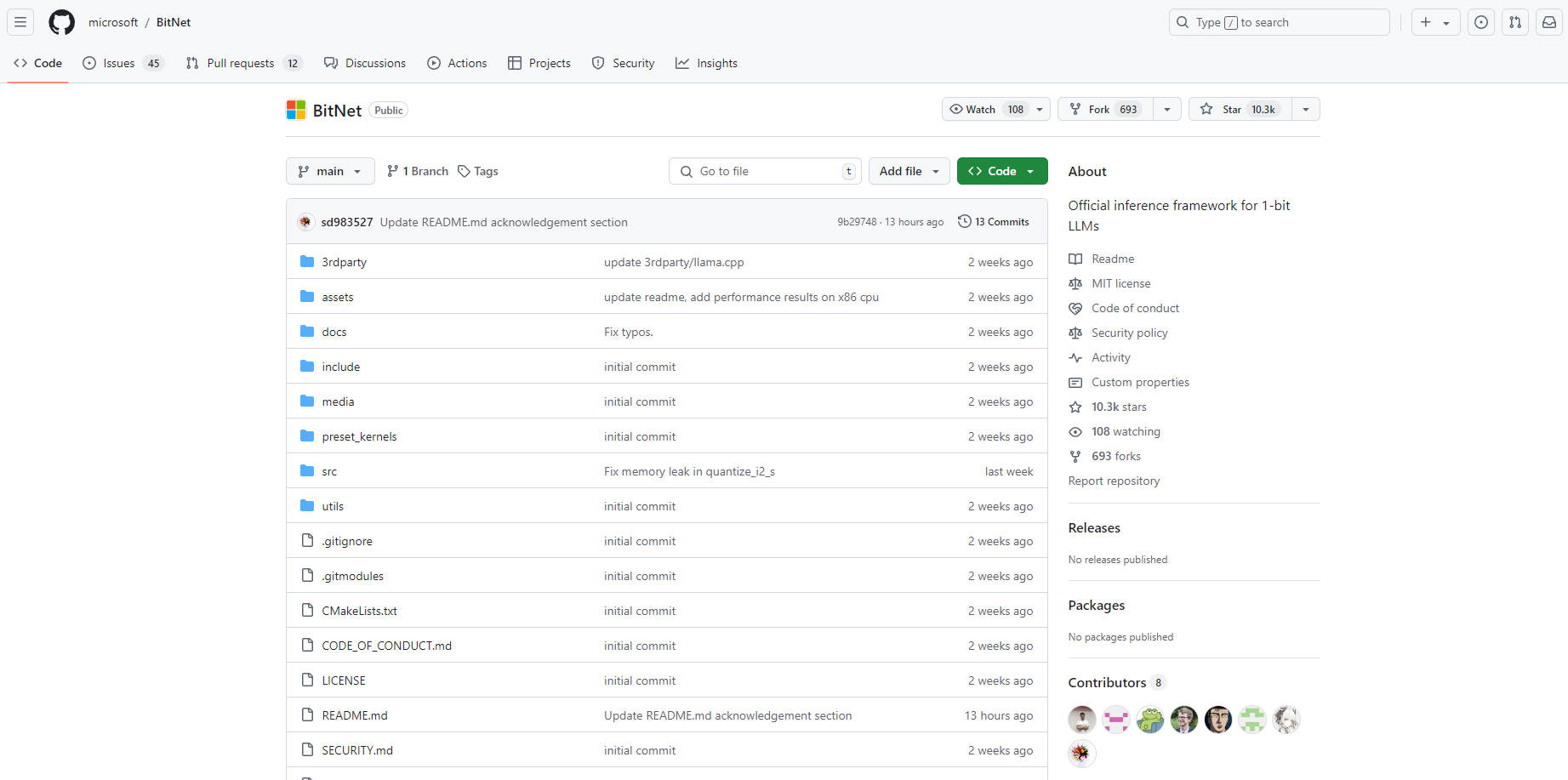

What is BitNet.cpp?

bitnet.cpp는 BitNet b1.58과 같은 1비트 대규모 언어 모델(LLM)을 위해 설계된 획기적인 추론 프레임워크입니다. CPU(향후 NPU 및 GPU 지원 계획)에서 놀라운 속도와 효율성 향상을 제공하여 대규모 LLM도 사람이 읽는 속도와 비슷한 속도로 단일 CPU에서 로컬로 실행할 수 있도록 합니다. 1비트 모델에 최적화된 bitnet.cpp는 하드웨어 요구 사항과 에너지 소비를 최소화하면서 강력한 AI 기능에 대한 더 넓은 접근성을 제공합니다.

주요 기능:

CPU 중심 추론: ? GPU와 같은 특수 하드웨어에 대한 의존성을 없애고 CPU에서 직접 1비트 LLM을 빠르고 효율적으로 실행할 수 있도록 합니다.

향상된 속도: ? 표준 LLM 추론 방법에 비해 ARM(1.37배 - 5.07배) 및 x86(2.37배 - 6.17배) CPU에서 상당한 속도 향상을 제공합니다.

에너지 효율성: ? 에너지 소비를 55.4%에서 82.2%까지 크게 줄여 친환경적인 AI 배포를 촉진합니다.

대규모 모델의 로컬 실행: ?️ 사용자가 강력한 서버나 클라우드 서비스 없이도 표준 CPU에서 100B개 이상의 매개변수를 가진 대규모 1비트 LLM을 실행할 수 있도록 합니다.

사용 사례:

클라우드 연결에 의존하지 않고 개인 랩톱이나 모바일 장치에서 개인화된 AI 어시스턴트를 실행합니다.

인터넷 접근이 제한적인 지역에서 오프라인 언어 번역 도구를 배포합니다.

연구자와 개발자가 쉽게 구할 수 있는 하드웨어에서 대규모 LLM을 실험할 수 있도록 지원합니다.

결론:

bitnet.cpp는 LLM을 더욱 접근 가능하고 지속 가능하게 만드는 데 있어 중요한 발전을 의미합니다. 효율적인 CPU 기반 추론을 해제함으로써 더 넓은 범위의 장치에 강력한 AI 기능을 배포하고 비싼 인프라에 대한 의존성을 줄이며 대규모 언어 모델에 대한 더 넓은 접근성을 촉진하는 길을 열어줍니다. bitnet.cpp는 LLM 배포 환경을 재편하고 새로운 AI 애플리케이션의 물결을 일으킬 것을 약속합니다.