What is FriendliAI?

构建和部署生成式AI模型无需再耗费巨资或降低效率。FriendliAI正是为此而生。无论您是初创企业、大型企业还是AI开发者,FriendliAI都提供尖端的生成式AI基础设施,能够加速推理、大幅降低GPU成本并简化部署。其核心是Friendli Engine,该平台提供突破性的性能,让您专注于创新,而繁重的工作则由它来处理。

主要功能

? 加速AI推理

Friendli Engine大幅提升生成式AI性能,吞吐量提升10.7倍,延迟降低6.2倍(相比竞争对手)。这意味着您的用户将获得更快的响应速度,您的团队也将拥有更流畅的操作体验。

? 节省高达90%的GPU成本

通过迭代批处理和原生量化等技术优化GPU使用,FriendliAI将所需的GPU数量减少了6倍,帮助您在不影响性能的情况下降低成本。

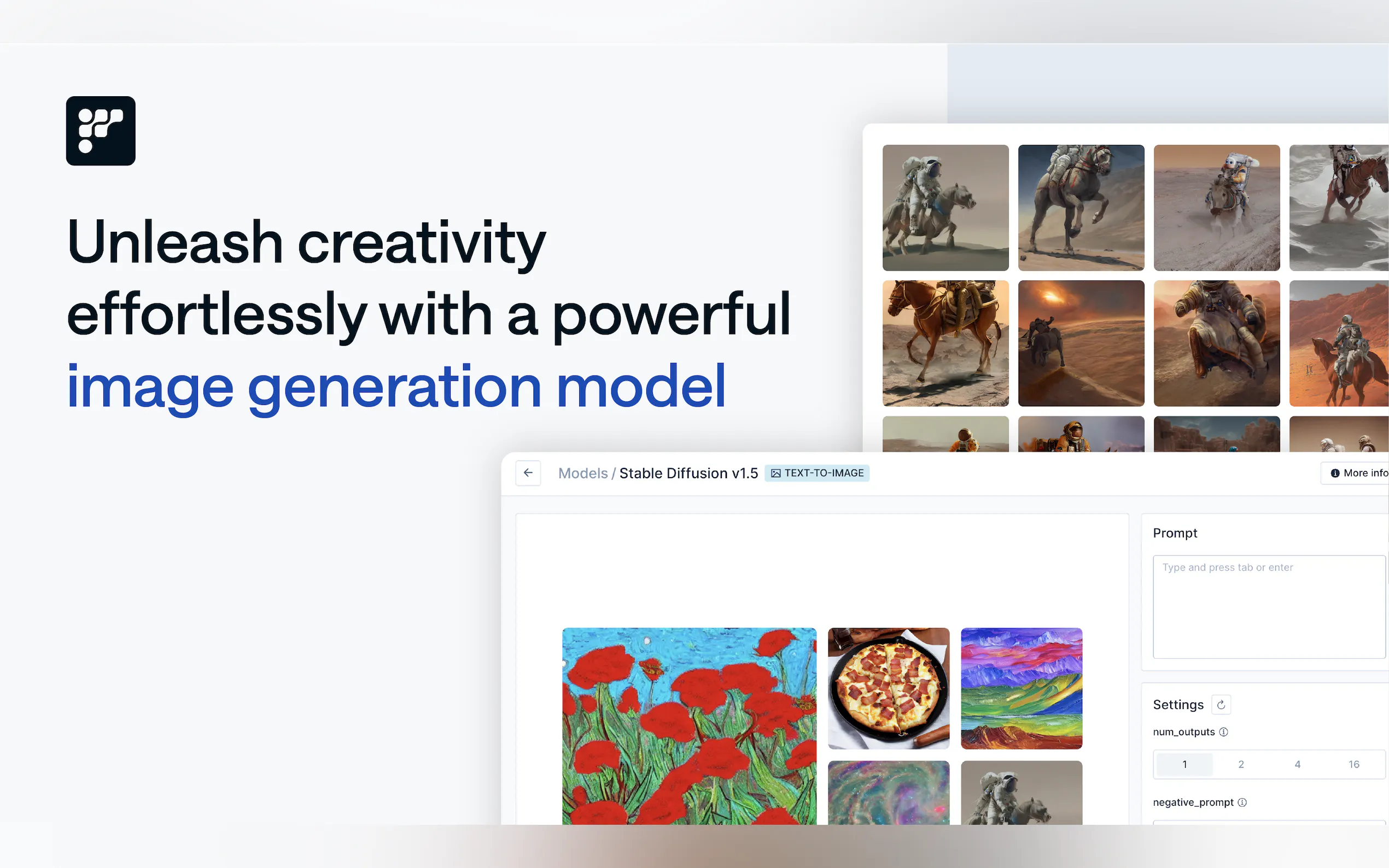

? 轻松部署自定义模型

您可以上传自己的模型,或从Hugging Face或Weights & Biases导入模型。使用参数高效微调 (PEFT) 进行微调,并使用Multi-LoRA进行部署——所有这些都可以在一个平台上完成。

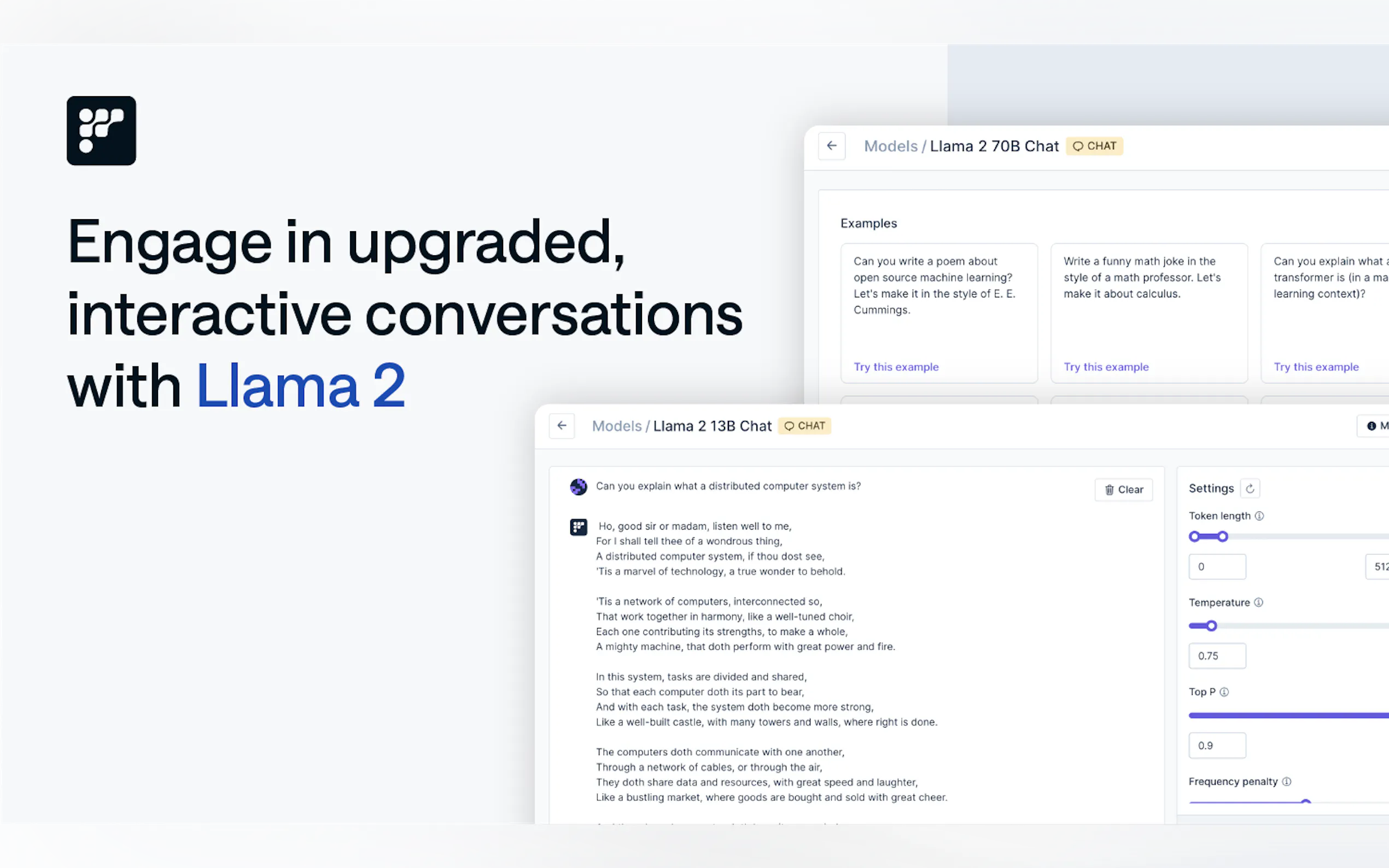

? 无缝实时RAG集成

通过检索增强生成 (RAG) 保持您的AI代理始终更新。集成预定义工具或添加您自己的工具,以构建强大的、上下文感知的AI系统。

? 最高安全性和合规性

无论您选择Friendli的云服务还是您自己的基础设施,您的数据都将得到安全保护。内置自动扩展功能可确保在高峰时段获得最佳性能,而专用的GPU资源则可保证一致的可靠性。

使用案例

个性化聊天机器人

NextDay AI使用Friendli Container将GPU成本降低了50%,同时每月处理0.5万亿个token。他们的聊天机器人现已跻身Andreessen Horowitz (a16z)评选的顶级20个生成式AI产品之列。企业级AI代理

韩国领先的电信运营商SK Telecom依靠Friendli Dedicated Endpoints来部署LLM,吞吐量提升5倍,成本降低3倍,同时保持严格的服务等级协议 (SLA)。实时AI应用

ScatterLab的“Zeta”应用程序(韩国青少年最受欢迎的十大移动应用程序之一)使用Friendli Container实时处理17倍的参数,提供快速可靠的响应。

为什么选择FriendliAI?

卓越性能:与vLLM等竞争对手相比,令token生成速度提升10倍,初始响应时间提升5倍。

灵活的部署:根据您的需求,可以选择Dedicated Endpoints、Container或Serverless Endpoints。

企业级:为关键任务应用程序提供保障的SLA、自动扩展和专用的GPU资源。

成本效益:在保持顶级性能的同时,将GPU成本降低高达90%。

常见问题

问:我可以在FriendliAI中使用自己的模型吗?

答:当然可以!您可以上传自定义模型,或从Hugging Face或Weights & Biases导入模型。使用PEFT进行微调,并使用Multi-LoRA进行部署。

问:FriendliAI如何降低GPU成本?

答:通过迭代批处理、原生量化和智能自动扩展等高级优化技术,FriendliAI最多可将所需的GPU数量减少6倍,从而节省高达90%的成本。

问:FriendliAI安全吗?

答:是的。无论您使用Friendli的云服务还是您自己的基础设施,强大的安全措施都能确保您的数据得到保护。

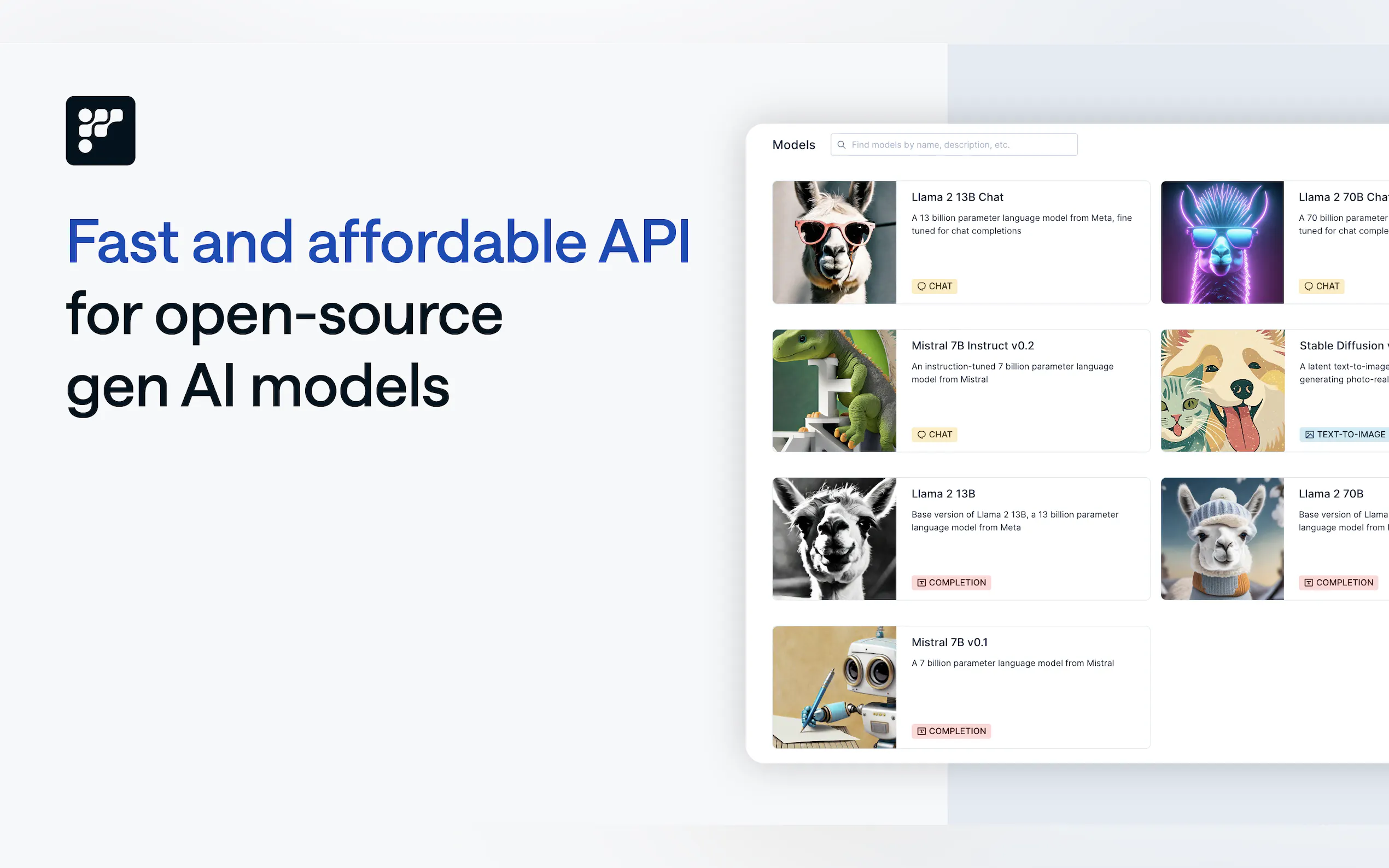

问:FriendliAI支持哪些模型?

答:FriendliAI支持100多种模型,包括Llama 3.1、Mixtral、Gemma等等。它也支持满足您需求的自定义模型。

准备好改变您的AI工作流程了吗?

FriendliAI不仅仅是一个平台,更是您构建和扩展生成式AI应用程序的合作伙伴。无论您是创建聊天机器人、AI代理还是实时RAG系统,FriendliAI都能提供无与伦比的性能、成本节约和易用性。

? 立即免费开始使用,了解FriendliAI如何提升您的生成式AI能力!