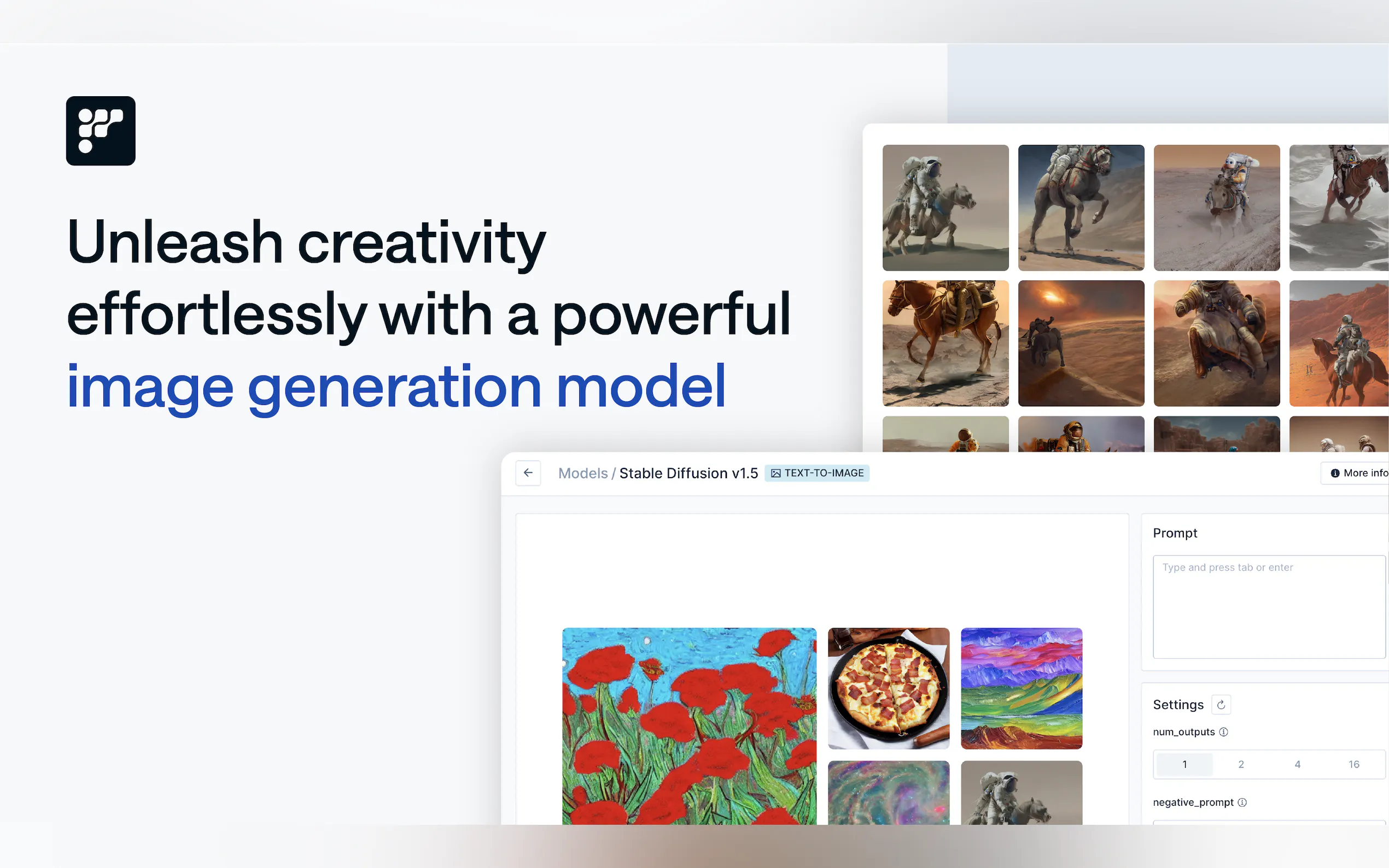

What is FriendliAI?

建置和部署生成式 AI 模型不該讓您傷荷包或拖慢速度。這就是 FriendliAI 的用武之地。無論您是新創公司、企業或 AI 開發人員,FriendliAI 都提供最先進的生成式 AI 基礎架構,能加速推論、大幅降低 GPU 成本並簡化部署。憑藉 Friendli Engine 作為核心,此平台提供突破性的效能,讓您專注於創新,而它則負責處理繁重的工作。

主要功能

? 加速 AI 推論

Friendli Engine 提升生成式 AI 效能,提供比競爭對手高出 10.7 倍的吞吐量和低 6.2 倍的延遲。這表示您的使用者能獲得更快速的回應,您的團隊也能享有更順暢的營運。

? 節省高達 90% 的 GPU 成本

透過迭代批次處理 (Iteration Batching) 和原生量化 (Native Quantization) 等技術優化 GPU 使用率,FriendliAI 將所需的 GPU 數量減少 6 倍,協助您降低成本,同時不損及效能。

? 輕鬆部署自訂模型

上傳您自己的模型,或從 Hugging Face 或 Weights & Biases 導入。使用參數效率微調 (Parameter-Efficient Fine-Tuning, PEFT) 微調模型,並使用 Multi-LoRA 服務進行部署——所有操作都在單一平台上完成。

? 無縫即時 RAG 整合

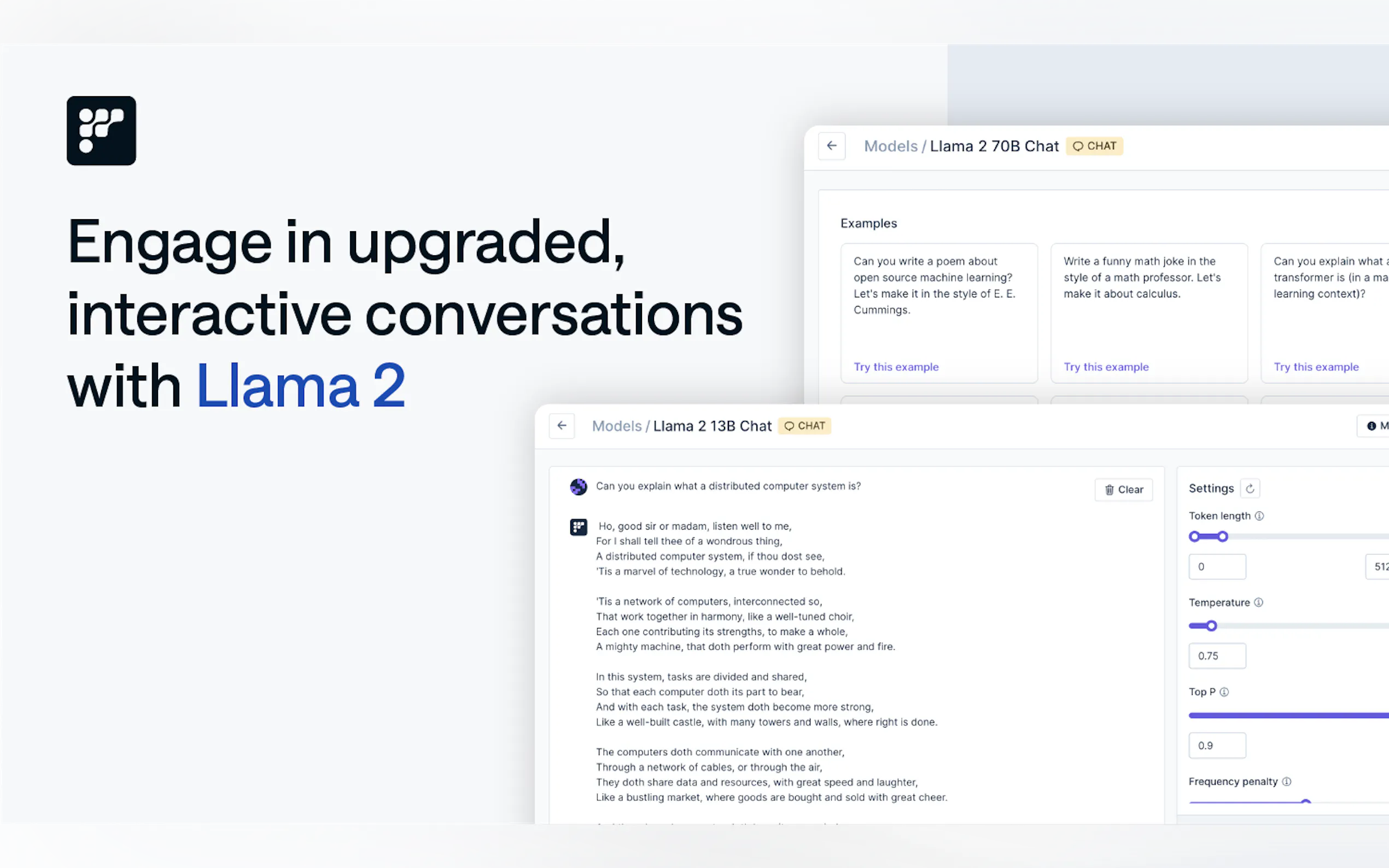

透過檢索增強式生成 (Retrieval-Augmented Generation, RAG) 使您的 AI 代理程式保持最新狀態。整合預定義工具或新增您自己的工具,以建構功能強大且具備情境感知能力的 AI 系統。

? 最高安全性與合規性

無論您選擇 Friendli 的雲端或您自己的基礎架構,您的數據都能保持安全。內建自動擴展功能確保在尖峰時段獲得最佳效能,而專屬 GPU 資源則保證一致的可靠性。

使用案例

個人化聊天機器人

NextDay AI 使用 Friendli Container 將 GPU 成本降低 50%,同時每月處理 0.5 兆個 Token。他們的聊天機器人現在已名列 Andreessen Horowitz (a16z)評選的頂尖 20 個生成式 AI 產品之列。企業級 AI 代理程式

南韓領先的電信業者 SK Telecom 依靠 Friendli Dedicated Endpoints 來部署大型語言模型 (LLM),吞吐量提高 5 倍,成本節省 3 倍,同時維持嚴格的服務等級協議 (SLA)。即時 AI 應用程式

ScatterLab 的「Zeta」應用程式是南韓青少年最常用的十大行動應用程式之一,它使用 Friendli Container 即時處理 17 倍以上的參數,提供快速可靠的回應。

為什麼選擇 FriendliAI?

經證實的效能:與 vLLM 等競爭對手相比,達成快 10 倍的 Token 生成速度和快 5 倍的初始回應時間。

彈性部署:從 Dedicated Endpoints、Container 或 Serverless Endpoints 中選擇,以符合您的需求。

企業級準備:享有保證的服務等級協議 (SLA)、自動擴展和專屬 GPU 資源,適用於關鍵任務應用程式。

成本效益:在維持頂級效能的同時,將 GPU 成本降低高達 90%。

常見問題

問:我可以在 FriendliAI 中使用自己的模型嗎?

答:當然可以!您可以上傳自訂模型,或從 Hugging Face 或 Weights & Biases 導入。使用 PEFT 微調模型,並使用 Multi-LoRA 服務進行部署。

問:FriendliAI 如何降低 GPU 成本?

答:透過迭代批次處理、原生量化和智慧型自動擴展等進階最佳化技術,FriendliAI 將所需的 GPU 數量減少高達 6 倍,讓您節省高達 90% 的成本。

問:FriendliAI 安全嗎?

答:是的。無論您使用 Friendli 的雲端或您自己的基礎架構,強大的安全措施都能確保您的數據受到保護。

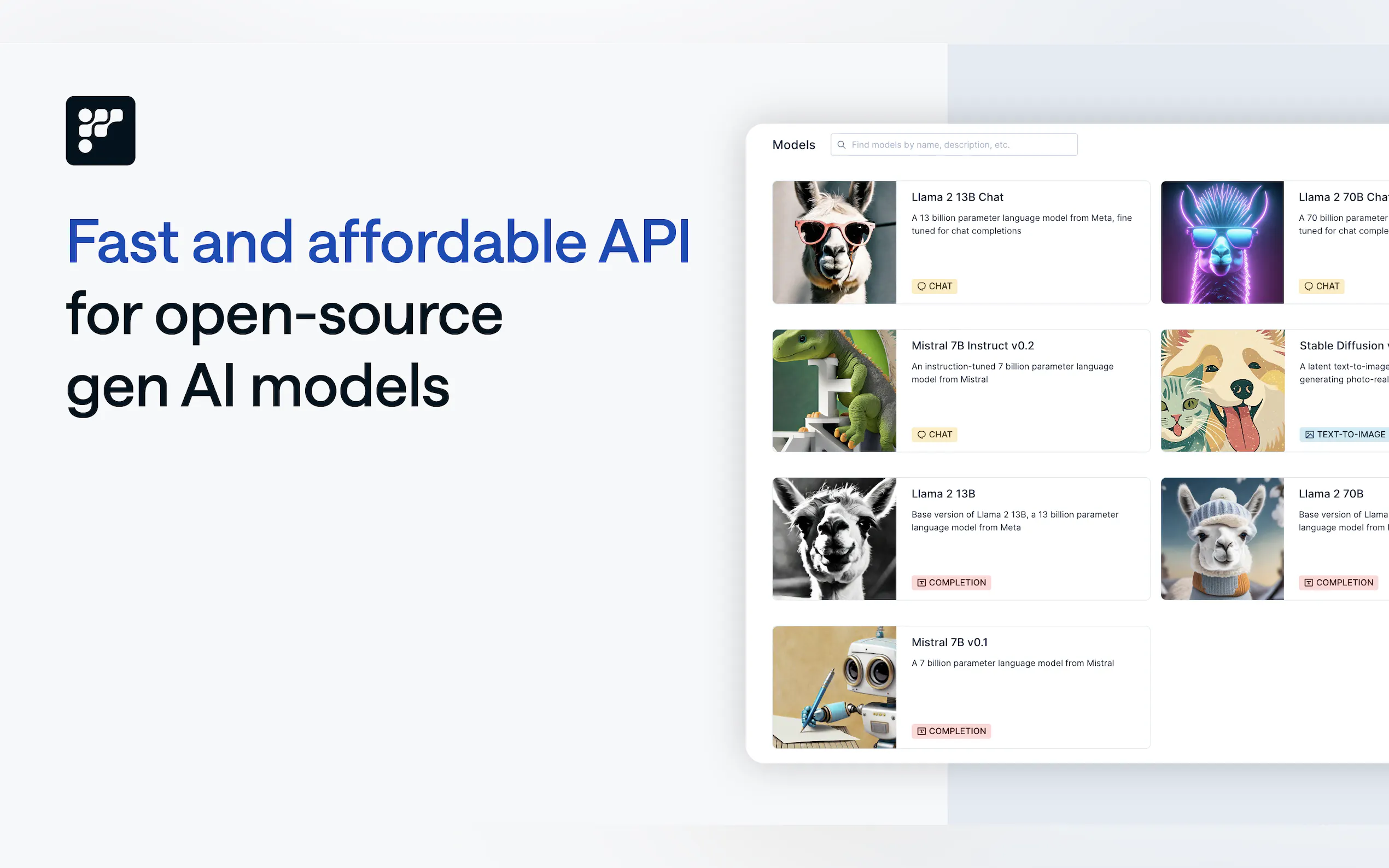

問:FriendliAI 支援哪些模型?

答:FriendliAI 支援 100 多種模型,包括 Llama 3.1、Mixtral、Gemma 等,也支援符合您需求的自訂模型。

準備轉變您的 AI 工作流程?

FriendliAI 不僅僅是一個平台,更是您建置和擴展生成式 AI 應用程式的合作夥伴。無論您是建立聊天機器人、AI 代理程式或即時 RAG 系統,FriendliAI 都能提供無與倫比的效能、成本節省和易用性。

? 免費開始使用,看看 FriendliAI 如何提升您的生成式 AI 成效!