What is Chorus ?

Chorus 是一款專為 Mac 設計的原生應用程式,旨在整合並提升您的整個 AI 工作流程。它透過在一個高效能的環境中提供對所有最新 AI 模型的即時、統一存取,消除了在諸如 ChatGPT、Claude 等獨立平台和專用工具之間來回切換的困擾。專業人士、研究人員和開發者將享有完整的情境掌控、深度工具整合,並能獨特地同時利用多種 AI 觀點,從而加速分析並確保輸出品質。

關鍵功能

Chorus 專為進階使用者量身打造,滿足他們對 AI 互動的效率、深度情境和多功能性需求。

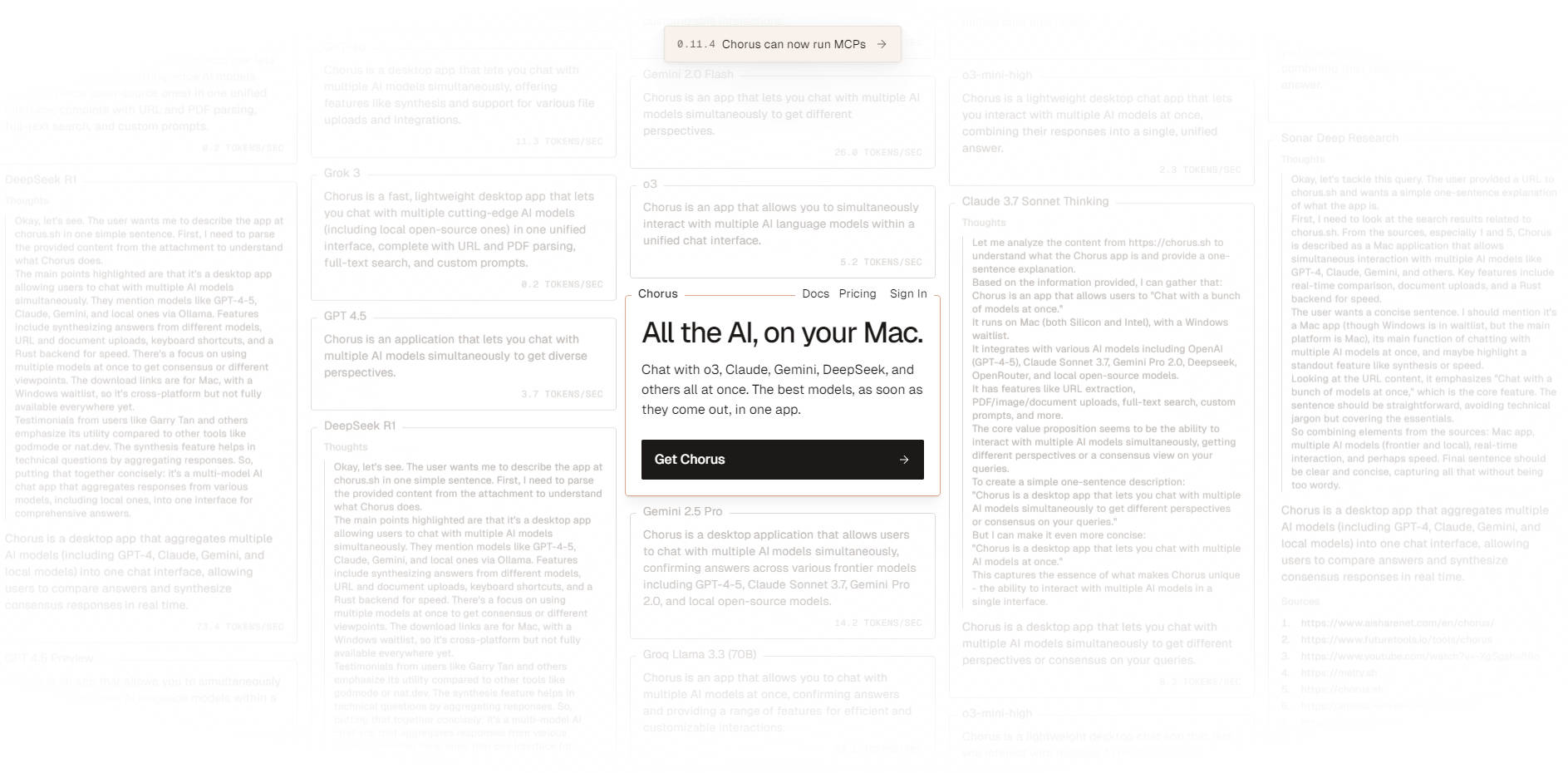

🤖 多模型同時回應

您可以選擇多個 AI 模型(例如 Claude Opus、GPT 4.1 和 Gemini 2.5 Pro)同時回應您的提示。這項功能對於即時比較分析至關重要,它讓您能夠收集多樣化的見解,即時發現不一致或潛在的幻覺,並在無需逐一測試的情況下,對生成的結果獲得更高的信心。

🧠 專案深度情境與記憶

利用 專案 來組織複雜的工作流程。您可以定義一個持續的情境欄位(包含 PDF 檔案、圖片或連結),此欄位會自動新增到該專案中的每一次聊天。此外,啟用 專案記憶 可自動從進行中的對話中提取並分享關鍵資訊,確保所有未來的聊天都能維護一個最新且共享的知識庫。

🖥️ 環境聊天與視覺模式

使用可配置的 Ambient Chat 快捷鍵(預設:Option + Space),在任何應用程式中即時存取 AI。這項不中斷作業的功能,讓您在處理其他應用程式時也能快速獲得答案。啟用後,視覺模式 可以在每條訊息中包含您目前螢幕的截圖,從而實現精確且情境感知的協助,而無需您切換視窗。

🛠️ 廣泛的工具與附件整合

讓您的 AI 能夠存取整合工具,包括網路搜尋、終端機指令、圖像生成(透過 OpenAI 的 gpt-image-1 模型)以及 GitHub 管理。您還可以透過拖放檔案(包含 PDF 檔案、圖片和文字文件)或貼上連結,無縫地新增附件,Chorus 會自動讀取內容以作為 AI 回應的依據。

🌐 本地與自訂模型支援

Chorus 讓您能夠超越標準雲端 API 的限制,將透過 Ollama 或 LMStudio 執行的本地模型直接整合到 Chorus 介面中。對於進階使用者和企業需求,Chorus 支援透過本地或遠端 MCP(Multi-Cloud Platform)伺服器使用自訂工具,實現客製化的工作流程自動化和安全性。

使用情境

Chorus 能在各種複雜的專業情境中最大化您的生產力:

深度研究與比較分析: 將一份複雜的研究報告(PDF)拖放到專案中,然後將情境定義為「批判性分析」。同時向強大模型(如 Claude Opus)查詢以獲取深度見解,並向輕量模型(如 Gemini 2.5 Flash)查詢以獲取快速摘要。並排顯示的回應和持續的情境,可節省數小時的手動交叉參考時間。

情境感知軟體開發: 啟動一個「開發」專案,上傳關鍵架構圖,並設定詳細說明您的技術堆疊的情境(例如:「Tauri 2.0 和 Typescript 前端,Elixir Phoenix API」)。AI 隨後可以使用整合的 Terminal 和 GitHub 工具,根據持續的專案記憶和情境來診斷程式碼問題、管理儲存庫並生成相關的程式碼片段。

流暢、不中斷的工作流程: 在試算表中審閱財務報告時,使用 Ambient Chat 和 Vision Mode,向 AI 詢問關於螢幕上特定資料集的高階問題。AI 接收視覺情境並立即提供明智的答案,讓您能夠專注於報告而無需離開。

Chorus 的獨特優勢

Chorus 從頭開始建構,旨在解決現代 AI 使用的核心挑戰,提供獨特的功能優勢:

原生 Mac 效能: 作為一個專用的原生應用程式,Chorus 提供高度響應、流暢的使用者體驗,並與 macOS 功能無縫整合,與基於網路的介面相比,提供卓越的效能和穩定性。

即時比較分析: Chorus 獨特地設計旨在消除依序測試。透過讓您能夠從多個模型接收同時回應,您將獲得一個即時、可靠的機制,用於識別最可靠的答案並驗證不同 AI 架構之間的事實。

獨立情境管理(執行緒): 在複雜、多層次的對話中保持清晰。利用 執行緒 在獨立的情境中提出精確的追蹤問題或精煉特定模型的回應,確保這些調整不會污染主聊天的情境,並保持對話流程的準確性。

無與倫比的模型多樣性: 原生存取來自 6 個不同提供者的 17 個模型,透過 Ollama 和 LMStudio 整合本地模型,並透過 OpenRouter 連接到數百個更多模型,所有這些都從單一介面進行管理。

結論

Chorus 將零散的 AI 世界轉變為在您的 Mac 上一個單一、連貫且強大的工作流程環境。透過整合先進的情境管理、深度工具存取和同時查詢模型的效率,Chorus 是對於認真利用現代 LLM 全部潛力的專業人士而言,不可或缺的生產力工具。